在文本到图像生成中,如何让模型“不生成某样东西”——例如“一只没有翅膀的鸟”或“一辆没有轮子的自行车”——始终是一个挑战。尽管正向提示可以引导生成内容,但负提示(negative prompt)的执行往往不尽如人意:要么无效,要么适得其反,甚至强化了本应避免的概念。

- 项目主页:https://vsf.weasoft.com

- GitHub:https://github.com/weathon/VSF

- Demo:https://huggingface.co/spaces/weathon/VSF

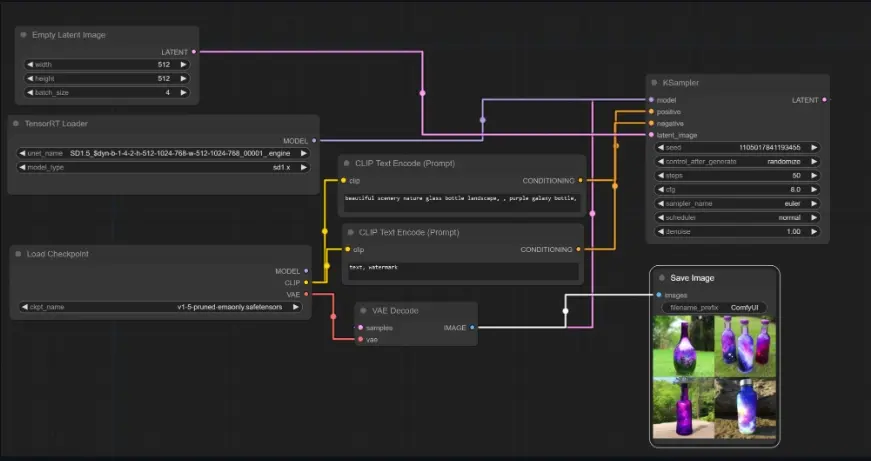

- ComfyUI节点:https://github.com/weathon/VSF/tree/main/comfyui

不列颠哥伦比亚大学(UBC)的研究团队近期提出了一种名为 Value Sign Flip (VSF) 的新方法,以极低的计算开销,在少步甚至单步生成模型中实现了更准确、更稳定的负提示控制。该方法已在 Stable Diffusion 3.5 Turbo、Flux 和 Wan 等先进模型上验证有效,支持静态图像与视频生成任务。

问题背景:负提示为何难以奏效?

在当前主流扩散模型中,负提示通常通过无分类器引导(Classifier-Free Guidance, CFG)机制实现:模型分别基于正提示和负提示生成两个噪声预测,再通过加权差值进行修正。然而,这种方法存在明显局限:

- 效果有限:对于复杂语义(如“无刹车的自行车”),CFG 往往无法彻底抑制目标特征;

- 副作用明显:过度增强负引导可能导致图像质量下降或语义扭曲;

- 依赖强引导强度:需手动调参,易导致“负提示反向激活”——即模型反而更关注被否定的内容。

已有改进方法如 NASA、NAG 虽有所提升,但仍依赖复杂架构修改或额外训练,难以广泛部署。

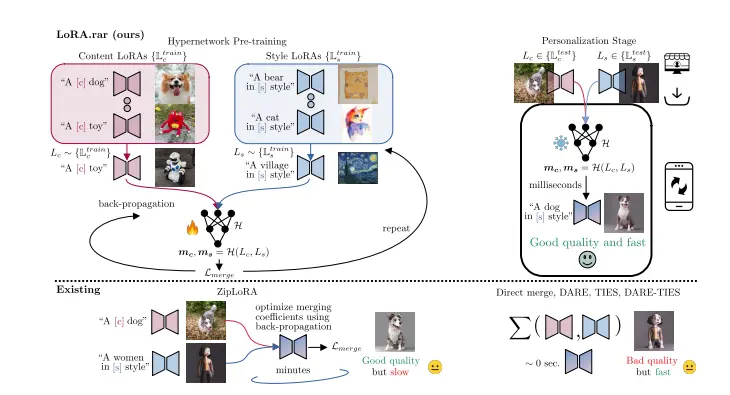

VSF:用“符号翻转”实现轻量级负提示控制

VSF(Value Sign Flip) 的核心思想简洁而有力:

在注意力机制中,动态翻转负提示对应值向量(value)的符号,从而抵消其对生成结果的影响。

这种方法不依赖重新训练,也不改变模型结构,仅需在推理时对注意力计算做微小调整,即可显著提升负提示遵循能力。

工作原理:四步实现精准抑制

VSF 在跨注意力层中引入以下四个关键设计:

1. 值向量符号翻转

将正提示与负提示的键(key)和值(value)拼接输入注意力层,但对负提示的 value 乘以一个负系数 -α:

[Q] → Attention → Output

[K_pos, K_neg]

[V_pos, -α × V_neg]这样,当查询(query)关注负提示区域时,其响应会被反向加权,从而削弱甚至消除该特征的生成倾向。

2. 注意力掩码 + 嵌入复制

为防止符号翻转影响后续 MLP 层的语义表达,VSF 采用双路径嵌入复制策略:

- 一份用于注意力计算(翻转 value)

- 一份保持原始语义(用于后续前馈网络)

并通过注意力掩码隔离正负提示之间的干扰,确保正提示不受污染。

3. 引入负注意力偏置(-β)

在图像 token 到负提示 token 的注意力路径上添加一个可学习或固定的负偏置 -β,进一步降低模型对负提示的关注度,减少“无意激活”的风险。

4. 去除填充标记(Padding Removal)

自动识别并移除负提示中的填充符号(padding tokens),避免这些无意义标记参与注意力计算,提升引导效率。

主要优势

| 特性 | 说明 |

|---|---|

| ⚡ 极低开销 | 无需额外训练,仅增加少量推理计算,适用于少步甚至单步生成 |

| 🔧 即插即用 | 兼容基于 MMDiT 和跨注意力架构的模型(如 SD3.5、Wan) |

| 🎯 精准控制 | 动态调节引导强度,避免过度抑制或语义漂移 |

| 🚫 防止反向激活 | 显著降低“越否定越出现”的问题,提升负提示可靠性 |

| 📽️ 支持视频生成 | 已在 Wan 模型上实现 480p 视频生成(81帧),全程仅需约30秒 |

实验结果:优于现有方法

研究团队在包含复杂正负提示对的挑战性数据集上进行了定量与定性评估,使用多模态大模型(MLLM)自动评分生成图像对提示的遵循程度。

定量对比(分数越高越好)

| 方法 | 正提示遵循 | 负提示遵循 | 图像质量 |

|---|---|---|---|

| NAG | 1.00 | 0.32 | 0.90 |

| NAG++ | 0.99 | 0.45 | 0.87 |

| VSF(本方法) | 0.96 | 0.70 | 0.88 |

📌 关键发现:

- VSF 在负提示遵循上大幅领先(0.70 vs. NAG 的 0.32),提升超过一倍;

- 同时保持了接近最优的正提示遵循能力与图像质量;

- 表明其在“抑制不需要内容”与“保留期望内容”之间取得了更好平衡。

定性案例:真实场景表现

案例 1:没有刹车的自行车

- 正提示:一辆复古风格的木制自行车,停在森林小径上

- 负提示:刹车

- 结果:NAG 仍生成明显刹车结构,而 VSF 成功避免了相关部件

案例 2:没有翅膀的喷气式飞机

- 正提示:一架未来主义风格的喷气式飞机,悬浮在城市上空

- 负提示:翅膀

- 结果:NAG 输出仍具翼状结构,VSF 生成无翼飞行器,更符合指令

视频生成演示(Wan 2.1 14B)

所有视频均在 6 步内生成,使用 lightx2v LoRA 微调。

场景一:宇航员从蛋中孵化

- 正提示:宇航员从蛋中孵化,在月球表面,背景展现太空的深邃与黑暗。高品质,超现实细节,电影级镜头。

- 负提示:美国国旗,低质量,模糊,失真,低分辨率,不自然运动,不自然光线

👉 VSF 成功避免了国旗出现,同时保持流畅动作与高质量光影。

场景二:去除星空元素

- 负提示:天空中的星星

👉 VSF 有效抑制星点分布,生成纯黑背景的太空场景,而基线方法仍残留明显星光。

🛠️ 兼容性与部署

VSF 目前已成功集成于以下模型架构:

- Stable Diffusion 3.5 Turbo(MMDiT 架构)

- Wan 2.1(支持 1.3B 至 14B 多尺寸)

- Flux

✅ 无需模型重训,仅需在推理阶段修改注意力模块即可启用。

适用场景包括:

- 高精度内容控制(如艺术创作、广告设计)

- 敏感内容过滤(避免生成违规元素)

- 科研可视化(排除干扰变量)

- 视频生成中的动态约束控制

相关文章

![FLUX LoRA Lab:可以混合和组合多个 FLUX[dev] LoRAs的在线生图应用](https://pic.sd114.wiki/wp-content/uploads/2024/10/1729432205-LoRA-Lab-1.webp~tplv-o4t1hxlaqv-image.image)