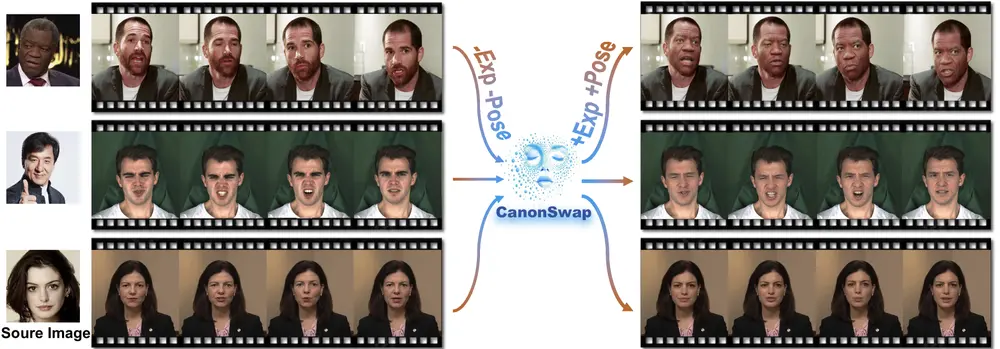

在AI与计算机视觉领域,视频人脸交换(Video Face Swapping)是一项极具挑战性的任务。它不仅要将一个人的身份特征“移植”到另一段视频中,还要保持目标人物的表情、动作和口型等动态信息不变,确保最终效果自然、真实、连贯。

近期,来自清华大学深圳国际研究生院、国际数字经济学院以及西安交通大学的研究团队提出了一种新的视频人脸交换框架——CanonSwap,有效解决了当前方法在身份转移与动态保留之间的平衡难题。

什么是 CanonSwap?

CanonSwap 是一种新型的视频人脸交换框架,旨在解决以下两个核心问题:

- 高效地将源身份迁移到目标视频中;

- 准确保留目标视频中的面部动态属性,如头部姿态、表情变化、唇部动作等。

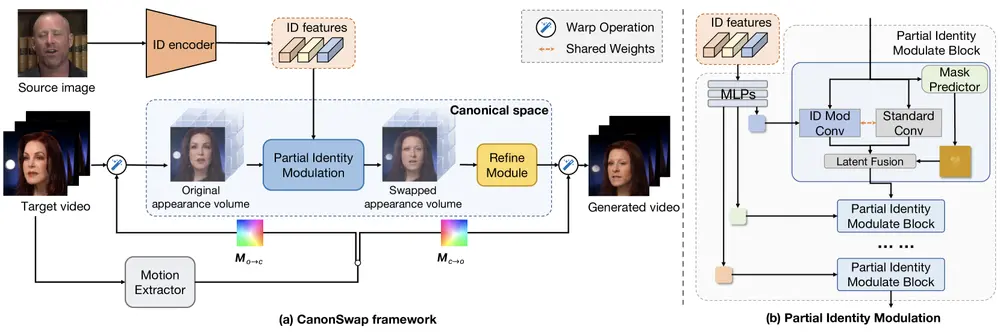

研究人员认为,现有方法之所以在动态一致性方面表现不佳,是因为面部外观与动作信息是高度耦合的。为此,CanonSwap 引入了规范空间变换(Canonical Space Transformation)机制,将动作信息与外观信息进行解耦,从而实现在统一空间中进行更精准的身份替换。

核心功能亮点

✅ 高保真身份替换

能够将源图像的身份特征精确地传递到目标视频中,保留源人物的面部特征(如五官形状、肤色等),实现逼真的视觉效果。

✅ 动态属性保留

在替换过程中,CanonSwap 能够完整保留目标视频中的表情、头部动作和口型变化,使结果更加自然生动。

✅ 时间一致性保障

生成的视频在时间维度上稳定,避免传统方法常见的闪烁、抖动等问题,提升观感质量。

✅ 可拓展至面部动画生成

除了人脸交换,该方法还可用于生成目标人物模仿源视频中表情或动作的动画效果,具备广泛的应用潜力。

技术原理详解

CanonSwap 的处理流程可分为以下几个关键步骤:

1️⃣ 动作信息提取

使用运动提取器从目标视频中提取面部动作信息,包括头部姿态、表情变化和口型等动态特征。

2️⃣ 映射到规范空间

将每一帧的人脸从原始空间映射到一个统一的“规范空间”,在这个空间中,只保留静态的外观信息,剥离掉动作因素。

3️⃣ 身份替换与调制

在规范空间中,通过部分身份调制模块(Partial Identity Modulation, PIM)将源身份特征注入目标人脸。PIM 使用空间掩码限制修改范围,仅作用于面部区域,避免对背景或其他非面部部分造成影响。

4️⃣ 恢复动态信息

将替换后的面部重新映射回原始空间,恢复其原有的动态信息,确保与原视频节奏一致。

5️⃣ 结果优化

最后,通过一个轻量级的 3D U-Net 网络结构进一步优化生成结果,提高画质与细节表现力。

创新技术点

🔍 规范空间变换

通过将视频帧转换到统一空间,实现动作与外观的分离,使得身份替换过程更加可控和稳定。

🎯 部分身份调制(PIM)

引入空间掩码机制,限定身份特征修改仅限于面部区域,减少误操作,提升整体稳定性与真实性。

📊 细粒度同步评估指标

设计了包括眼动、眨眼、口型同步等在内的多种细粒度评估标准,全面衡量视频人脸交换的质量。

⚡ 高效计算能力

尽管模型结构复杂,但 CanonSwap 在推理效率上表现优异,适合实际部署与应用。

实验验证与性能对比

研究团队在多个主流数据集上进行了大量实验,包括:

- FaceForensics++ (FF++)

- 新提出的 VFS (Video Face Swapping) 基准数据集

实验结果显示,CanonSwap 在以下多个维度均优于现有方法:

| 评估指标 | CanonSwap 表现 |

|---|---|

| 身份相似度(ID Similarity) | 显著优于 GAN 和扩散模型基线方法 |

| 姿态准确性(Pose Accuracy) | 更好地还原目标姿态 |

| 表情准确性(Expression Accuracy) | 更自然的表情迁移 |

| 口型同步误差(Lip Sync Error) | 同步效果更优 |

| 视觉质量(FID / FVD) | 得分最低,说明生成质量更接近真实视频 |

| 时间一致性 | 无明显闪烁或抖动,优于其他方法 |

这些结果充分证明了 CanonSwap 在视觉质量、身份保留与动态一致性方面的显著优势。

应用示例

假设,你想将电影《哈利·波特》中哈利的脸换成汤姆·克鲁斯的脸,同时希望保留哈利的所有表情、口型和头部动作。CanonSwap 就可以完成这样的任务:

- 它不仅将汤姆·克鲁斯的面部特征精确地“贴”到哈利脸上;

- 还能保证整个视频在视觉上自然流畅;

- 口型与原声完美同步,没有明显的不协调现象。

这种能力对于影视特效、虚拟主播、AI换脸社交等领域具有重要意义。

相关文章