MemOS 是由记忆张量科技联合上海交通大学、同济大学、浙江大学、北京大学等多所高校及研究机构联合开源的一项突破性研究成果——专为大语言模型(LLMs)设计的长期记忆操作系统。

该系统通过模拟人类记忆机制,实现了对 LLM 记忆能力的增强与扩展,使其具备动态读取、写入和更新记忆的能力,从而提升其推理、学习和个性化交互的表现。

MemOS 支持多种模态信息存储(文本、代码、图像),并在多个基准任务中展现出显著优于 OpenAI 等主流模型的性能表现。

技术亮点

| 特性 | 描述 |

|---|---|

| 💡 记忆增强生成(MAG) | 提供统一的记忆操作接口,支持上下文感知的记忆检索与增强生成,提升模型推理一致性与连贯性 |

| 📦 模块化记忆架构(MemCube) | 可灵活集成多种记忆类型,便于扩展与定制 |

| 💾 多模态记忆支持 | 存储与检索文本、代码、图像等多种格式数据 |

| 🔁 动态记忆管理 | 实现记忆的添加、修改与删除,适应不断变化的知识需求 |

| ⚙️ 高可扩展性 | 模块化设计支持新增记忆模块、自定义数据源与 LLM 集成 |

性能对比与测试结果

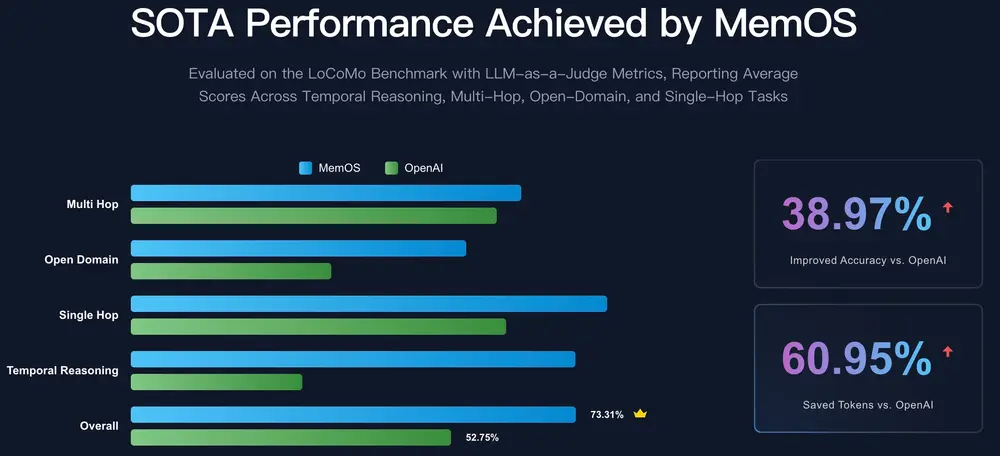

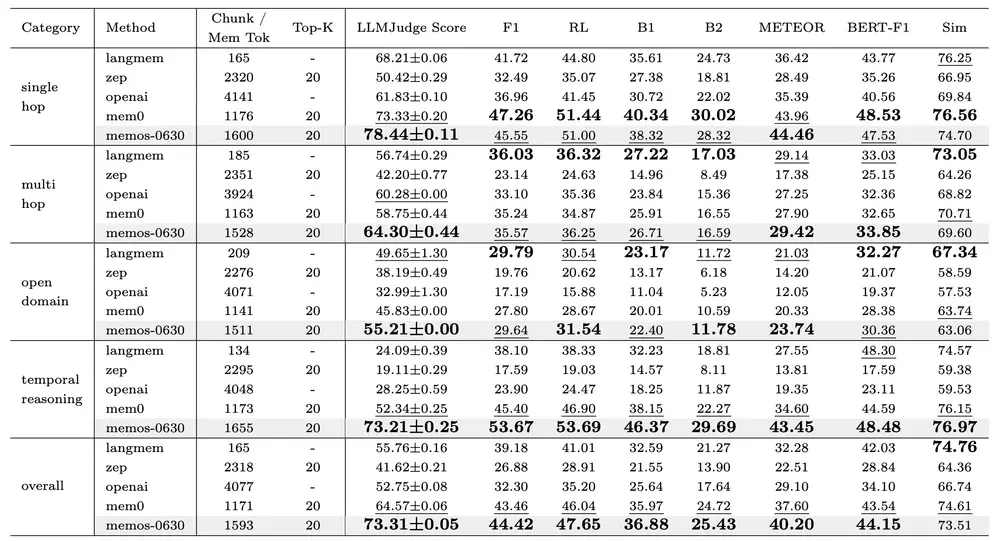

在 LOCOMO 基准测试 中,MemOS 相较于当前主流记忆系统(如 LangMem、Zep、OpenAI、Mem0)展现了显著优势:

✅ LOCOMO 推理任务得分对比

| 模型 | 平均得分 | 多跳推理 | 开放域推理 | 单跳推理 | 时序推理 |

|---|---|---|---|---|---|

| OpenAI | 0.5275 | 0.6028 | 0.3299 | 0.6183 | 0.2825 |

| MemOS | 0.7331 | 0.6430 | 0.5521 | 0.7844 | 0.7321 |

| 提升幅度 | +38.98% | +6.67% | +67.35% | +26.86% | +159.15% |

💡 MemOS 在时序推理任务中相较 OpenAI 提升超过 159%,展现出卓越的时间序列理解能力。

核心功能详解

记忆增强生成(Memory-Augmented Generation, MAG)

- 提供统一的记忆操作 API;

- 与 LLM 深度集成,实现基于上下文的记忆检索与生成;

- 显著提升对话一致性、知识准确性与个性化响应能力。

模块化记忆架构(MemCube)

- 支持多种记忆模块并行运行;

- 每个模块可根据任务需求独立配置与扩展;

- 架构兼容性强,适配主流 LLM 框架。

多种记忆类型支持

| 类型 | 功能描述 |

|---|---|

| 文本记忆 | 存储非结构化/结构化文本知识,用于上下文增强与问答 |

| 激活记忆 | 缓存注意力键值对(KV Cache),加速推理过程并复用上下文 |

| 参数记忆 | 存储 LoRA、Adapter 等轻量化模型参数,支持快速切换与组合 |

可扩展性与开放生态

- 支持开发者自由扩展新的记忆模块;

- 可接入外部数据库、向量库、文件系统等;

- 支持多模型协同记忆共享与调用。

🧪 应用场景

MemOS 可广泛应用于以下领域:

- 智能客服与助手:持续记录用户偏好与历史对话,提供更个性化的服务;

- 教育与辅导:构建学生知识图谱,辅助个性化学习路径规划;

- 科研与工程:长期存储实验记录、代码片段、论文摘要等;

- 企业知识库:整合公司内部文档、会议纪要、项目资料,提升团队协作效率;

- AI 内容创作:帮助 AI 记住角色设定、剧情发展、风格偏好等,增强故事连续性。

🧬 技术架构概览

MemOS 的整体架构分为以下几个核心组件:

- 记忆控制器(Memory Controller)

- 负责记忆的调度、检索与更新;

- 根据 LLM 当前状态选择合适记忆内容注入上下文。

- 记忆存储引擎(Memory Storage Engine)

- 支持多种记忆类型(文本、激活、参数);

- 提供高效的插入、查询与更新接口。

- 记忆检索器(Memory Retriever)

- 基于语义相似度匹配记忆;

- 支持关键词、向量、混合搜索等多种策略。

- 记忆编辑器(Memory Editor)

- 提供对记忆的增删改查接口;

- 支持人工干预与自动更新机制。

- 与 LLM 的集成层(LLM Adapter Layer)

- 将记忆信息无缝注入 LLM 上下文;

- 支持主流模型框架(如 Hugging Face Transformers、DeepSpeed、vLLM)。

📊 性能优势总结

| 指标 | MemOS 表现 | 对比 OpenAI 提升 |

|---|---|---|

| 平均准确性 | +38.97% | 显著提升 |

| Token 开销 | -60.95% | 更高效利用上下文 |

| 时序推理能力 | +159.15% | 全面超越 |

| 多跳推理能力 | +6.67% | 稳步提升 |

| 开放域推理能力 | +67.35% | 显著优化 |

| 单跳推理能力 | +26.86% | 整体增强 |

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...