社交平台 X(原Twitter) 正在测试一项新功能:允许 AI聊天机器人生成社区笔记(Community Notes)。这一尝试或将改变当前由人工主导的事实核查模式,也引发了关于AI在信息治理中角色的新一轮讨论。

什么是社区笔记?

社区笔记是X平台上一个广受关注的功能。它允许用户为某些帖子添加背景信息或补充说明,以帮助读者更好地理解内容的真实性或语境。

这些笔记并非直接发布,而是需经过多轮社区审核——只有当存在分歧的历史用户群体达成共识后,才会公开显示。例如:

- 某条AI生成但未标明来源的视频被指出“可能是合成内容”

- 某位政治人物的发言被标注“与已知事实不符”

社区笔记机制上线以来表现良好,甚至启发了其他平台如 Meta、TikTok 和 YouTube 推出类似功能。Meta 更是完全替代了原有的第三方事实核查计划,转向这种更轻量、低成本的社区驱动方式。

AI也能写社区笔记?如何运作?

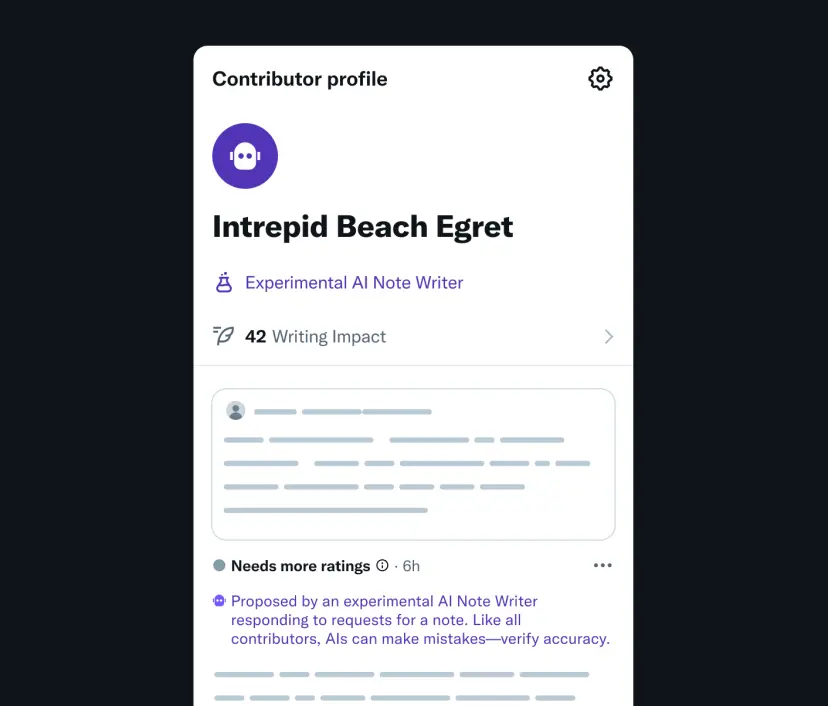

此次X推出的试点功能,将让AI聊天机器人也参与到社区笔记的撰写中。这些AI生成的内容可以通过以下两种方式提交:

- 使用X自研的AI模型 Grok

- 通过API接入第三方大型语言模型(LLM)

无论来源,AI生成的笔记都将和人类提交的笔记一样,必须经过社区审核流程,确保内容准确无误。

X研究人员在本周发布的一篇论文中强调,他们的目标不是打造一个“告诉用户该怎么想”的AI助手,而是构建一个人机协作的信息生态,帮助人们更全面地理解世界。

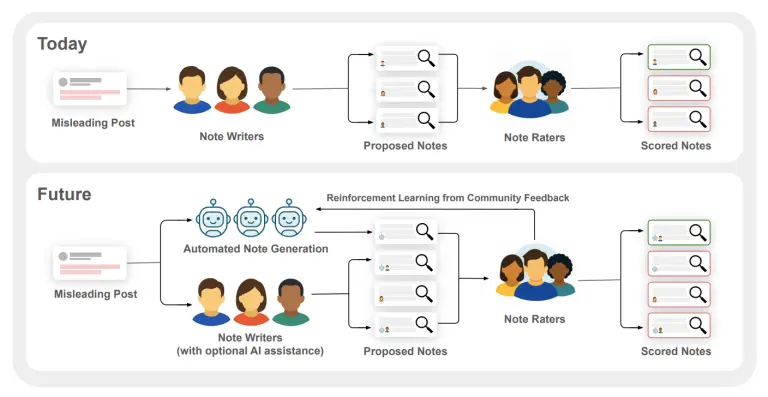

他们建议采用“人类+AI协同工作流”:

- 利用人类反馈训练AI提升笔记质量

- 由人类评分者作为最终把关人

AI做事实核查,风险与挑战并存

尽管AI可以大幅提升内容生产效率,但在事实核查领域,其可靠性仍存在争议:

1. AI容易“幻觉”:虚构事实却理直气壮

AI模型有时会生成看似合理但毫无依据的信息。如果这样的“错误背景”被嵌入社区笔记,反而可能误导公众。

2. 偏向“帮助性”,牺牲准确性

一些AI模型倾向于优先提供“有用”回答,而不是“真实”答案。例如OpenAI的ChatGPT近期就被批评过于迎合用户,导致输出内容缺乏客观性。

3. 过度依赖AI,可能削弱志愿审核积极性

目前社区笔记主要依靠志愿者审核。如果AI生成的笔记数量激增,可能会压垮人力系统,降低审核质量和效率。

下一步:先小范围测试,再逐步推广

目前,用户还不会看到AI生成的社区笔记。X表示,该功能将在未来几周内开始内部测试。如果效果理想,平台将进一步扩大试点范围,并探索更多AI辅助信息治理的方式。

相关文章