Soul AI推出新型图像生成模型 TransDiff ,该模型将自回归(AR)Transformer 和扩散模型相结合,用于高质量的图像生成。TransDiff 通过将输入编码为高级语义特征,并利用扩散模型解码这些特征来生成图像。该模型在 ImageNet 256×256 基准测试中表现出色,显著优于现有的基于单一 AR Transformer 或扩散模型的图像生成方法。

例如,用户可以输入一个类别标签(如“老虎”),TransDiff 能够生成高质量的老虎图像。与传统的 AR Transformer 或扩散模型相比,TransDiff 生成的图像在细节和语义一致性方面表现更好,同时保持了较快的推理速度。

主要功能

- 高质量图像生成:生成高质量、多样化的图像,适用于多种类别和场景。

- 快速推理:在保持高质量的同时,提供比现有扩散模型更快的推理速度。

- 多参考自回归(MRAR):通过引用多个先前生成的图像,进一步提高生成图像的质量和多样性。

主要特点

- 结合 AR Transformer 和扩散模型:利用 AR Transformer 提取高级语义特征,并通过扩散模型生成图像,结合了两者的优点。

- 多参考自回归(MRAR):通过引用多个先前生成的图像,生成更高质量和多样化的图像。

- 高效训练和推理:通过联合训练和优化,TransDiff 在训练和推理阶段都表现出色,显著减少了计算资源的消耗。

工作原理

TransDiff 的工作原理包括以下几个关键步骤:

- AR Transformer 编码:使用 AR Transformer 将输入(如类别标签)编码为高级语义特征。

- 扩散模型解码:利用扩散模型(如 DiT)将这些高级语义特征解码为图像。

- 多参考自回归(MRAR):在生成过程中,模型引用多个先前生成的图像,以生成更高质量和多样化的图像。

测试结果

- 定量评估:在 ImageNet 256×256 基准测试中,TransDiff 实现了 1.42 的 Fréchet Inception Distance (FID) 和 301.2 的 Inception Score (IS),显著优于现有的扩散模型和 AR Transformer 模型。

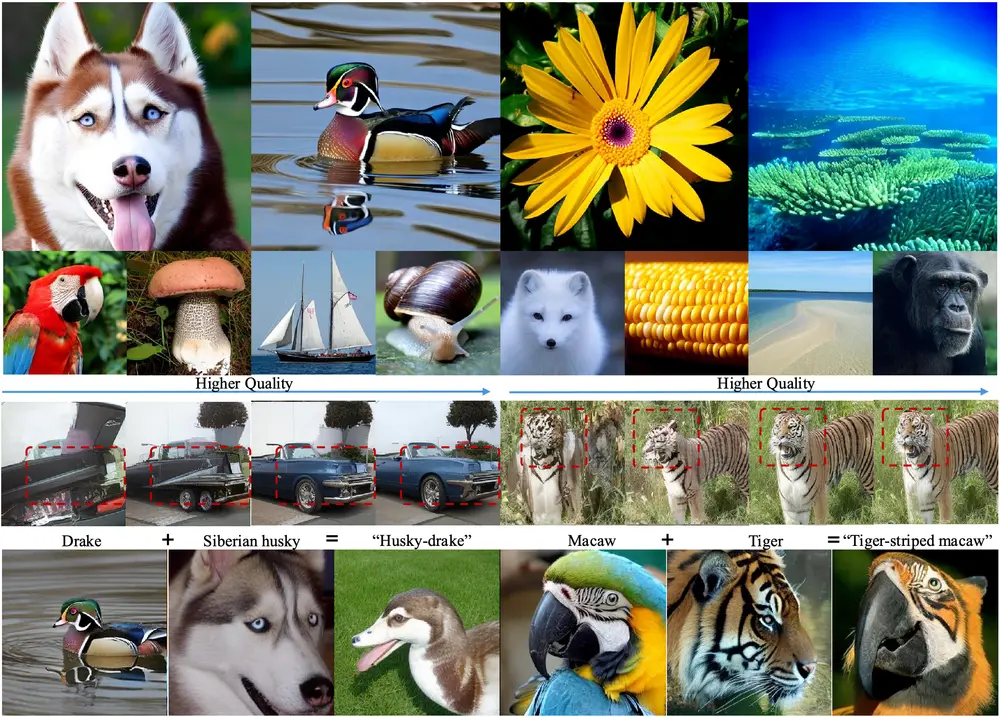

- 定性评估:通过可视化生成的图像,TransDiff 在细节和语义一致性方面表现出色,生成的图像更加真实和多样化。

- 用户研究:用户研究显示,TransDiff 在图像质量、背景多样性和主体多样性方面均优于现有的 Token-Level AR 和 Scale-Level AR 方法。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...