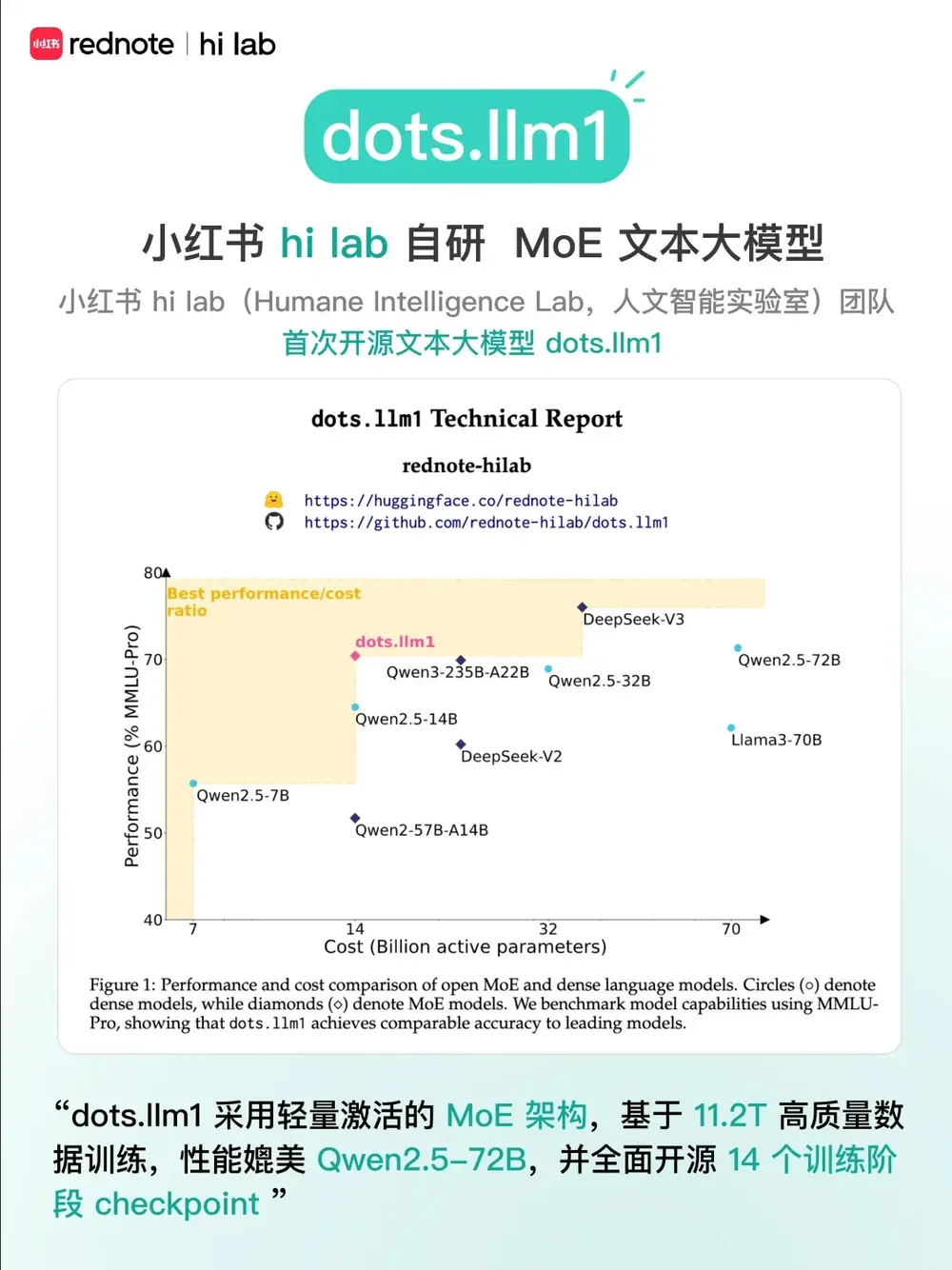

小红书 Hi Lab 团队近日正式开源了其自研大规模 MoE 文本大模型 dots.llm1,该模型总参数量高达 1420 亿(142B),但在每次推理时仅激活 140 亿(14B)参数,实现了高效能与高性能的平衡。

- 模型:https://huggingface.co/collections/rednote-hilab/dotsllm1-68246aaaaba3363374a8aa7c

- Demo:https://huggingface.co/spaces/rednote-hilab/dots-demo

在 11.2TB 高质量语料 的训练下,dots.llm1 在多个评测任务中表现接近甚至优于 Qwen2.5-72B,并在部分场景下超越 Qwen3-32B。这一成果标志着国产开源大模型在 MoE 架构和高效训练方面迈出了重要一步。

模型核心参数一览

| 属性 | 数值 |

|---|---|

| 总参数量 | 1420 亿(142B) |

| 激活参数量 | 140 亿(14B) |

| MoE 配置 | Top-6 + 2 共享专家,共 128 个专家 |

| 预训练数据 | 11.2TB 自然文本,无合成数据 |

| 支持上下文长度 | 32,768 token |

| 支持语言 | 英文、中文 |

| 训练阶段 | 预训练 + 监督微调(SFT) |

| 开源范围 | Instruct 版本、Base 版本、退火前后检查点、超参数等 |

核心技术亮点

✅ 超大规模 MoE 架构设计

dots.llm1 采用细粒度 MoE(混合专家)架构,每层从 128 个专家中选择 Top-6 加上 2 个共享专家 进行激活,实现:

- 高效利用计算资源

- 控制推理成本

- 提升模型表达能力

这种设计使得模型在保持高参数量的同时,仍具备出色的推理效率。

✅ 高效训练策略加持

为了提升训练效率,团队引入了多项关键技术:

- Interleaved 1F1B 流水线调度:最大化前向与反向传播之间的并行性

- AlltoAll 通信重叠优化:减少分布式训练中的通信瓶颈

- Grouped GEMM 优化:单算子前向提速 14%,反向提速 6.7%

这些改进显著提升了训练吞吐和稳定性,为大规模 MoE 模型训练提供了可复用的技术方案。

✅ 高质量预训练数据体系

小红书 Hi Lab 坚持“宁缺毋滥”的数据处理原则,构建了三阶段高质量数据清洗流程,确保训练语料兼具规模与质量。整个训练过程中未使用任何合成数据,全部来自真实自然文本。

最终使用的预训练语料总量达 11.2TB,覆盖广泛领域,为模型的语言理解和生成能力打下坚实基础。

性能表现亮眼

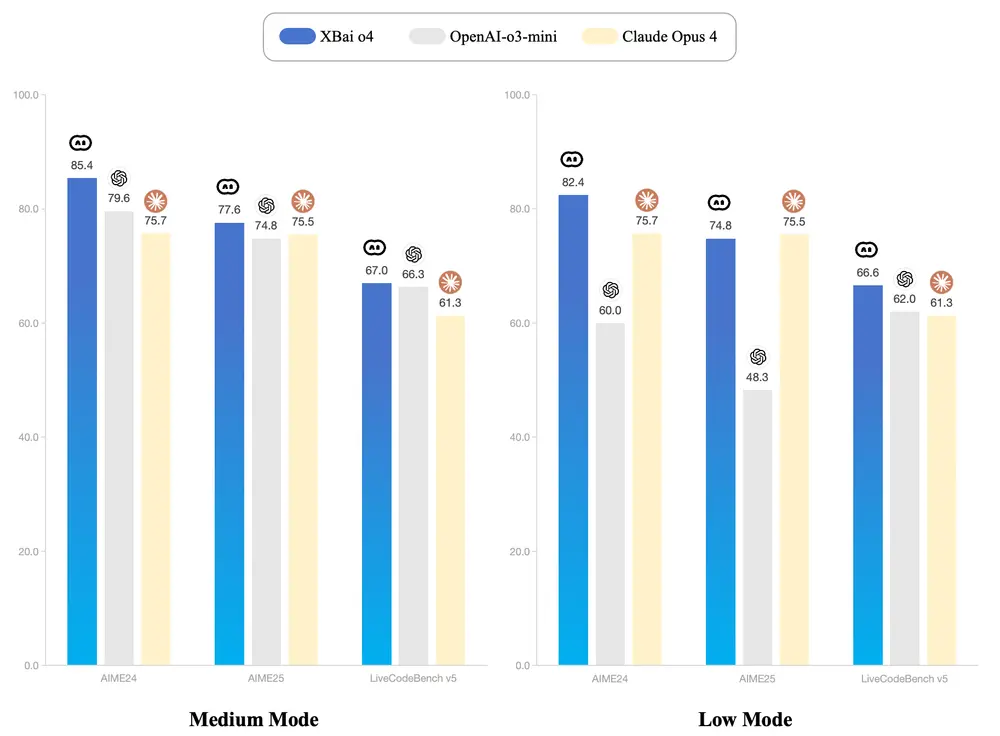

在推理仅激活 140 亿参数的情况下,dots.llm1-instruct 在多个评测任务中表现出色:

| 场景 | 表现对比 |

|---|---|

| 中英文通用任务 | 接近或优于 Qwen2.5-72B |

| 数学推理 | 超越 Qwen2.5-32B |

| 代码理解与生成 | 与主流大模型相当或更优 |

| 对齐能力 | 表现稳定,接近 Qwen3-32B |

尤其值得注意的是,在长文本理解和复杂推理任务中,dots.llm1 显示出强大的泛化能力和稳定性。

开源内容助力社区研究

为了推动大模型研究与应用落地,小红书团队开源了以下资源:

- Instruct 版本:支持指令微调任务

- Base 版本:包含长文 base 和退火阶段前后的多个模型

- 中间检查点:每 1 万亿 token 保存一次,便于研究模型学习动态

- 训练配置与超参数:方便社区复现实验、持续训练和深入分析

此次开源不仅为学术界和工业界提供了宝贵的模型资源,也为未来 MoE 架构的优化与探索奠定了良好基础。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...