在图像风格化领域,扩散模型已经取得了显著进展。然而,两个核心问题始终困扰着研究者与开发者:

- 如何在复杂场景下保持一致的风格化效果?

尤其是在身份、构图和细节上的保留。 - 如何防止图像到图像(I2I)流水线中的风格退化?

即在多次转换过程中,风格逐渐模糊甚至丢失的问题。

针对这些挑战,新加坡国立大学 Show Lab 提出了 OmniConsistency —— 一种基于DiT架构模型(Flux)的通用一致性插件,且与现有的LoRA兼容。该方法不仅有效提升了风格化的一致性与美学质量,还在性能上接近商业模型 GPT-4o。

- GitHub:https://github.com/showlab/OmniConsistency

- 模型:https://huggingface.co/showlab/OmniConsistency

- Demo:https://huggingface.co/spaces/yiren98/OmniConsistency

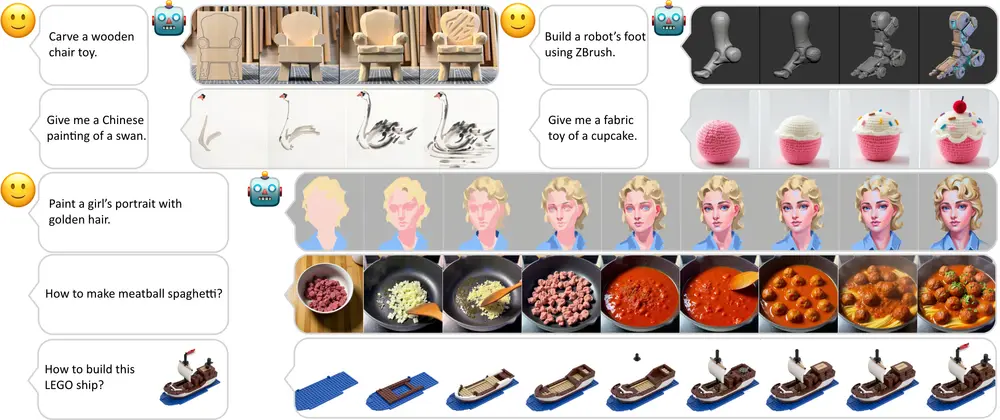

例如,给定一张图片和一种艺术风格(如毕加索风格),OmniConsistency 能够生成一张既保留了原始图像结构和细节,又具有目标风格的新图像。

OmniConsistency 的三大核心贡献

✅ 1. 上下文一致性学习框架

通过在对齐图像对上进行训练,使模型能够更好地理解原始图像与风格化图像之间的映射关系,从而实现更强的泛化能力。

✅ 2. 两阶段渐进式学习策略

将风格学习与一致性保持过程解耦,先学习风格特征,再强化一致性控制,有效缓解风格退化问题。

✅ 3. 即插即用架构设计

完全兼容主流风格 LoRA 模块(如 Flux模型),无需修改主干模型即可集成使用,极大提升了灵活性与实用性。

主要功能亮点

| 功能 | 描述 |

|---|---|

| 风格一致性 | 在多种未见过的风格与复杂场景中,仍能保持统一且高质量的风格输出。 |

| 防止风格退化 | 在图像到图像的迭代处理中,维持高保真的风格表达,避免风格稀释。 |

| 灵活布局控制 | 支持创造性结构变化,例如 chibi 风格、卡通变形等艺术表现形式。 |

工作原理详解

OmniConsistency 基于DiT架构模型构建,采用多阶段策略提升风格化效果:

第一阶段:风格 LoRA 构建

- 独立微调 22 种不同风格的 LoRA 模块,形成一个风格库;

- 每个 LoRA 模块专注于特定风格的学习,保证风格表达的多样性与准确性。

第二阶段:一致性模块训练

- 将预训练好的风格 LoRA 模块附加到 DiT 主干网络;

- 使用原始图像与对应风格化图像组成的配对数据进行训练;

- 通过引入专用的低秩适应路径(仅应用于条件分支),注入条件信息,增强一致性。

第三阶段:生成过程优化

- 使用低分辨率条件图像指导高分辨率图像生成;

- 引入位置感知插值与特征重用机制,确保空间对齐与结构稳定性。

测试结果与性能对比

实验表明,OmniConsistency 在多个关键指标上表现出色:

| 指标 | 说明 | 表现 |

|---|---|---|

| 风格一致性 | 风格是否稳定地贯穿整个图像 | 显著优于现有开源方法 |

| 内容一致性 | 是否保留原始图像的身份与结构 | 保持高度一致 |

| 文本-图像对齐 | 若有文本描述输入,风格是否符合描述 | 对齐准确率领先 |

| 美学质量 | 整体视觉美感 | 接近 GPT-4o 商业模型水平 |

此外,在多种风格与复杂背景下的测试也验证了其强大的泛化能力和鲁棒性。

OmniConsistency 的提出,标志着图像风格化领域迈出了重要一步。它不仅解决了长期存在的风格一致性与风格退化问题,也为开源社区提供了一种强大而灵活的解决方案。

对于研究人员、创作者以及希望在风格迁移领域有所突破的开发者来说,这是一个值得深入探索的前沿项目。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...