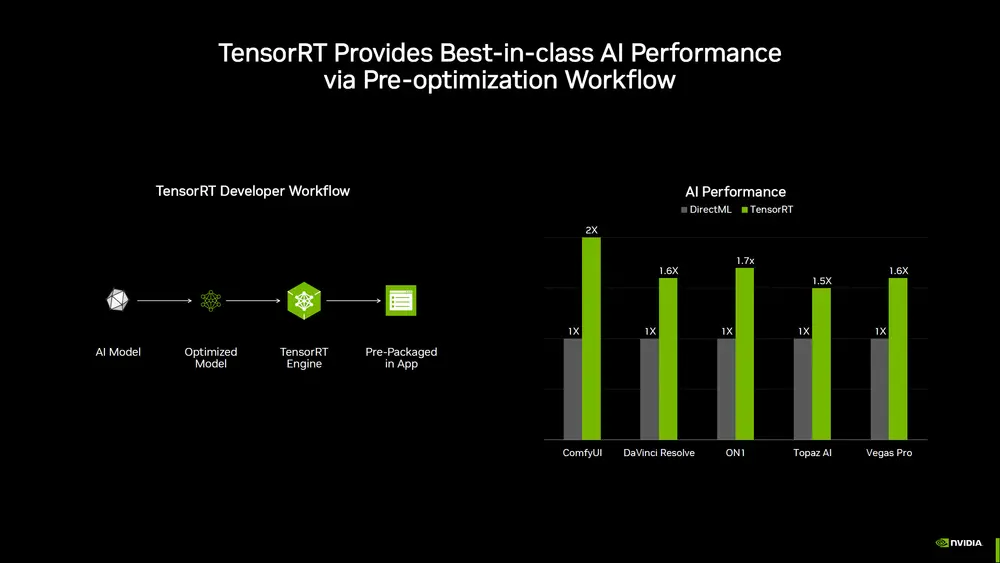

英伟达宣布将 TensorRT AI 加速技术 引入 RTX 平台,为所有 GeForce RTX显卡提供最高可达 2 倍于 DirectML 的性能提升。这一突破性进展不仅显著优化了 AI 推理速度,还为开发者和用户带来了更高效、更灵活的 AI 体验。

TensorRT:AI 性能的倍增器

通过 TensorRT,使用 RTX显卡 的普通消费者现在可以享受到经过深度优化的推理后端带来的性能飞跃。具体而言,与 DirectML 相比,TensorRT 在 AI 应用中的性能提升高达 2 倍。例如,在流行的工具如 ComfyUI 中,用户能够获得翻倍的运行速度;而在视频编辑软件 DaVinci Resolve 和 Vegas Pro 中,AI 工作负载性能也提升了 60%。

此外,TensorRT-LLM 现已在 Windows 上可用,并得到了 Windows ML 的原生支持。这意味着开发者无需额外配置即可轻松利用 TensorRT 的强大功能,进一步简化了开发流程。

Windows ML:无缝连接优化的 AI 执行层

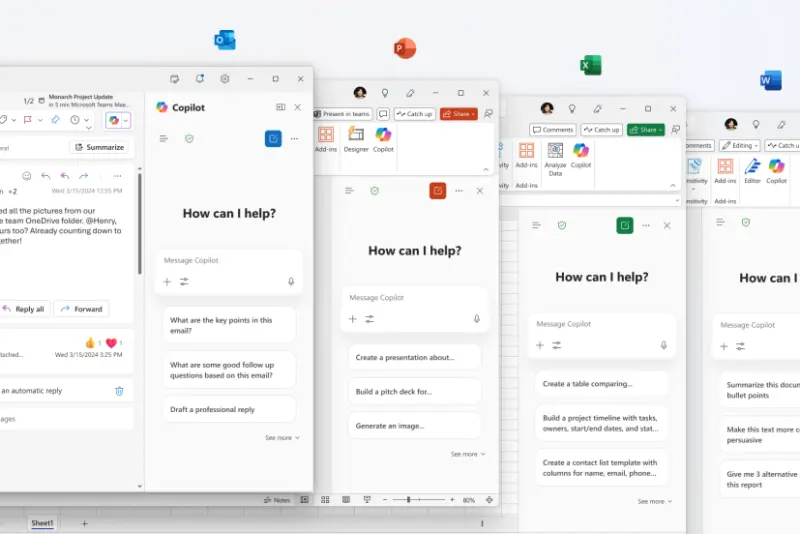

当前的 AI PC 软件堆栈通常要求开发者在两种路径之间做出选择:要么使用支持广泛硬件但性能较低的框架,要么选择仅针对特定硬件或模型类型的优化路径,但这需要维护多条代码路径。为解决这一问题,微软推出了 Windows ML 推理框架,并基于 ONNX Runtime 构建。

对于搭载 GeForce RTX GPU 的设备,Windows ML 自动调用 TensorRT for RTX——一个专为高性能和快速部署优化的推理库。与 DirectML 相比,TensorRT 在 PC 上的 AI 工作负载性能平均提升超过 50%。

Windows ML 的另一大优势在于其自动化能力。它可以根据每个 AI 功能的需求,智能选择最适合的硬件,并自动下载相应的执行提供程序,无需开发者手动打包这些文件。这使得英伟达能够第一时间向用户提供最新的性能优化。由于基于 ONNX Runtime,Windows ML 支持所有 ONNX 模型,极大扩展了其兼容性。

TensorRT for RTX 的更多亮点

除了性能提升,TensorRT for RTX 还带来了以下显著优势:

- 更小的库文件大小:新后端使库文件大小缩小了 8 倍,降低了存储和分发成本。

- 即时优化:TensorRT for RTX 支持针对每款 GPU 的即时优化,确保用户在不同硬件上都能获得最佳性能。

- 广泛支持:TensorRT for RTX 将于 6 月 在 developer.nvidia.com 上对所有 GeForce RTX GPU 开放,覆盖从消费级到专业级的广泛用户群体。

英伟达的全面创新:不止于 TensorRT

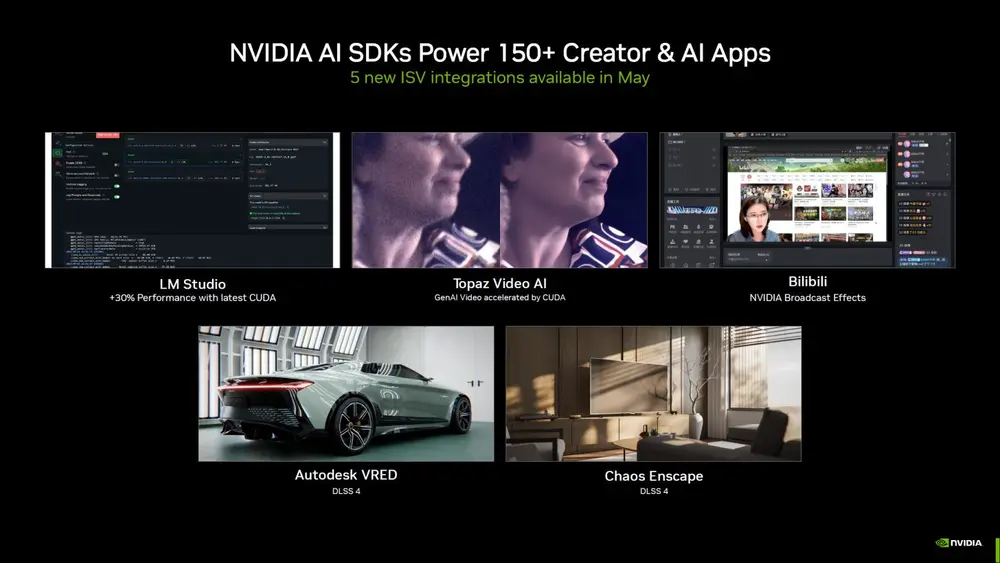

英伟达的软件创新远不止于此。公司目前支持超过 150 个 AI SDK,并计划本月推出 5 个全新的 ISV 集成,包括以下亮点:

- LM Studio:最新 CUDA 优化带来 30% 性能提升。

- Topaz Video AI:利用 GenAI 视频加速 CUDA 技术,显著提升视频处理效率。

- Bilibili:集成英伟达 Broadcast 效果,提升直播和内容创作体验。

- AutoDesk VRED 和 Chaos Enscape:引入 DLSS 4,大幅提高渲染速度和画面质量。

此外,英伟达还推出了新的 NIM(Neural Inference Modules) 和 AI Blueprints,进一步简化 AI 开发流程。例如,Project G-Assist 新增了多个插件,包括 Discord、Gemini、IFTTT、Twitch、Spotify 和 SignalRGB 的集成。用户还可以通过 github.com/nvidia/G-Assist 自行构建个性化插件。

相关文章