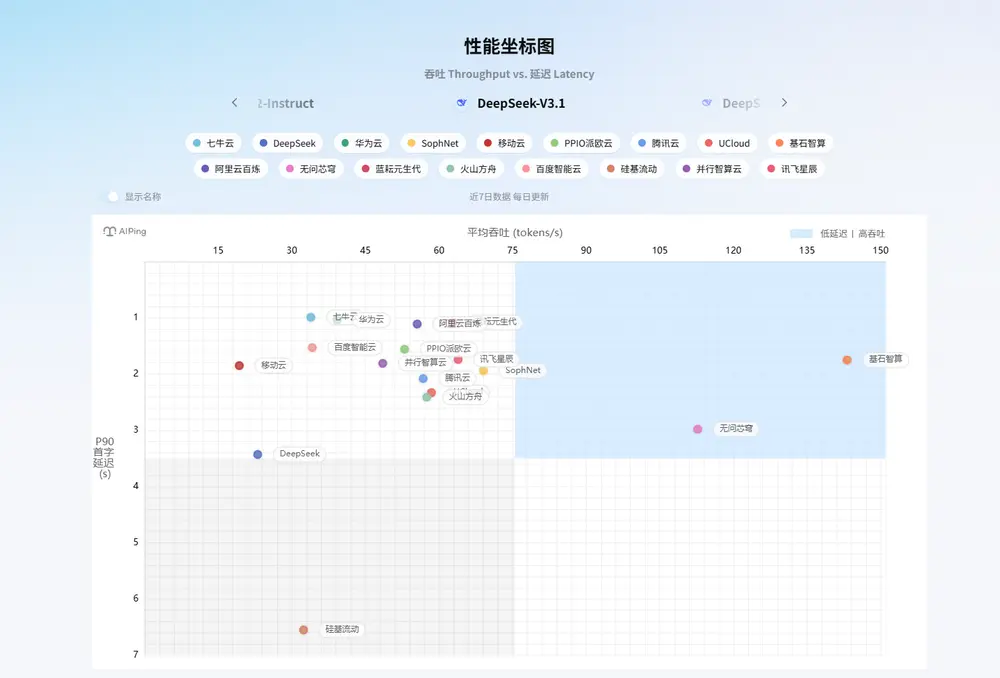

在生成式AI快速发展的今天,市场上已有数十家厂商提供数百种大模型API服务。面对琳琅满目的选择,开发者常面临一个现实难题:

哪个模型响应更快?吞吐更高?服务更稳定?

靠厂商白皮书?还是凭社区口碑?这些方式往往缺乏统一标准,难以支撑严谨的技术决策。

为此,清华大学 联合 中国软件评测中心 共同推出 AI Ping ——一个致力于提供全面、客观、真实的大模型服务性能评测平台。

即日起,AI Ping 正式上线 V0.1 版本,面向公众开放访问,旨在成为开发者在模型选型过程中的“第三方评测官”和“科学决策助手”。

不是榜单,而是标准:为什么需要AI Ping?

当前大模型服务的性能描述多由供应商自行发布,存在以下问题:

- 测试条件不透明

- 指标定义不统一(如延迟测的是首token还是整句?)

- 缺乏横向对比基准

这导致“参数虚高”“宣传误导”现象频出,增加了选型成本与试错风险。

AI Ping 的目标正是打破这一困局。它基于:

- 统一测试环境

- 标准化压测流程

- 可追溯的数据来源

对主流大模型服务进行定期、高频、公开的性能评估,确保每一条数据都经得起验证。

V0.1 核心功能一览

一、专业性能评测:三大核心指标横向对比

AI Ping 当前已整合并评测了 20余家主流供应商 的 数百个模型服务,涵盖国内主要云厂商、AI初创企业及开源服务商。

评测维度聚焦三大关键性能指标:

| 指标 | 说明 |

|---|---|

| 延迟(Latency) | 从请求发出到收到首个token的时间,影响交互流畅度 |

| 吞吐(Throughput) | 单位时间内可处理的token数量,决定批处理效率 |

| 可靠性(Reliability) | 请求成功率、错误率、服务可用性等稳定性表现 |

所有测试均在相同网络环境与负载条件下完成,确保公平可比。

结果以动态排行榜形式呈现,支持按时间维度查看各服务商的表现趋势,帮助识别长期稳定者与短期波动者。

二、详尽模型信息库:参数配置一目了然

除了性能数据,AI Ping 还构建了完整的模型与供应商信息档案,每个条目均包含:

- 支持的模型列表(如 Qwen-Max、GLM-4-Pro、ERNIE-Bot-turbo)

- 上下文长度(input/output)

- 最大输出长度

- 定价策略(按token或包月)

- 是否支持流式输出、函数调用等能力

无论是要做成本核算,还是评估功能兼容性,都能在这里找到一手资料。

三、客观公正:方法论透明,数据可追溯

AI Ping 坚持“用数据说话”,所有评测遵循严格的方法论:

- 使用标准化 Prompt 集进行测试

- 多轮次加权平均消除偶然误差

- 公开测试脚本与采样规则(未来计划开源)

平台不接受商业赞助,不设“推荐位”,所有排名由真实表现驱动,确保中立性与公信力。

如何使用 AI Ping?

目前平台提供两大核心入口:

性能排行榜

- 查看各供应商综合得分排名

- 对比特定模型在不同指标上的表现

- 观察历史趋势变化(即将上线)

模型详情页

- 查询某款模型的具体参数

- 获取接口文档链接与调用示例

- 下载测试报告PDF(适用于企业用户)

操作简单直观,无需注册即可浏览,助力开发者快速完成初步筛选。

技术细节补充:关于测试的一致性保障

为确保评测一致性,AI Ping 在测试过程中采用如下措施:

- 所有请求通过统一客户端发起

- 网络延迟通过本地基准校准扣除

- 并发压力模拟真实业务场景(5–50并发)

- 数据采集周期为每日一次,持续监测

此外,参考 Cline MCP 服务器中提到的 Network Timeout 设置机制(默认1分钟,可调至1小时),AI Ping 在可靠性测试中也设置了合理的超时容忍窗口,避免因短暂抖动误判服务失败。

展望未来:不止于 V0.1

虽然当前版本已具备基础服务能力,但这只是一个开始。

后续规划包括:

- 增加更多细分场景评测(如长文本生成、函数调用精度)

- 支持自定义测试任务提交

- 开放API供企业集成评测数据

- 推出移动端应用与订阅通知服务

我们相信,只有建立公开、透明、可信的评测体系,整个行业才能走向高质量发展。

数据统计

相关导航

Open ASR 排行榜

ARC Prize

WorldVQA

Hi3DEval

CodeArena

Code Arena

Music Arena