为了全面、公正地评估其最新图像生成模型 Qwen-Image 的通用生成能力,并与当前最先进的闭源模型(如 Imagen 4、GPT Image 1 等)进行直接对比,阿里巴巴通义实验室推出了 AI Arena ——一个基于 Elo 评分系统 的开源、开放图像生成模型基准测试平台。

AI Arena 的目标是打破传统静态榜单的局限,构建一个公平、透明、动态演进的评估环境,让模型性能不再依赖单一指标,而是由真实用户在实际体验中投票决定。

核心机制:用“人类偏好”驱动模型排名

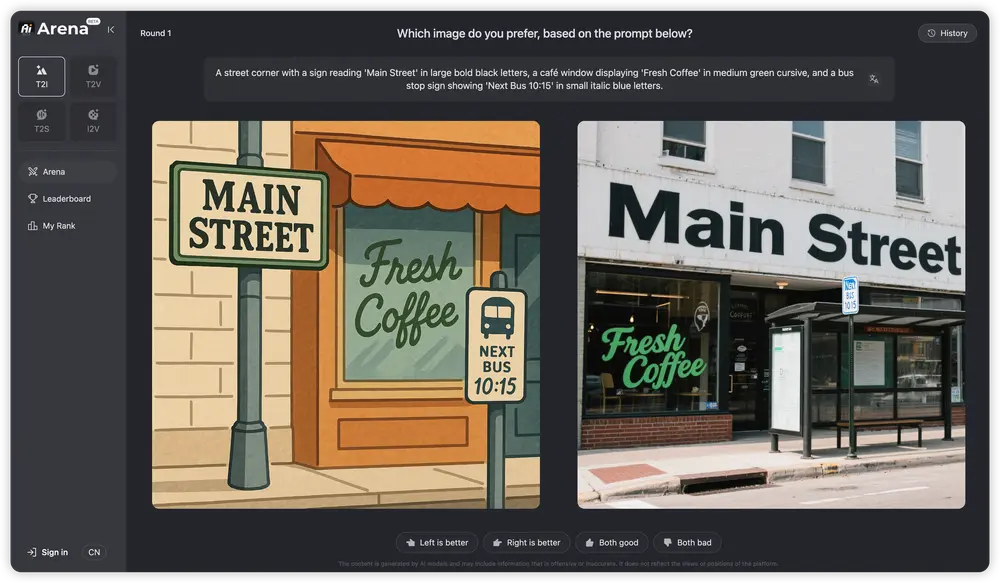

AI Arena 采用经典的 成对比较(Pairwise Comparison) 方法,其核心流程如下:

- 随机匹配

系统从候选模型池中随机选择两个模型(包括 Qwen-Image 和其他开源/闭源模型)。 - 统一提示生成

两个模型接收完全相同的文本提示,各自生成一张图像。 - 匿名呈现与投票

生成的两幅图像以匿名形式展示给用户,用户根据整体质量、提示遵循度、细节表现等维度,选择“哪一张更好”。 - Elo 排名更新

用户的投票结果通过 Elo 评分算法 实时更新各模型的全球排名。胜者得分上升,败者得分下降,分数变化幅度取决于双方当前实力差距。

这一机制确保了:

- ✅ 公平性:所有模型面对相同提示

- ✅ 透明性:评分规则公开,结果可追溯

- ✅ 抗过拟合:动态提示和用户多样性防止模型“刷榜”

- ✅ 人类中心:最终评价基于真实人类审美与偏好

为什么需要 AI Arena?

当前的图像生成评估常依赖自动化指标(如 FID、CLIP Score),但这些指标:

- 无法准确反映人类对“美感”、“创意”或“语义一致性”的判断

- 容易被特定数据分布或提示工程误导

- 难以评估复杂场景(如多主体、空间关系、长文本描述)

AI Arena 通过大规模人类反馈,弥补了这一空白,为开发者、研究人员和公众提供了一个数据驱动、可信赖的模型性能参考。

谁可以参与?

AI Arena 面向所有人开放:

- 普通用户:参与投票,帮助塑造模型排名,体验最新生成技术。

- 研究人员:获取真实的人类偏好数据,用于模型分析与改进。

- 开发者:提交自己的开源模型参与竞技,获得社区反馈与曝光。

- 企业:客观评估不同模型在实际应用中的表现,辅助技术选型。

与 Qwen-Image 的关系

AI Arena 的推出,正值阿里发布 Qwen-Image(20B 参数 MMDiT 模型)之际。该平台为 Qwen-Image 提供了一个直接对标顶级闭源模型的竞技场。

通过在 AI Arena 中的表现,Qwen-Image 能够:

- 展示其在复杂文本渲染、中文支持、细节生成等方面的优势

- 获取真实用户反馈,指导后续迭代

- 在开放环境中证明国产大模型的竞争力

总结

AI Arena 不只是一个排行榜,更是一种全新的模型评估范式。它将“谁生成得更好”这个问题,交还给最权威的裁判——人类用户。

在这个由人类偏好驱动的竞技场中,模型不再比拼冷冰冰的分数,而是通过一次次真实的审美较量,赢得属于自己的位置。

对于关注多模态生成技术发展的任何人来说,AI Arena 都是一个值得关注的风向标。

数据统计

相关导航

WorldVQA

AITradeGame

PokerBattle

CodeArena

BrowseComp-Plus

LoCoDiff

MagicArena