在检索增强生成(RAG)系统中,kapa.ai一直在探索如何利用最新的技术提升系统的性能和适应性。最近,它们团队尝试将OpenAI的o3-mini推理模型融入RAG管道,希望借助其强大的推理能力优化信息检索和知识提取。今天,我们就来聊聊这次探索的成果。

背景:RAG系统与挑战

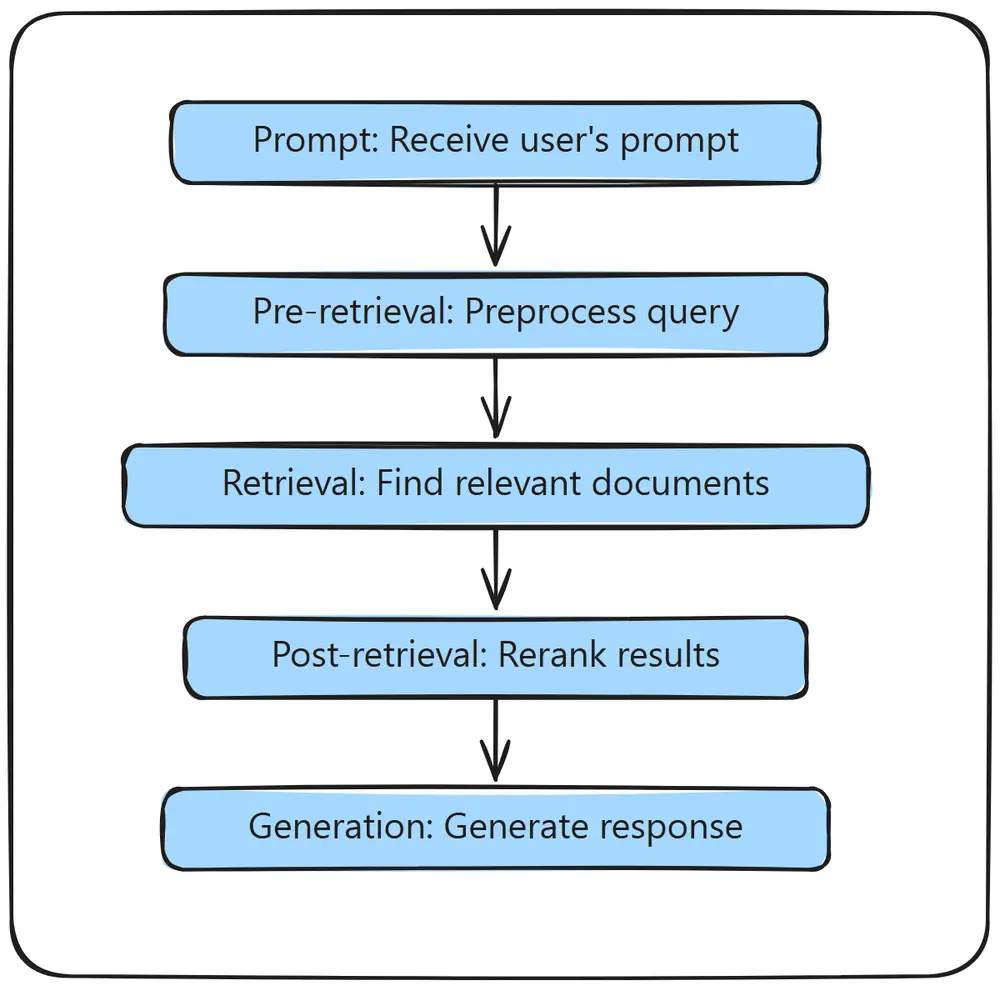

kapa.ai是一款基于LLM(大语言模型)的AI助手,能够回答用户关于产品的技术问题。它通过RAG管道与知识源集成,为用户提供精准的答案和支持。然而,构建和维护一个强大且通用的RAG系统并非易事。系统中有许多参数和控制点,如提示模板、上下文大小、查询扩展、分块、重排序等,它们相互作用,影响最终输出的质量。

当研究团队对系统进行更新,尤其是集成新模型时,重新调整这些参数至关重要,但过程耗时且需要丰富的经验。因此,研究团队开始思考:是否可以利用推理模型的动态能力,简化这一过程?

推理模型的潜力

像DeepSeek-R1和OpenAI的o3-mini这样的新推理模型,通过内置的思维链(CoT)提示,能够逐步“思考”问题,甚至自我纠正。它们在需要逻辑推理的复杂任务中表现出色,这让我们看到了将推理模型应用于RAG管道的可能性。

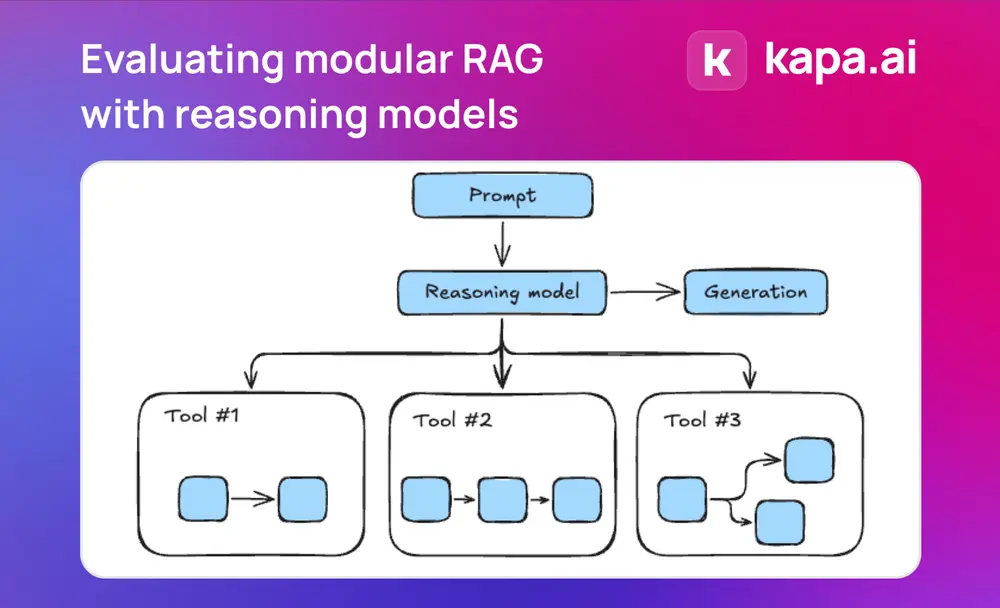

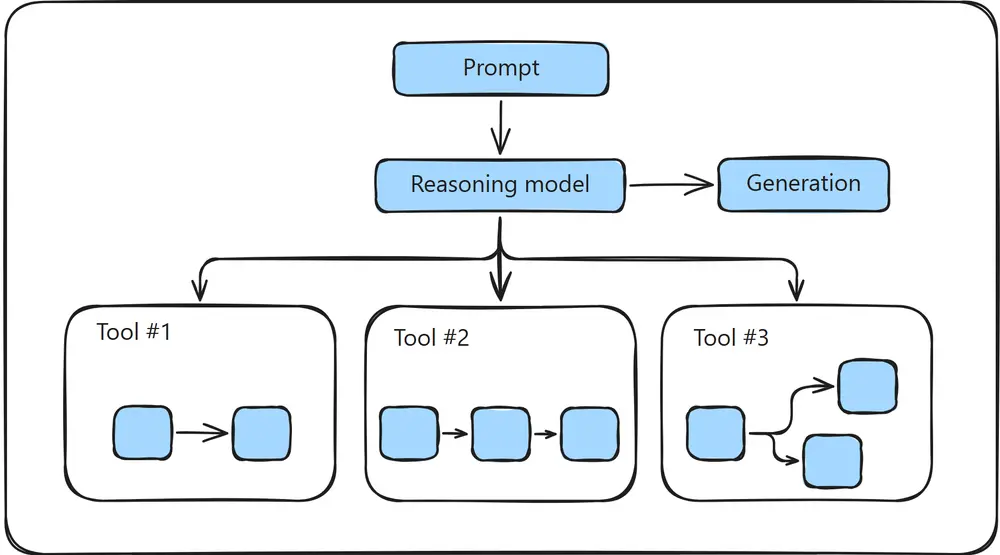

如果推理模型可以分解复杂任务并自我纠正,那么是否也可以用它们来处理RAG管道中的查询扩展、文档检索和重排序等任务?通过构建一个信息检索工具箱并交给推理模型,我们或许能够打造一个更具适应性的系统,减少人工调整的需求。

这种架构被称为模块化RAG,它将RAG管道的各个组件变成独立模块,推理模型可以动态调用这些模块,而不是遵循固定的流程。这种方法不仅可能取代传统的RAG编排框架,还能带来诸多优势,例如模块的可替换性、更清晰的职责分离、独立扩展以及针对特定任务或领域的定制化。

此外,研究团队还想探索这种方法是否能更高效地处理滥用或离题的查询,尤其是那些故意设计以逃避检测的查询。

测试设置与评估

为了验证这一想法,研究团队搭建了一个沙盒RAG系统,包含必要的组件、静态数据和LLM作为评估工具。对比了传统的固定线性管道和基于o3-mini的模块化RAG管道。

在模块化RAG中,研究团队尝试了不同的策略,包括工具使用的完全开放与限制、开放式与高度结构化的提示,以及不同程度的工具调用预参数化。所有测试中,研究团队将工具调用数量上限设为20次,并在中等和高推理努力下运行测试。

实验结果:喜忧参半

实验结果呈现出喜忧参半的局面。在某些配置下,研究团队观察到适度的性能提升,尤其是在代码生成领域,以及在一定程度上对事实性问题的处理。然而,在信息检索质量和知识提取等关键指标上,模块化RAG与传统管道相比并无显著优势。

一个反复出现的问题是,思维链(CoT)推理引入了额外的延迟。虽然更深入的推理有助于模型分解复杂查询并自我纠正,但这也需要更多时间来迭代工具调用。

最令人关注的挑战是“推理≠经验”的谬误。推理模型虽然能够逐步思考,但缺乏使用检索工具的先验经验。即使使用严格的提示,模型也难以检索出高质量的结果,且难以区分输出的优劣。这表明,尽管推理模型擅长抽象问题解决,但优化未经过事先培训的工具使用仍然是一个开放的挑战。

主要收获:推理≠经验

实验揭示了一个关键问题:推理模型不会自然地“理解”检索工具。与传统管道中将经验编码在启发式和优化中的方式不同,推理模型需要明确地学习如何有效使用工具。

尽管o3-mini能够处理更大的上下文,但在知识提取方面并未显著优于其他模型。增加上下文大小并非检索性能的万能解决方案。此外,增加模型的推理努力仅略微提高了事实准确性,这可能与研究团队的数据集侧重于技术内容有关。

不过,模型在代码生成领域表现出色,这表明推理模型可能更适合需要结构化、逻辑输出的任务,而非单纯的检索任务。

推理≠经验谬误:可能的解决方案

为了解决“推理≠经验”的问题,研究团队可以尝试以下策略:

- 优化提示策略:通过更明确地向模型提供工具使用指导,帮助其更好地理解和调用工具。

- 预训练或微调:对模型进行工具使用的预训练或微调,使其熟悉特定的检索机制。

- 混合方法:结合预定义的启发式方法和推理模型的动态干预,让模型在需要时选择性地介入。

这些方法仍处于探索阶段,但它们为我们弥合推理能力和实际工具执行之间的差距提供了方向。

结论:潜力与局限

虽然在当前的用例中,基于推理的模块化RAG尚未展现出明显优于传统管道的优势,但这次实验为我们提供了宝贵的见解。模块化方法的灵活性仍然具有吸引力,它允许更大的适应性、更轻松的升级以及对新模型或数据源的动态调整。

未来,我们可以进一步探索以下方向:

- 优化模型与工具的交互:通过不同的提示策略和预训练/微调,改进模型对检索工具的理解和使用。

- 针对性应用:将推理模型应用于管道的特定部分,如复杂问答或代码生成,而不是整个工作流程。

目前,像o3-mini这样的推理模型在核心检索任务中尚未超越传统RAG管道。但随着模型技术的进步和工具使用策略的发展,基于推理的模块化RAG系统有望成为一种可行的替代方案,尤其适用于需要动态、逻辑密集型工作流程的领域。

相关文章