JetBrains 最新更新了其 AI 助理功能,新增对本地大型语言模型的支持,为开发者提供了更灵活的开发环境选择。通过 LM Studio,开发者可以在本地环境中运行语言模型,减少对云端服务的依赖,同时提升数据隐私和运算控制能力。

本地模型支持:更低风险,更高掌控力

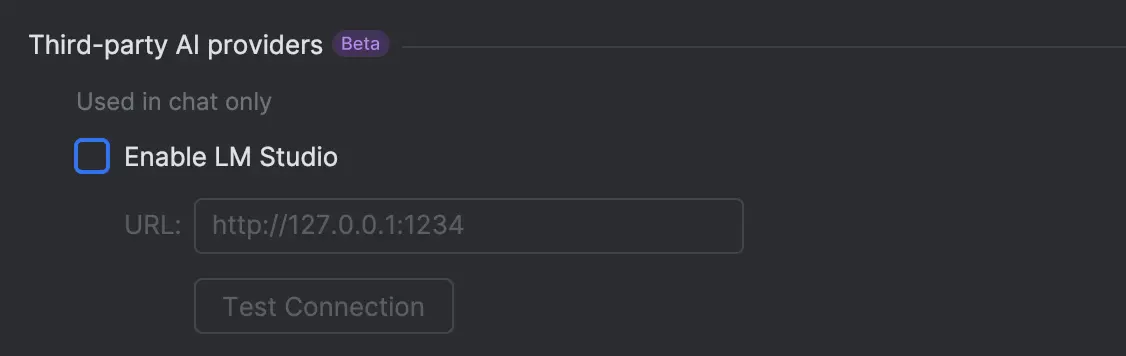

从 2024.3.2 版本开始,JetBrains IDE 的用户不仅可以使用云端语言模型,还可以选择在本地运行语言模型。这一功能的实现得益于 LM Studio——一款专为本地模型设计的应用程序。LM Studio 提供了一个友好的界面,允许开发者轻松下载、管理和运行开源模型(如 Llama 和 Mistral),并通过 API 将其集成到 JetBrains 的开发工具中。

借助这项整合,JetBrains AI 助理能够在 IDE 内提供与云端模型类似的交互体验,但所有运算过程都完全保留在用户的本地设备中。这种方式不仅减少了数据外流的风险,还让开发者能够更好地掌控敏感信息,特别适合需要高度数据隐私保护的企业或项目。

云端模型扩展:更多选择,满足多样化需求

除了本地模型支持,JetBrains AI 助理还引入了最新的云端模型选项,进一步丰富了开发者的工具箱。此次更新新增了以下模型:

- Anthropic 的 Claude 3.5 系列:

- Claude 3.5 Sonnet:擅长生成高质量文本,适合复杂任务。

- Claude 3.5 Haiku:轻量级版本,适用于快速响应场景。

- OpenAI 的 o1、o1-mini 和 o3-mini 模型:

- o1:具备强大的推理能力,适合解决复杂的编程问题。

- o1-mini 和 o3-mini:专注于高效运算,适合实时反馈的工作流程。

开发者可以根据具体需求选择最适合的模型,无论是需要高精度推理还是追求快速响应,都能找到合适的解决方案。

灵活切换:本地与云端的最佳平衡

JetBrains 的这次更新旨在为开发者提供更大的灵活性,让他们能够根据实际需求自由切换本地和云端环境。对于注重数据隐私和成本控制的团队来说,本地模型支持无疑是一个重要的突破。它不仅降低了对 OpenAI、Anthropic 等云端服务的依赖,还帮助企业更好地满足内部 IT 安全要求。

与此同时,云端模型的扩展则继续为开发者提供高性能和多样化的选择,确保在不同场景下都能获得最佳的开发体验。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...