随着技术的不断进步,视频生成领域也在持续创新。近日,ComfyUI 在其最新的 v0.2.7 版本中加入了对 Mochi 模型的原生支持,这标志着 ComfyUI 社区迎来了一次重大升级,即便是使用消费级显卡的用户也能享受到前沿的视频生成体验。

- 模型地址:https://huggingface.co/Comfy-Org/mochi_preview_repackaged/国内代理地址

- 工作流:https://comfyanonymous.github.io/ComfyUI_examples/mochi

Mochi 模型:亮点一览

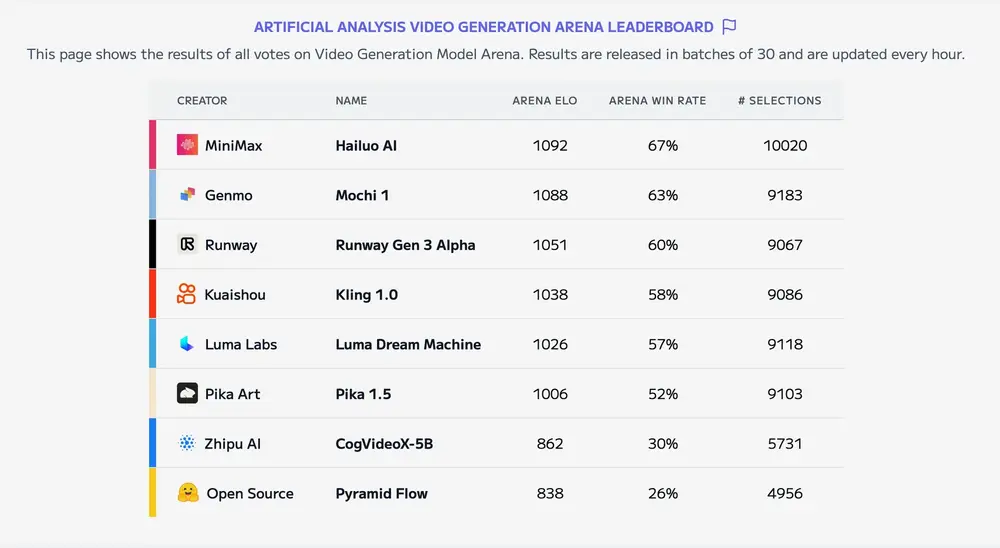

领先的性能表现

Mochi 模型不仅在开源视频生成领域树立了新的标杆,更以其卓越的动态效果和精准的指令响应能力而著称,能够为用户提供高质量的视频输出。

开放的许可证

Mochi 模型采用 Apache 2.0 许可证发布,这意味着开发人员和创作者可以自由地使用、修改和集成 Mochi 到他们的项目中,无需担心复杂的授权问题。

强大的硬件适应性

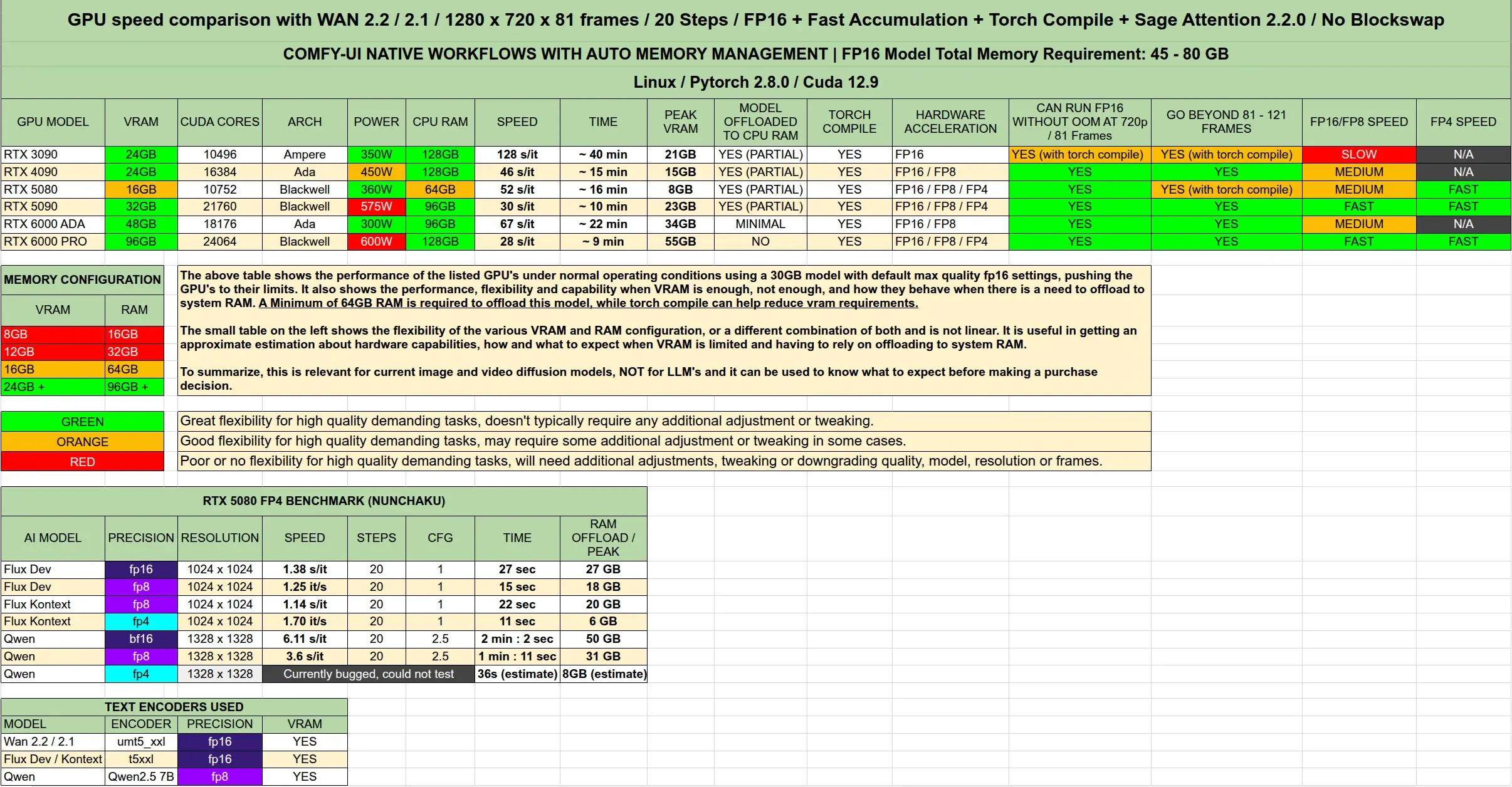

Mochi 支持包括英伟达GeForce RTX 4090 在内的消费级显卡,通过 ComfyUI 内置的多种注意力机制后端,能够在小于 24GB 显存的设备上流畅运行,极大降低了高性能视频生成的门槛。

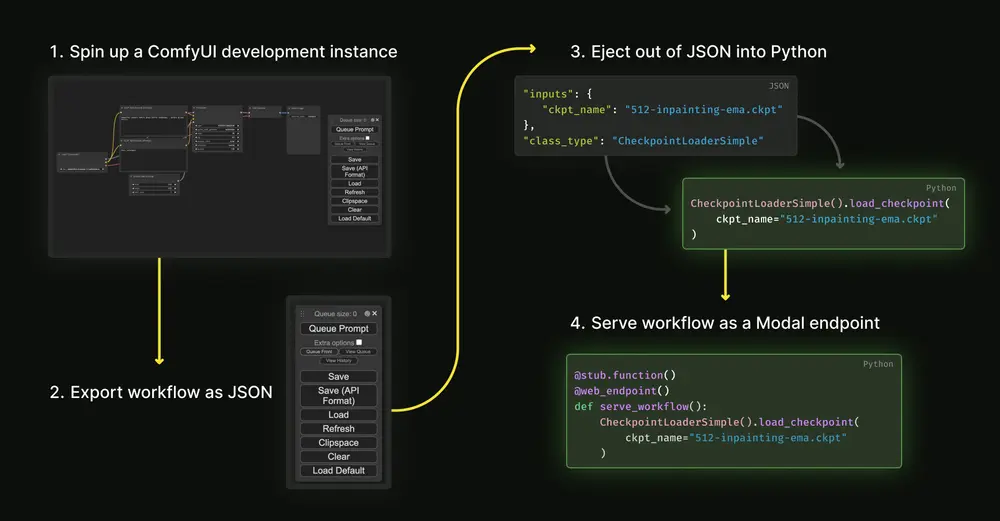

快速上手指南:如何在 ComfyUI 中使用 Mochi

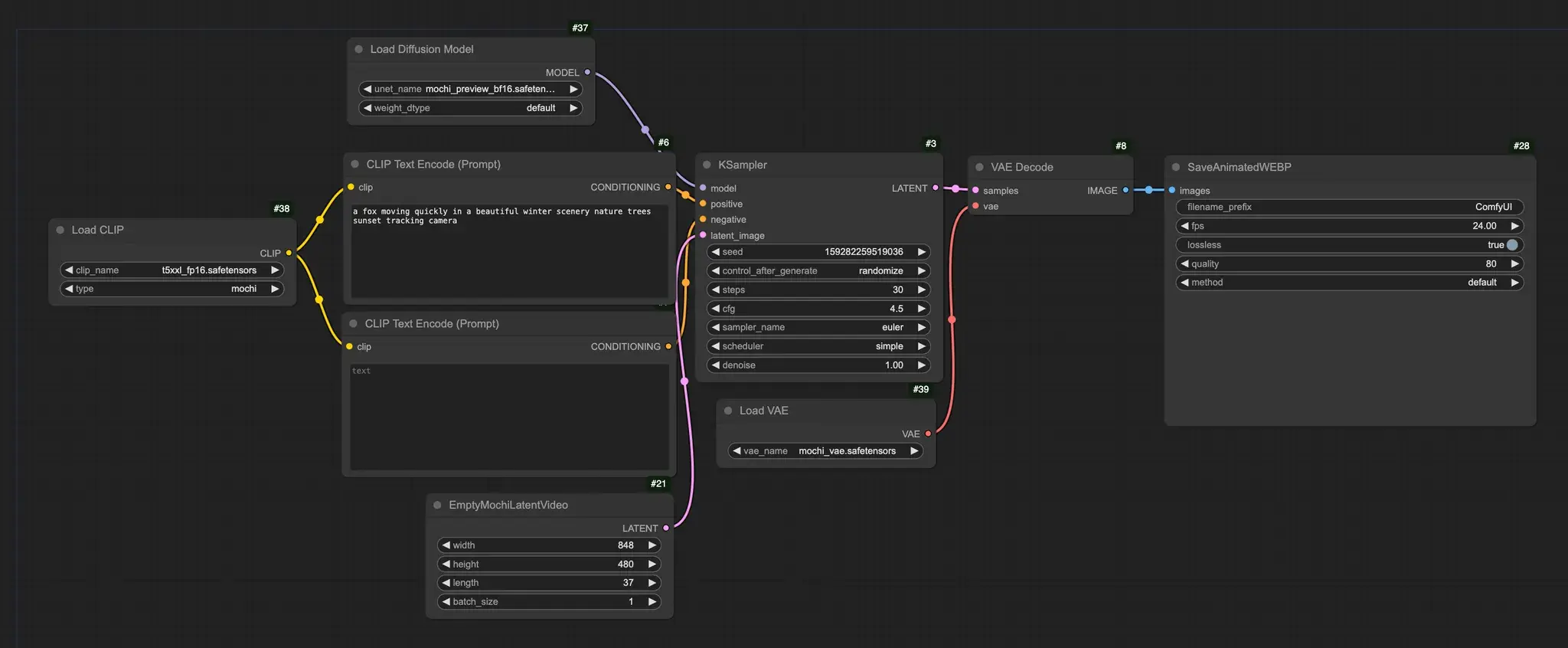

为了帮助用户更快地开始使用 Mochi 模型,以下是几个简单的步骤:

1、更新软件:首先,请确保您的 ComfyUI 已升级至最新版本。

2、下载模型文件:

将 Mochi 的模型文件保存至 models/diffusion_models目录下。文本编码器需放置于 models/clip文件夹内。VAE 文件则应位于 models/vae文件夹中。

3、参考示例工作流:访问官方提供的示例工作流链接,根据指导快速启动视频生成任务。

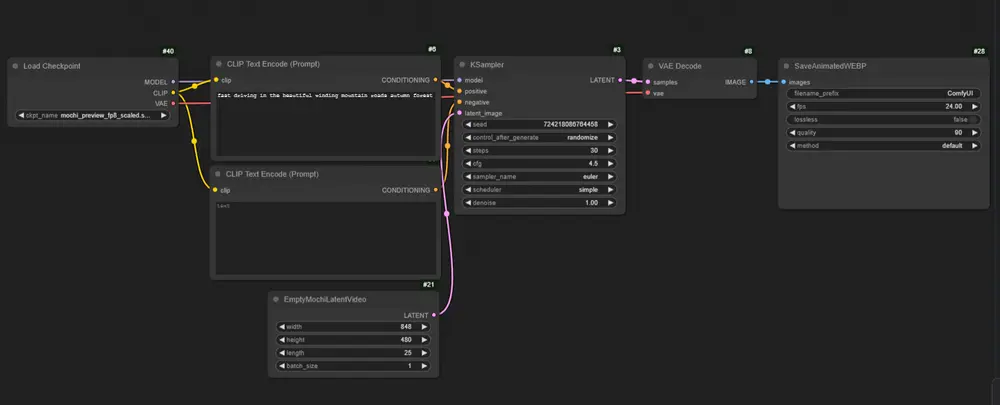

对于那些面临显存不足挑战的用户,我们提供了一些优化建议:

替换编码器:考虑用 fp8 缩放模型代替 t5xxl_fp16,以减少内存占用。 选用轻量级扩散模型:尝试 fp8_scaled 扩散模型来代替 bf16 模型,同样有助于降低资源需求。

此外,ComfyUI 还特别推出了一个集成式的打包模型,旨在简化用户的设置过程。只需按照以下步骤操作即可:

下载打包模型:将其存储在 models/checkpoint文件夹中。执行简化的工作流:依据上述指南,轻松实现高效的视频生成。

通过这些改进,ComfyUI 力求为每一位用户提供更加便捷、高效的创作工具,助力更多创意梦想的实现。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...