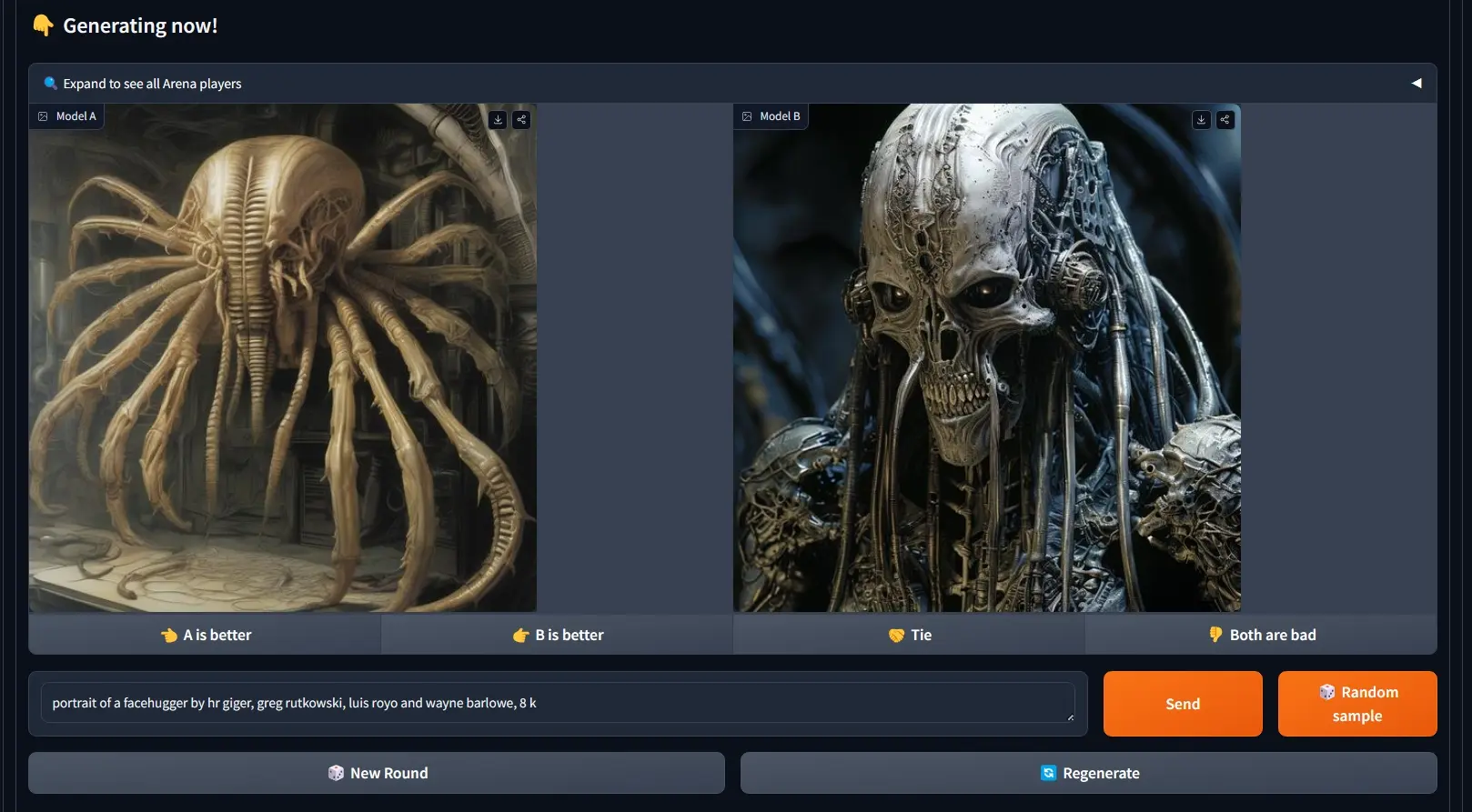

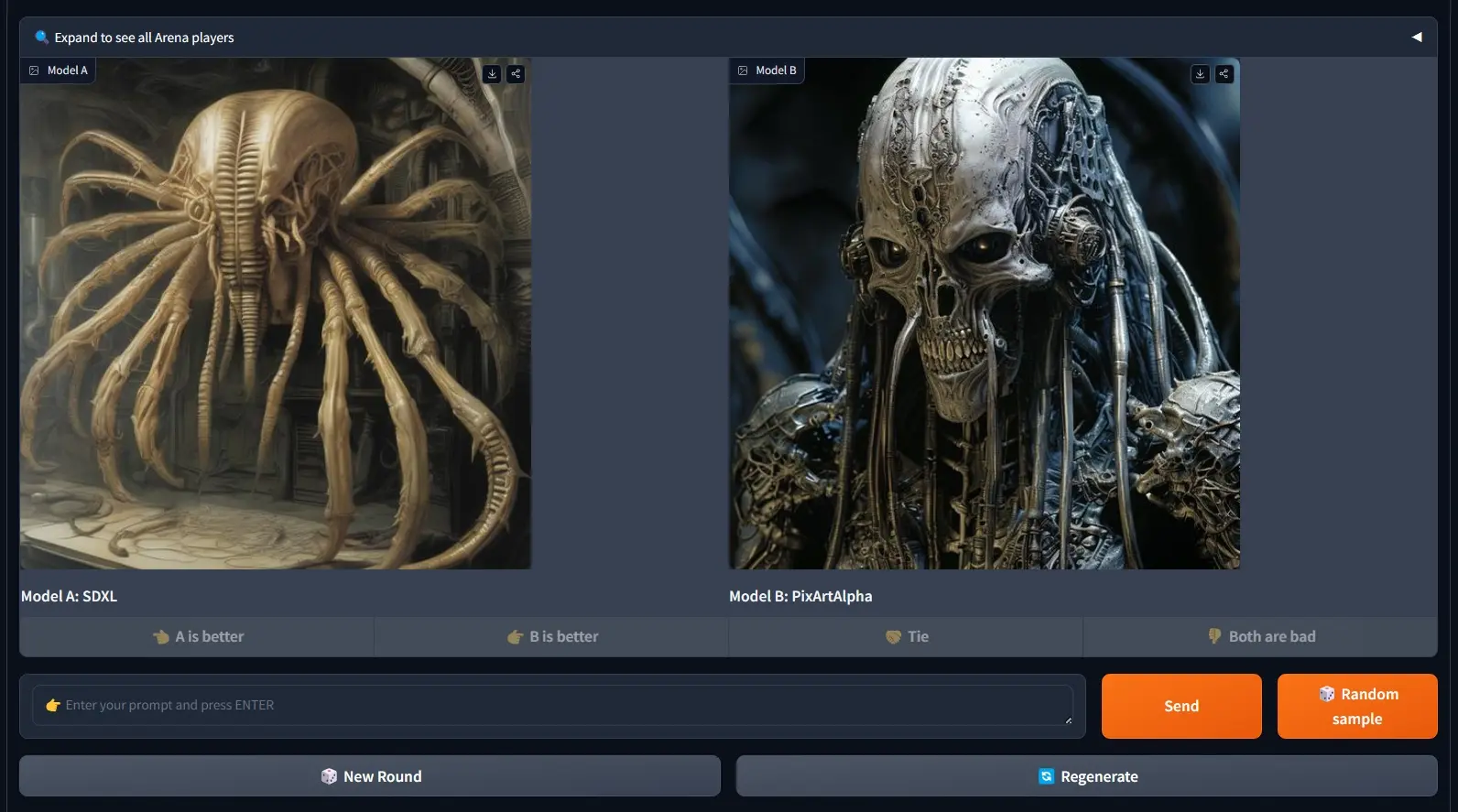

滑铁卢大学的研究人员推出了一个开放评估平台GenAI Arena,用于评估不同的图像和视频生成模型,用户可以积极参与这些模型的评估过程。通过利用集体用户反馈和投票,GENAI-ARENA旨在提供一个更加民主化且准确的模型性能衡量标准。该平台涵盖了文本到图像生成、文本到视频生成以及图像编辑三个竞技场。目前,此平台共覆盖了27个开源生成模型。GENAI-ARENA已运行四个月,累积了来自社区的超过6000票。

- GenAI Arena地址:https://huggingface.co/spaces/TIGER-Lab/GenAI-Arena

- 论文地址:https://arxiv.org/abs/2406.04485

研究人员发布论文详细介绍了平台设计,分析了数据,并解释了用于排名模型的统计方法。为了进一步推动基于模型的评估指标研究,开发者还发布了针对三项任务(文本到图像、文本到视频、图像编辑)的偏好数据精简版,即GenAI-Bench。研究人员促使现有的多模态模型如Gemini、GPT-4o模拟人类投票。通过计算模型投票与人类投票之间的相关性,以了解它们的评判能力。结果显示,现有的多模态模型在评估生成的视觉内容方面仍存在不足,即便是表现最佳的模型GPT-4o,在质量子评分上的皮尔逊相关系数也只有0.22,而在其他方面的表现则近乎随机猜测。

主要功能:

- 用户参与评估:GenAI Arena允许用户通过投票的方式,来评估不同生成模型的表现。

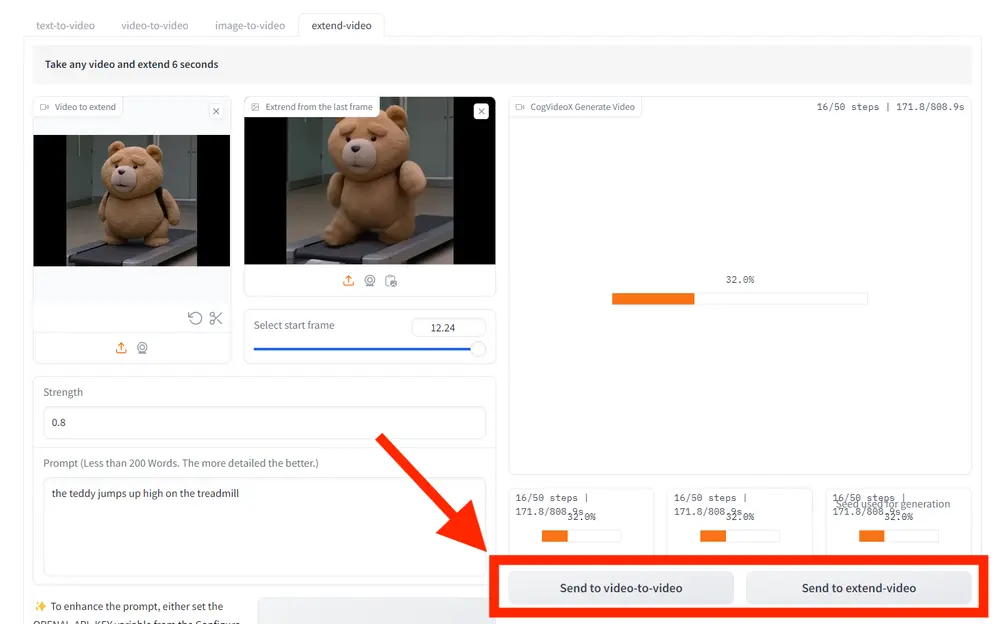

- 多任务支持:它支持三种类型的生成任务评估:文本到图像、文本到视频和图像编辑。

- 排行榜:根据用户的投票,平台会生成一个排行榜,告诉大家哪些模型在生成图像或视频方面做得最好。

主要特点:

- 开放性:这个平台是开放的,意味着任何人都可以参与进来,对模型进行评估。

- 民主性:评估结果是基于大量用户反馈和投票,这使得评估更加民主和准确。

- 透明度:所有评估过程和数据都是透明的,用户可以看到每个模型的表现和排名。

工作原理:

- 用户投票:用户对模型生成的图像或视频进行比较,并投票选择他们更喜欢的输出。

- Elo评分系统:使用Elo评分系统来计算模型的排名,这是一种常用于棋类比赛的评分机制,可以很好地反映模型之间的相对表现。

- 偏好数据:平台收集用户的偏好数据,并发布这些数据供研究者进一步分析和开发新的评估工具。

具体应用场景:

- 研究者:研究者可以使用这个平台来测试和比较他们开发的生成模型。

- 开发者:开发者可以利用用户反馈来改进他们的生成模型,提高生成图像或视频的质量。

- 普通用户:普通用户可以参与到评估过程中,帮助确定哪些模型生成的图像或视频更符合人们的审美。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...