开源音视频生成模型 LTX-2 已于发布当日集成至 ComfyUI 核心,成为首个在 ComfyUI 中获得原生支持的同步音视频基础模型。用户无需安装额外插件,即可直接调用其音画协同生成能力。

LTX-2 的设计目标是在保持高视觉质量的同时,兼顾推理效率与硬件适配性。它能在单次生成过程中同步输出视频画面、人物动作、对话语音、环境音效与背景音乐,形成协调统一的视听内容。

核心能力

- 同步音视频生成:一次推理同时输出画面与多轨音频,避免后期对齐问题;

- 高保真动态表现:人物动作自然,表情连贯,适用于叙事类短片;

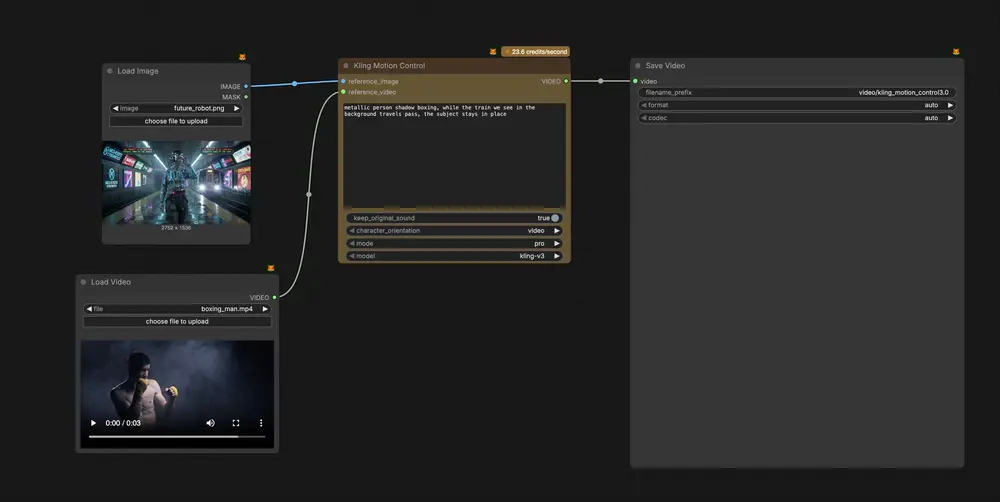

- 多模态控制支持:可通过 Canny 边缘图、深度图、人体姿态等条件引导生成;

- 关键帧驱动:支持指定起始与结束关键帧,生成中间过渡动画;

- 内置功能增强:

- 原生上采样(提升分辨率与帧率)

- 提示词自动增强(提升语义匹配度)

此外,LTX-2 采用开放权重发布,模型结构透明,便于开发者微调、集成或构建定制化管线。

如何使用?

- 更新 ComfyUI 至最新版本(桌面版与 Comfy Cloud 即将同步更新)

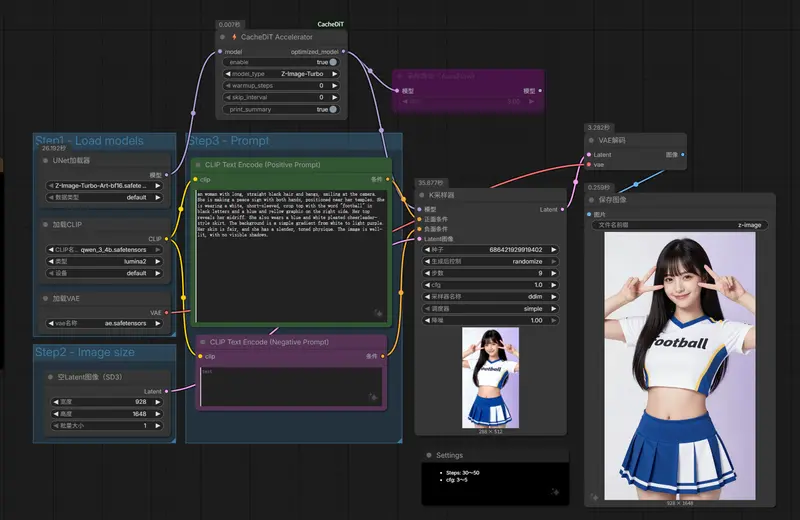

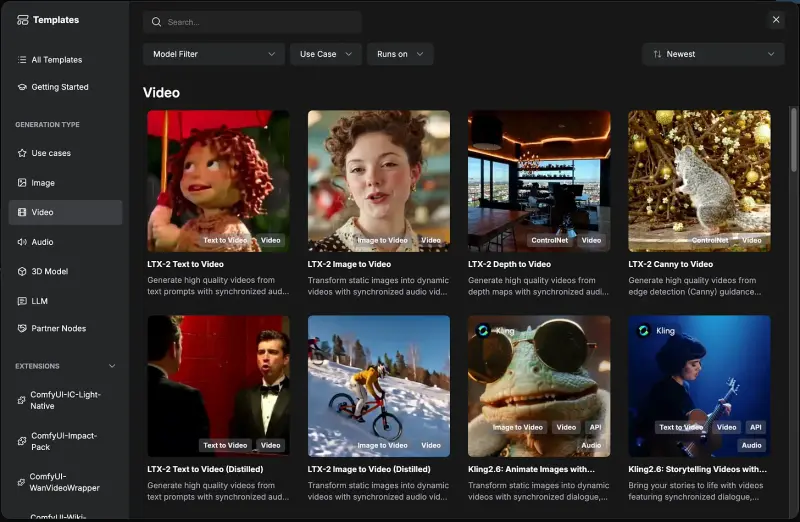

- 进入 模板库 → 视频,选择任意 LTX-2 工作流(如“文本到音视频”“图像到视频”等)

- 按提示自动下载模型文件,确认输入配置后运行

模型首次使用时会从 Hugging Face 或指定源自动下载,需确保网络通畅。工作流已预配置采样器、音频同步与内存管理策略,降低使用门槛。

系统要求

LTX-2 模型体量较大,使用前请确保满足以下硬件条件:

- GPU:CUDA 兼容显卡,显存 ≥ 32GB(如 RTX 5090、A6000、H100 等)

- 存储空间:≥ 100GB 可用磁盘空间(用于模型文件、缓存与输出)

适用场景

- 短片创作者:快速生成带配乐与音效的叙事片段

- 游戏开发者:制作 NPC 对话动画或过场视频

- AI 研究者:在本地构建可控的音视频生成实验环境

LTX-2 的本地化部署特性,使其在保障创作自由的同时,避免对云端服务的依赖。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...