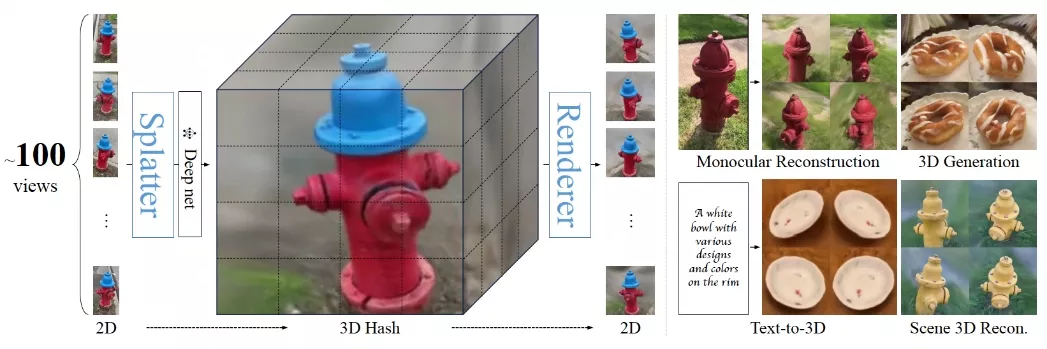

密歇根大学和Meta的研究人员推出新型框架Lightplane,它包含两个高度可扩展的组件:Lightplane Renderer和Lightplane Splatter。这两个组件专门用于处理3D神经场(neural 3D fields),即利用神经网络来表示和生成3D空间中的图像和形状。Lightplane Renderer负责从神经3D场中渲染图像,而Lightplane Splatter则负责将输入图像反投影到3D哈希结构中。这两个组件均以可微分的方式工作,从而显著节省了内存资源。例如,你是一名游戏开发者,你可以使用Lightplane从玩家提供的简单草图或描述中快速生成复杂的3D游戏环境。或者在电影制作中,艺术家可以利用这个技术将概念艺术快速转换成逼真的3D场景模型。

在当前的3D研究中,尤其是在重建和生成领域,2D图像被广泛用作输入或监督数据。然而,现有的2D-3D映射设计往往内存消耗巨大,这成为当前方法的重要瓶颈,并阻碍了新应用的发展。为了解决这个问题,开发人员提出了Lightplane Renderer和Splatter这两个高度可扩展的组件,它们显著降低了2D-3D映射中的内存使用。这些创新使得我们能够以较小的内存和计算成本处理更多数量和更高分辨率的图像。开发人员已经在各种应用中展示了这些组件的实用性,从利用图像级损失优化单场景到构建灵活的管道以实现大幅扩展的3D重建和生成。

主要功能

Lightplane的两个组件提供了以下功能:

- Lightplane Renderer:它能够将3D模型渲染成2D图像,类似于将3D场景拍成照片。

- Lightplane Splatter:它将2D图像中的信息“溅射”到3D空间中,为3D模型添加细节。

主要特点

- 内存效率:相比现有技术,Lightplane减少了四个数量级的内存使用,这使得处理大量高分辨率图像成为可能。

- 速度:尽管内存使用量大大减少,但Lightplane的速度与现有技术相当。

- 可扩展性:设计灵活,可以轻松扩展到其他3D哈希结构,如体素网格(voxel grids)和三平面(triplanes)。

工作原理

Lightplane通过以下方式工作:

- Lightplane Renderer:它不是存储每个3D点的中间计算结果,而是沿着光线(ray)顺序计算特征(如颜色)和密度,这样可以在不存储中间张量的情况下更新渲染像素和透射率。

- Lightplane Splatter:它将2D信息“溅射”到3D表示上,允许神经网络进一步处理。这是通过将特征直接存储到支撑3D模型的哈希结构中来实现的,而不是为每个3D点发出一个值。

具体应用场景

- 单场景优化:使用高分辨率图像级别的损失函数来优化3D场景的细节。

- 多视图重建:结合多个视角的图像来重建一个3D模型。

- 3D生成:使用扩散模型从2D图像生成3D场景。

- 文本到3D:根据文本描述生成相应的3D模型。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...