过去十年,机器学习取得了显著进步,强大的神经网络架构与训练算法推动了大语言模型的快速发展。但一个核心挑战始终存在:持续学习能力的缺失。当前AI在更新新信息、学习新技能时,往往会清除原有知识,导致旧任务性能下降——这一现象被称为“灾难性遗忘”,也让AI的知识局限于预训练静态信息或即时输入上下文,难以像人类一样持续积累经验。

谷歌研究部门提出的“嵌套学习”技术,正为解决这一困境带来突破性进展。这项发表于NeurIPS 2025的研究,不仅实现了对AI模型架构与优化算法认知的范式转移,更成功模拟人脑神经可塑性机制,为构建真正的持续学习AI奠定了基础。

核心痛点:AI“灾难性遗忘”的底层困境

持续学习是AI向更智能阶段发展的关键——无论是自动驾驶系统适应新路况,还是医疗AI更新临床指南,都需要模型在吸收新知识的同时保留旧技能。但传统方法存在本质缺陷:

- 简单用新数据更新模型参数,必然导致旧任务熟练度下降,形成“学新忘旧”的恶性循环。

- 长期以来,研究界将模型架构(网络结构)与优化算法(训练规则)视为独立实体,这种分离式设计阻碍了统一高效学习系统的构建。

- 现有大语言模型的记忆管理局限于“短时-长时”二分结构,无法像人脑一样灵活处理不同时间尺度的知识存储与调用。

这种困境让AI始终难以实现真正的自我改进,而人类大脑通过神经可塑性——根据新经历改变自身结构的能力,完美解决了这一问题,也成为谷歌嵌套学习的核心灵感来源。

技术革新:嵌套学习的核心原理

嵌套学习的核心突破,是将单个机器学习模型重新定义为“相互连接的多级嵌套优化问题系统”,而非单一的连续学习过程。其关键设计包括三大要点:

1. 架构与优化的统一整合

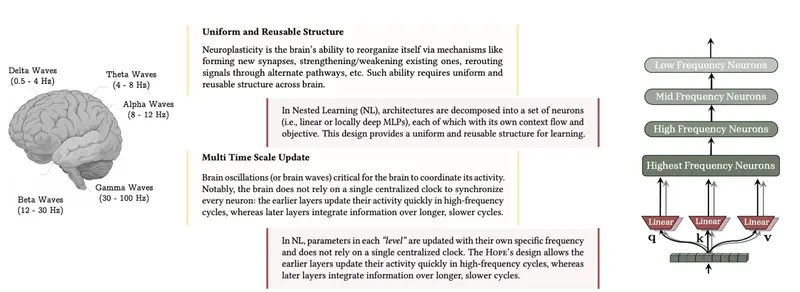

嵌套学习打破了“架构与优化分离”的传统认知,认为二者本质是同一概念的不同“级别”。每个级别都有独立的内部信息流(“上下文流”)和更新速率,通过同步优化实现知识的分层积累。

2. 多时间尺度更新模拟神经可塑性

借鉴人脑“局部适应新经验不清除旧记忆”的机制,嵌套学习为每个子问题设计“多时间尺度更新”技术。不同模块按各自频率调整权重,就像大脑不同区域各司其职,既接纳新信息,又保留已有知识,从底层避免灾难性遗忘。

3. 连续记忆系统(CMS)重构记忆管理

不同于传统Transformer的“短时-长时”二分记忆,嵌套学习提出“连续记忆系统”。记忆被视为按不同频率更新的模块谱系,形成更丰富、有序的长期数据管理模式,让AI能灵活调用不同时期的知识。

实践验证:Hope模型的性能突破

为验证嵌套学习的有效性,谷歌设计了概念验证模型“Hope”——一款基于Titans架构改进的自修改循环架构。其核心优势在于能通过自引用过程优化自身记忆系统,支持无界级别的上下文学习。

实验结果显示,Hope模型在多项任务中表现突出:

- 长上下文记忆挑战(如“草垛寻针”任务)中,持续超越现有顶尖模型,能精准回忆长文档中的细微信息。

- 通用语言建模与常识推理任务中,展现出更低的困惑度和更高的准确率。

- 持续学习与知识融入任务中,成功实现“学新不忘旧”,验证了嵌套学习对抗灾难性遗忘的有效性。

此外,嵌套学习还为优化器设计提供了新思路。通过将优化器视为关联记忆模块,谷歌推导出动量新公式,使其对不完美数据更具鲁棒性,进一步提升了模型的稳定性。

未来展望:从技术突破到实际应用

嵌套学习范式的提出,不仅解锁了AI设计的新维度,更弥合了当前大语言模型与人类持续学习能力之间的差距。谷歌表示,这项技术有望应用于未来版本的Gemini模型,但具体落地时间表尚未公布。

从长远来看,嵌套学习的影响可能延伸至更多AI领域:自动驾驶系统可持续吸收路况经验,医疗AI能实时更新诊疗知识,智能助手可伴随用户成长优化服务。这一技术的核心价值,在于让AI真正具备“积累式学习”的能力,向更接近人类认知模式的方向迈出了关键一步。(来源)

相关文章

![ComfyUI已支持 FLUX.2 [klein]:4B 模型实现 1.2 秒本地图像生成与编辑](https://pic.sd114.wiki/wp-content/uploads/2026/01/1768500082-1768500082-FLUX.2-klein-4.webp~tplv-o4t1hxlaqv-image.image)