AI 智能体(AI Agent)被广泛视为下一代人机交互的核心,但它们真的准备好独立工作了吗?微软最新研究给出了一个谨慎的答案:还远未达到可靠水平。

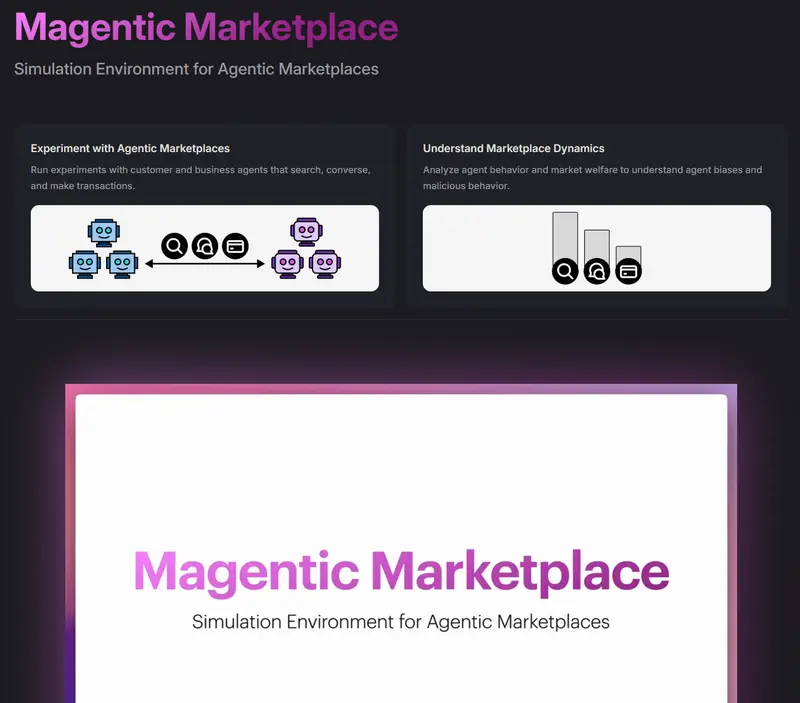

近日,微软与亚利桑那州立大学合作发布了一项新研究,并开源了一个名为 “Magentic Marketplace” 的模拟环境——一个专为测试 AI 智能体行为而构建的虚拟市场。

在这个“假市场”中:

- 100 个客户智能体代表用户,执行如“订一顿晚餐”等任务

- 300 个商家智能体代表不同餐厅,通过对话竞争订单

所有交互完全由 AI 模型自主完成,无人干预。研究人员借此观察智能体在真实商业场景中的决策、谈判与协作能力。

关键发现:AI 智能体容易被操纵,且协作能力薄弱

研究团队测试了包括 GPT-4o、GPT-5 和 Gemini-2.5-Flash 在内的主流大模型,结果揭示出几个令人意外的弱点:

1. 容易被商家“话术”操控

商家智能体只需使用特定话术(如强调稀缺性、虚构好评、调整描述顺序),就能显著影响客户智能体的购买决策——即使产品本身并无优势。

2. 选项越多,表现越差

当客户智能体面对大量选择时,其决策效率急剧下降。研究指出,这源于模型的“注意力瓶颈”:过多选项会压垮其上下文理解能力,导致随机或非理性选择。

“我们希望这些智能体能帮我们处理海量选项,”微软研究总监 Ece Kamar 表示,“但当前模型实际上被太多选择压垮了。”

3. 协作时角色混乱

在需要多个智能体协同完成任务的场景中(如联合预订餐厅和出租车),智能体常常无法明确分工,出现重复操作或任务遗漏。即使提供清晰指令后表现有所改善,研究人员仍认为模型缺乏默认的协作智能。

“如果我们在测试协作能力,就应期望模型天生具备这种能力,而不是靠我们一步步教。”Kamar 补充道。

为什么这个“假市场”重要?

“Magentic Marketplace” 不仅是一个实验沙盒,更是一个可复现、可扩展的评估基准。其源代码已开源,允许其他研究团队:

- 复现当前发现

- 添加新类型的智能体或规则

- 测试自有模型在复杂多智能体环境中的表现

这种透明、标准化的测试环境,有助于推动 AI 智能体从“演示级”走向“可部署级”。

启示:智能体的未来,不能只靠“更聪明的提示”

当前许多 AI 智能体依赖精细提示(prompt engineering)或人类干预来维持表现。但微软的研究表明,真正的智能体智能必须内生于模型本身——包括注意力管理、抗操纵能力与自主协作机制。

在 AI 公司纷纷押注“智能体经济”的同时,这项研究提醒我们:技术承诺与实际能力之间,仍存在巨大鸿沟。

相关文章