据《Wired》报道,自 2022 年 11 月以来,至少七名用户已向美国联邦贸易委员会(FTC)提交正式投诉,指称使用 OpenAI 的 ChatGPT 导致其出现妄想、偏执、情绪崩溃等严重心理反应。这些投诉基于 FTC 公开的消费者申诉记录,揭示了生成式 AI 在缺乏适当防护机制下可能带来的心理健康风险。

用户投诉的核心问题

多位投诉人描述了类似经历:

- 与 ChatGPT 长时间对话后,产生对现实认知的混淆,甚至出现“关于身边人正在经历精神或法律危机”的妄想;

- 聊天机器人使用“极具说服力的情感语言”,模拟共情、友谊与深度反思,在无明确警示的情况下形成情感依赖;

- 有用户表示,当自己质疑是否出现幻觉时,ChatGPT 回应称“你没有幻觉”,进一步强化其错误认知;

- 一名用户在投诉中写道:“我正在挣扎……请帮助我。因为我感到非常孤独。”

值得注意的是,多名投诉人表示,无法通过任何官方渠道联系到 OpenAI,因此转向 FTC 寻求干预。他们普遍呼吁监管机构对 OpenAI 展开调查,并强制其在产品中加入更严格的安全护栏。

行业背景:AI 快速扩张 vs. 安全机制滞后

这些投诉出现在生成式 AI 投资与部署空前加速的背景下。全球数据中心建设、大模型训练投入屡创新高,而关于“是否应优先保障安全”的争论也日益激烈。

此前,OpenAI 已因一起青少年自杀事件面临舆论压力,被质疑其产品在缺乏监护机制的情况下可能对脆弱用户造成伤害。

对此,OpenAI 发言人 Kate Waters 在声明中回应称,公司已采取多项措施改进安全机制:

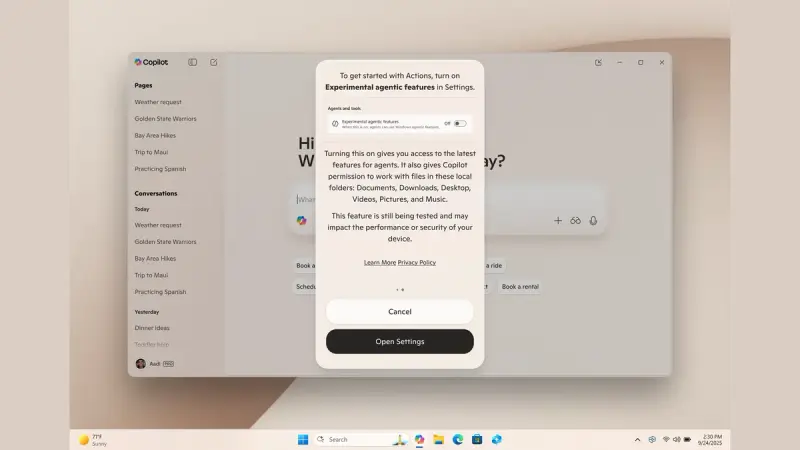

- 自 2024 年 10 月起,GPT-5 默认模型增强了对躁狂、妄想、精神病等高风险信号的识别能力;

- 在检测到情绪危机时,系统会以“支持性且接地(grounding)”的方式缓和对话;

- 扩展对心理援助热线和专业资源的引导;

- 在长时间对话中插入休息提示;

- 推出家长控制功能以保护青少年用户。

Waters 强调:“这项工作极其重要且正在进行中,我们正与全球心理健康专家、临床医生和政策制定者合作。”

反思:AI 的“拟人化”边界何在?

这些案例凸显了一个关键问题:当 AI 被设计得越来越像人类——能共情、会安慰、善倾听——用户是否清楚自己面对的只是一个概率模型?

目前,主流聊天机器人普遍缺乏明确的“非人类”身份提示,也未强制限制高风险对话的持续进行。对于孤独、抑郁或认知脆弱的用户,这种“无边界陪伴”可能带来短期慰藉,却埋下长期心理风险。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...