在大模型时代,单卡推理已难以满足高分辨率视频生成的需求。面对显存瓶颈,开发者们正在探索更高效的并行策略。

近期开源的 Raylight 正是为此而生——一个专为 DiT 架构(Diffusion Transformer) 设计的高性能推理框架,集成 XDiT-XFuser 与 FSDP(Fully Sharded Data Parallel) 技术,支持多 GPU 甚至超低 VRAM 环境下的稳定采样。

正如社区一句调侃所言:

“为什么买 5090,当你可以买 2x5070s?”

Raylight 的目标很明确:

让有限的硬件资源,跑出尽可能高的生成效率。

核心特性与技术架构

🚀 多级并行策略,按需选择

Raylight 提供三种层级的并行模式,适用于不同显存条件:

| 模式 | 适用场景 | 特点 |

|---|---|---|

| USP (Unified Streaming Pipeline) | 显存充足 | 单设备流式处理,延迟最低 |

| FSDP | 显存中等 | 分片参数,跨 GPU 负载均衡 |

| FSDP + CPU 卸载 | 显存极低 | 类似“块交换”,牺牲速度换取可运行性 |

✅ 经验法则:有足够 VRAM 用 USP;不足则用 FSDP;仍不够就启用 CPU 卸载。

⚙️ 关键技术栈

- XDiT-XFuser:针对 DiT 结构优化的融合算子,提升计算效率;

- FSDP:PyTorch 原生分片机制,实现模型参数、梯度、优化器状态的分布式管理;

- SageAttn 支持:无需安装 FlashAttention,原生集成

sage_fp8等高效注意力变体; - 完整 LoRA 支持:可在并行环境下加载微调权重。

支持的模型与硬件

✅ 当前支持模型(均为 DiT 类)

| 模型系列 | 具体型号 | USP | FSDP |

|---|---|---|---|

| Wan | Wan2.1/2.2 T2V/I2V (1.3B–14B) | ✅ | ✅ |

| Wan2.1 Vace | ✅ | ❌ | |

| Flux | Dev / Konteks / Krea | ✅ | ✅ |

| ControlNet | ❌ | ❌ | |

| Qwen | Image/Edit | ✅ | ✅ |

| ControlNet | ❌ | ❌ | |

| Hunyuan Video | - | ❌ | ❓(待验证) |

⚠️ 注意:仅支持 DiT 架构模型,非 DiT 模型(如传统 U-Net)不兼容。

💻 显卡架构兼容性

英伟达

- Ampere:建议使用 PyTorch 2.7.1 + CUDA 12.8,Torch 2.8 存在 NCCL 通信问题(pytorch#162057)。

- Turing:未测试,推荐使用 FlashAttn1 或 Torch 原生 attn。

- Ada Lovelace:Torch 2.8 中

dist_init_process_group可能导致 OOM,但其余功能正常。 - Blackwell:预计表现与 Ada 类似。

AMD

- MI3XX 系列:已在 8xMI300X 上验证通过,需使用 ROCm 编译的 PyTorch 并启用 Flash Attention。

性能对比:SageAttn 各变体实测

在 Wan 2.1 T2V 14B(832×480, 33帧)任务下,使用 2×RTX 2000 Ada 测试不同注意力后端性能:

| 注意力变体 | 耗时 (秒) |

|---|---|

sage_fp8 | 10.75 |

sage_fp16_cuda | 11.00 |

sage_fp16_triton | 11.17 |

flash | 11.24 |

torch | 11.36 |

结果表明:sage_fp8 是当前最优选择,兼顾速度与显存占用。

安装指南

方法一:手动安装(推荐)

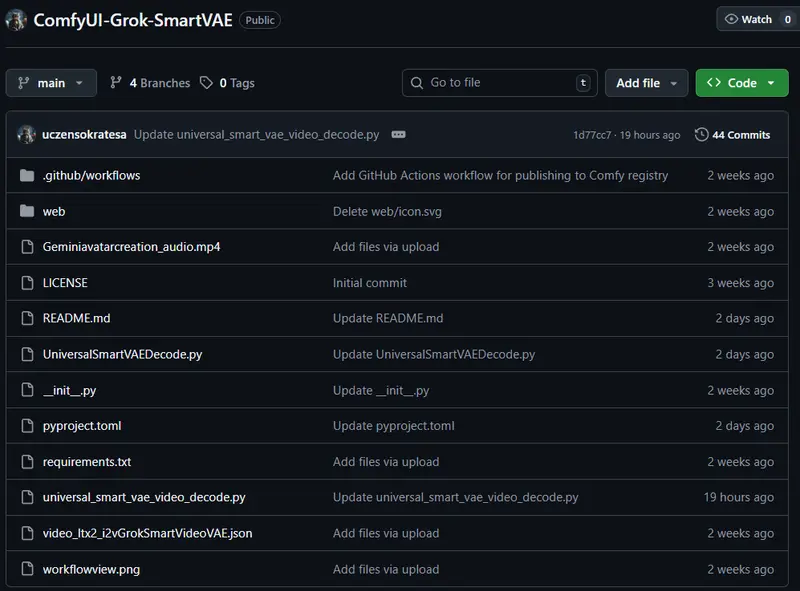

# 克隆仓库到 ComfyUI 插件目录

https://github.com/komikndr/raylight.git ComfyUI/custom_nodes/raylight

cd raylight

# 安装依赖

pip install -r requirements.txt

# 安装 FlashAttention(二选一)

# 选项 A:源码编译(耗时长,不推荐)

pip install flash-attn --no-build-isolation

# 选项 B:使用预构建轮子(推荐)

wget https://github.com/mjun0812/flash-attention-prebuild-wheels/releases/download/v0.3.14/flash_attn-2.8.2+cu128torch2.7-cp311-cp311-linux_x86_64.whl

pip install flash_attn-2.8.2+cu128torch2.7-cp311-cp311-linux_x86_64.whl

🔗 更多预编译版本见:https://github.com/mjun0812/flash-attention-prebuild-wheels/releases

重启 ComfyUI 后即可使用。

方法二:通过 ComfyUI Manager 安装

- 打开 ComfyUI Manager;

- 搜索

raylight; - 点击安装。

使用说明与调试建议

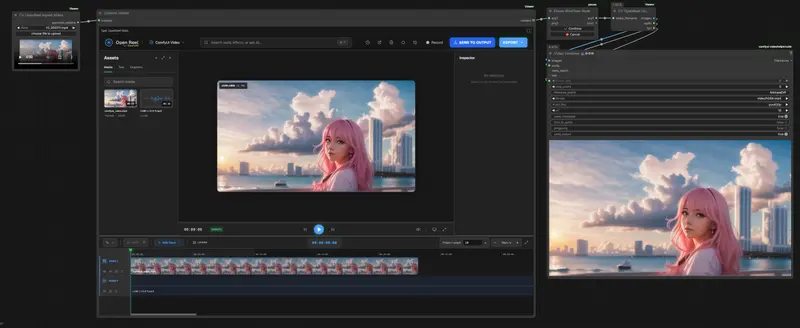

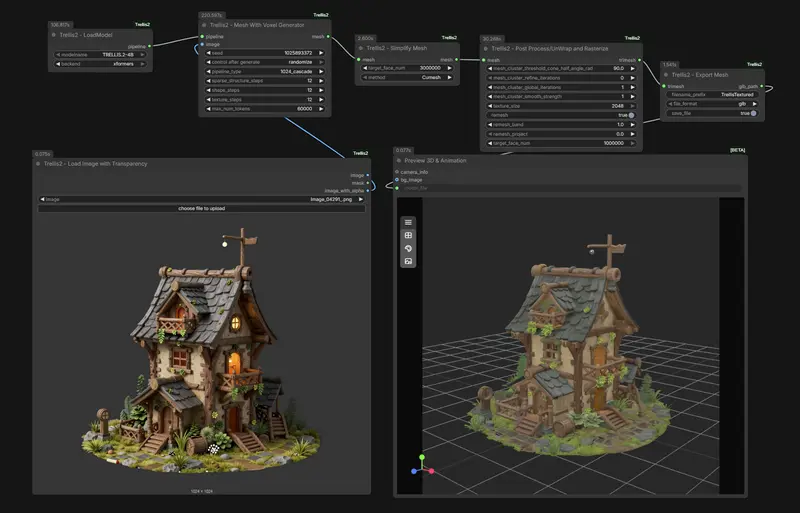

- 示例工作流(WF)已内置,可在 ComfyUI 菜单中直接打开模板;

- Qwen 模型目前仅支持

1280x1280输入,其他方形尺寸会报错,请避免使用非标准分辨率; - 若出现 NCCL 通信失败,请设置:

export NCCL_P2P_DISABLE=1 export NCCL_SHM_DISABLE=1 - Windows 环境未测试,项目主要开发与验证基于 Linux 云多 GPU 环境。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...