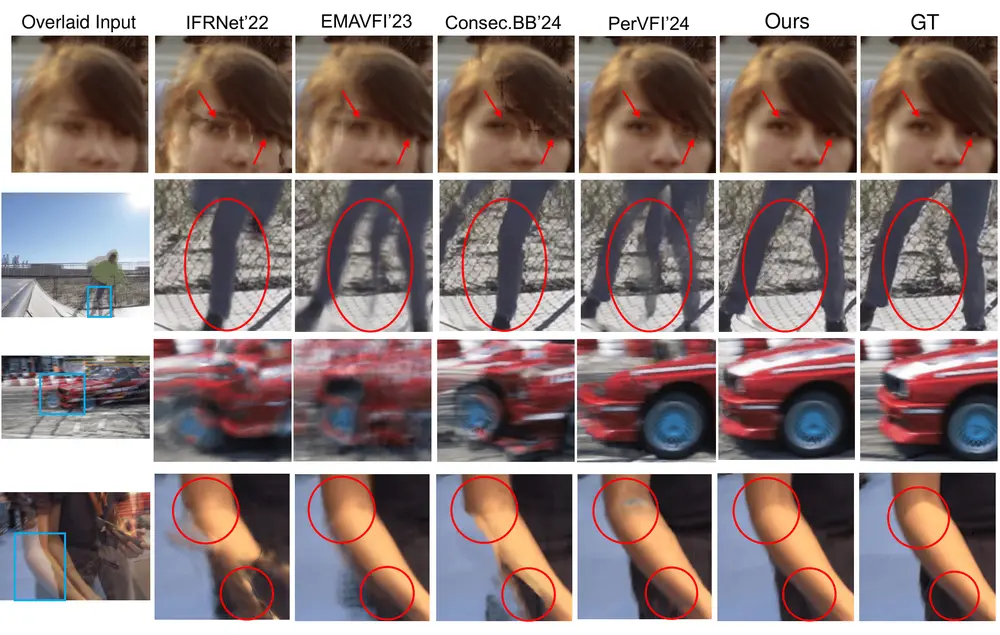

随着生成式 AI 在视频处理领域的深入发展,高质量的视频帧插值(VFI) 已成为提升动态内容流畅度的关键技术。基于中央佛罗里达大学提出的 TLB-VFI 模型,社区开发者推出了 ComfyUI-TLBVFI ——一个专为 ComfyUI 设计的自定义节点包,让普通用户也能在可视化工作流中实现专业级的帧率提升。

该项目将复杂的扩散模型封装为易用节点,支持高精度中间帧生成,并可灵活控制插值密度,适用于动画增强、视频修复与创意视觉表达。

核心功能

| 功能 | 说明 |

|---|---|

| 高质量帧插值 | 基于 TLB-VFI 的潜在扩散架构,生成自然、清晰且时序一致的中间帧,尤其擅长处理大运动、遮挡与边缘细节。 |

| 多级倍速插值 | 支持通过 times_to_interpolate 参数实现 2×、4×、8× 甚至更高帧率扩展(每对原始帧生成 1、3、7 帧)。 |

| 模块化集成 | 完全兼容 ComfyUI 工作流,可与图像加载、视频解码、保存等节点无缝衔接。 |

| 轻量高效推理 | 利用潜在空间建模,在保持高画质的同时降低计算开销,适合本地 GPU 环境运行。 |

🔧 安装步骤

请按顺序完成以下配置,确保节点正常运行。

方式一:通过 ComfyUI-Manager(推荐)

在 ComfyUI-Manager 的“Custom Nodes”标签页中搜索 ComfyUI-TLBVFI,点击安装即可。

方式二:手动安装

步骤 1:手动克隆

cd ComfyUI/custom_nodes/

git clone https://github.com/BobRandomNumber/ComfyUI-TLBVFI.git

提示:克隆后请勿重命名文件夹。

步骤 2:安装依赖

进入节点目录并安装所需 Python 包:

cd ComfyUI/custom_nodes/ComfyUI-TLBVFI/ pip install -r requirements.txt

步骤 3:下载预训练模型

模型文件仅需一个:vimeo_unet.pth

🔗 下载地址:https://huggingface.co/ucfzl/TLBVFI

该模型在 Vimeo90K 数据集上训练,专为通用场景优化,具备良好的泛化能力。

步骤 4:放置模型文件

将 vimeo_unet.pth 放置在 ComfyUI 的模型目录下:

ComfyUI/

└── models/

└── interpolation/

└── tlbvfi_models/ # 可选:用于组织多个模型

└── vimeo_unet.pth

✅ 节点会自动扫描

models/interpolation/目录及其子目录,无需手动指定绝对路径。

🛠️ 高级用法:若需使用自定义路径,可在

ComfyUI/extra_model_paths.yaml中添加:interpolation: - /your/custom/path/tlbvfi_models

步骤 5:重启 ComfyUI

重启后,节点将被加载。可在节点浏览器中搜索 TLBVFI 或在分类 frame_interpolation/TLBVFI 下找到它。

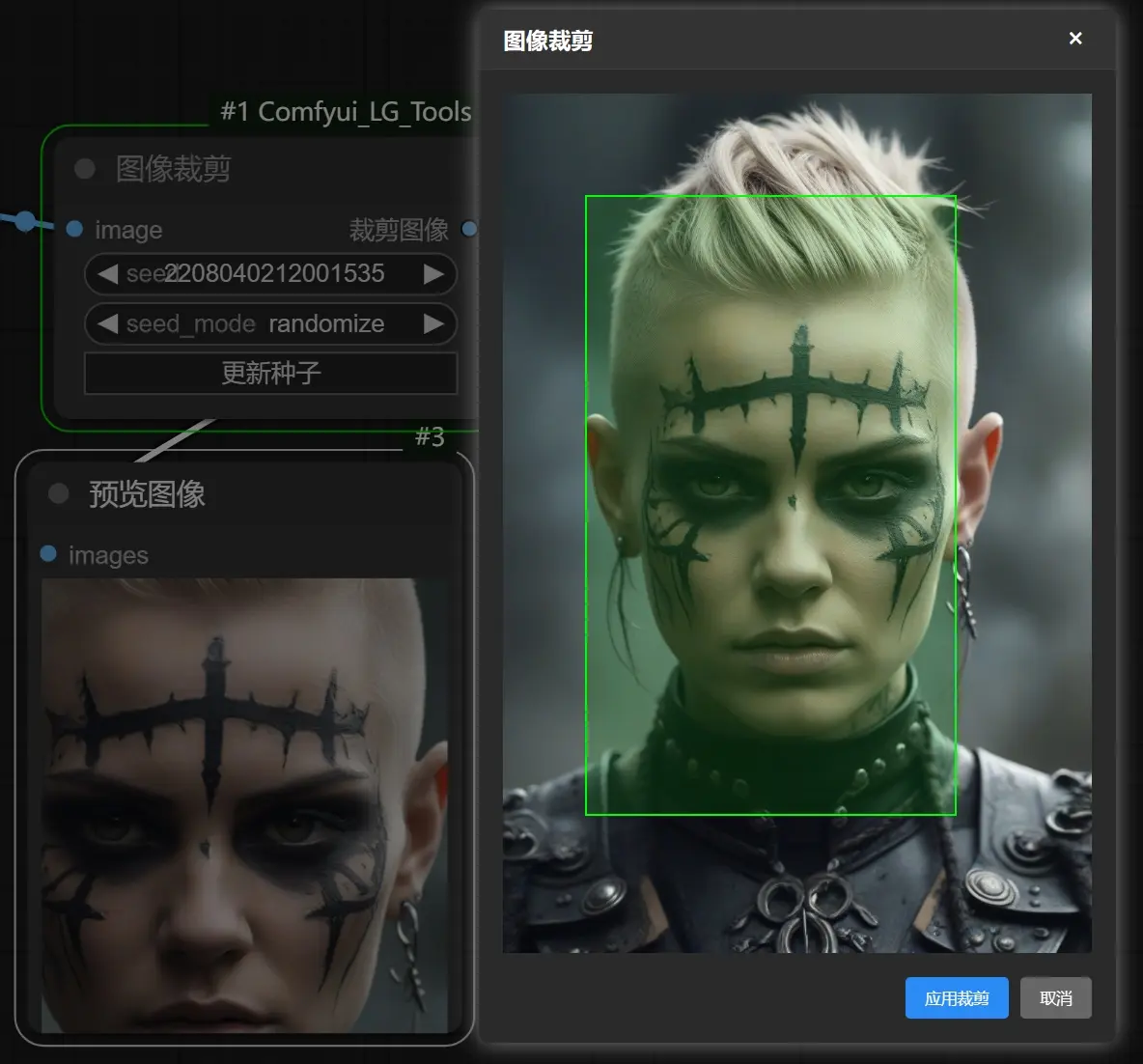

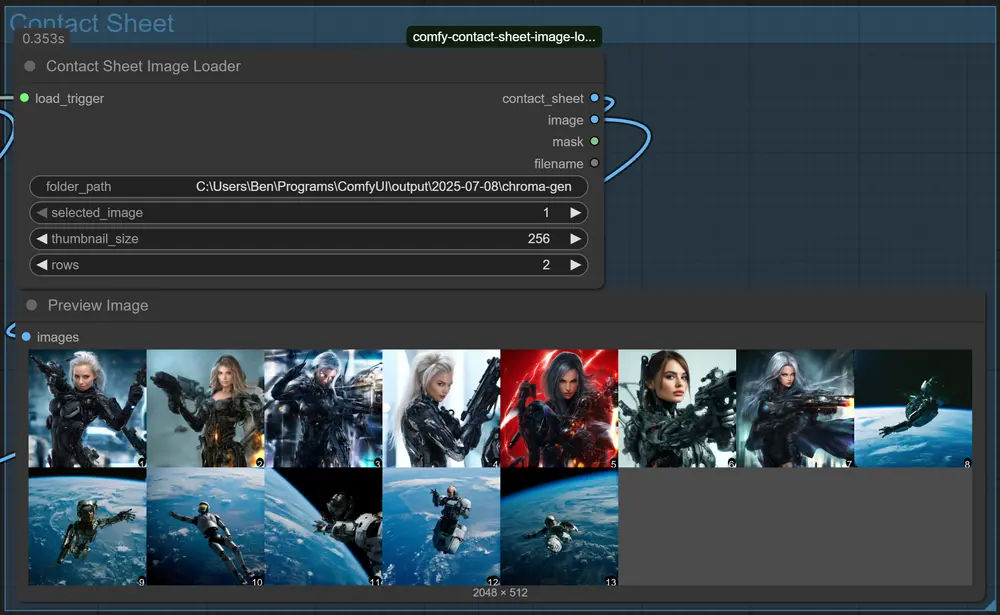

🚀 使用方法

- 加载视频或图像序列

- 使用

Load Video节点读取视频并提取帧; - 或使用

Load Image Batch加载一组有序图像。

- 使用

- 添加 TLBVFI 插值节点

- 拖入

TLBVFI Frame Interpolation节点; - 连接图像输出至

images输入端口。

- 拖入

- 选择模型

- 在

model_name下拉菜单中选择vimeo_unet.pth; - 若存放在子目录,显示为

tlbvfi_models/vimeo_unet.pth。

- 在

- 设置插值倍数

times_to_interpolate = 1:每两帧间插入 1 帧 → 输出帧数 ×2times_to_interpolate = 2:插入 3 帧 → ×4times_to_interpolate = 3:插入 7 帧 → ×8

示例:输入 30fps 视频,设置为 2,则输出接近 120fps 的平滑序列。

- 查看或保存结果

- 将输出连接至

Preview Image实时查看; - 或通过

Save Image保存为图像序列或编码为新视频。

- 将输出连接至

🧠 背后原理:为什么效果更好?

ComfyUI-TLBVFI 的核心是 TLB-VFI 论文中的三大创新整合:

| 组件 | 作用 |

|---|---|

| VQGAN 自编码器 | 将原始图像压缩至低维潜在空间,保留关键纹理与结构信息,减少后续计算负担。 |

| 布朗桥扩散(Brownian Bridge Diffusion) | 在潜在空间中对时间轴建模,确保生成帧在运动轨迹上连续且稳定,避免跳变或抖动。 |

| UNet 扩散主干 | 基于起始帧和结束帧的潜在表示,预测中间状态,实现高质量插值。 |

整个过程在潜在空间完成,兼顾效率与质量,是当前少有的能在消费级 GPU 上运行的高质量扩散 VFI 方案。

注意事项与建议

- 显存要求:建议至少 6GB 显存(输入分辨率 ≤ 720p);

- 性能提示:插值倍数越高,推理时间呈指数增长,请根据硬件合理设置;

- 输入顺序:确保图像按时间顺序输入,否则会导致运动错乱;

- 边界处理:首尾帧无法插值,输出序列长度 = (原始帧数 - 1) × (插值倍数对应的新帧数) + 1。

相关文章