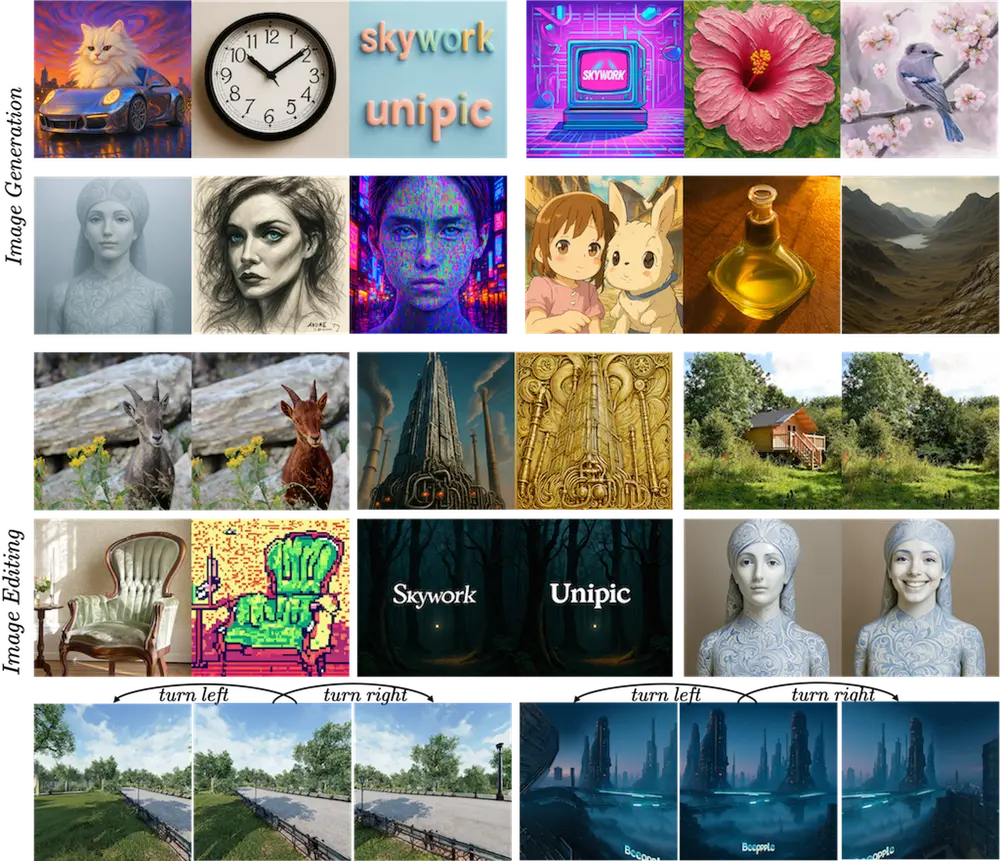

天工AI正式推出 UniPic-2.0 系列模型,基于 SD3.5-Medium 架构与创新训练策略,在文本到图像生成、细粒度图像编辑和多模态理解任务中实现全面性能突破。

- GitHub:https://github.com/SkyworkAI/UniPic/blob/main/UniPic-2/README.md

- 模型:https://huggingface.co/collections/Skywork/skywork-unipic2-6899b9e1b038b24674d996fd

该系列包含两个核心变体:UniPic2-SD3.5M-Kontext 和 UniPic2-MetaQuery,均采用高效架构设计与渐进式强化学习方法,在保持低计算成本的同时,达到当前开源模型中的领先水平。

所有模型权重与实现代码已开源,发布于 Hugging Face 平台,开发者可自由下载使用,构建高性能图像生成与编辑应用。

目前提供以下检查点:

| 模型名称 | 类型 | 是否含 RL 训练 |

|---|---|---|

Skywork/UniPic2-SD3.5M-Kontext-2B | 基础版本 | 否 |

Skywork/UniPic2-SD3.5M-Kontext-GRPO-2B | GRPO 强化版 | 是 |

Skywork/UniPic2-MetaQuery-2B | MetaQuery 版本 | 是 |

- 推荐使用

-GRPO版本用于实际部署; - 支持 Diffusers 接口调用,兼容主流推理框架;

- 提供详细文档与示例脚本,便于快速上手。

UniPic-2.0 是什么?

UniPic-2.0 是一个统一的多模态生成模型系统,专注于将图像生成、图像编辑与多模态理解能力集成于单一框架下。它不依赖庞大参数规模,而是通过架构优化与训练策略创新,实现高效率与高性能的平衡。

其核心目标是:

- 支持高质量文本到图像生成;

- 实现精确可控的图像编辑;

- 融合视觉理解能力,支持跨模态推理;

- 提供轻量、可部署、易扩展的开源方案。

核心特性与技术创新

UniPic2-SD3.5M-Kontext:轻量级统一模型

基于 Stable Diffusion 3.5 Medium(2B参数) 架构进行重构,UniPic2-SD3.5M-Kontext 在仅 20 亿参数条件下,支持:

- 高分辨率文本到图像生成;

- 精细指令驱动的图像编辑(如对象替换、风格迁移);

- 动态分辨率输出,适应多种场景需求。

尽管参数量远小于同类模型(如 Flux-Kontext 12B、BAGEL 7B),其在多个基准测试中仍实现反超,展现出卓越的性价比。

渐进式双任务强化(PDTR):首次实现生成与编辑协同优化

传统多任务训练常面临“任务干扰”问题:图像生成与图像编辑的目标差异导致梯度冲突,影响整体性能。

UniPic-2.0 提出 渐进式双任务强化(Progressive Dual-Task Reinforcement, PDTR),一种分阶段的在线强化学习策略:

- 第一阶段:强化图像编辑能力

固定生成模块,单独优化编辑路径,提升对输入图像和编辑指令的理解一致性。 - 第二阶段:强化文本到图像生成能力

在编辑能力稳定的基础上,进一步优化生成质量与文本对齐度。

通过解耦训练流程,PDTR 有效避免任务间干扰,显著提升模型在 指令遵循 和 跨任务一致性 上的表现。

实验表明,经过 GRPO(Generalized Reward Policy Optimization)强化后的模型(后缀

-GRPO),在复杂描述生成与精细编辑任务中平均提升超过 15%。

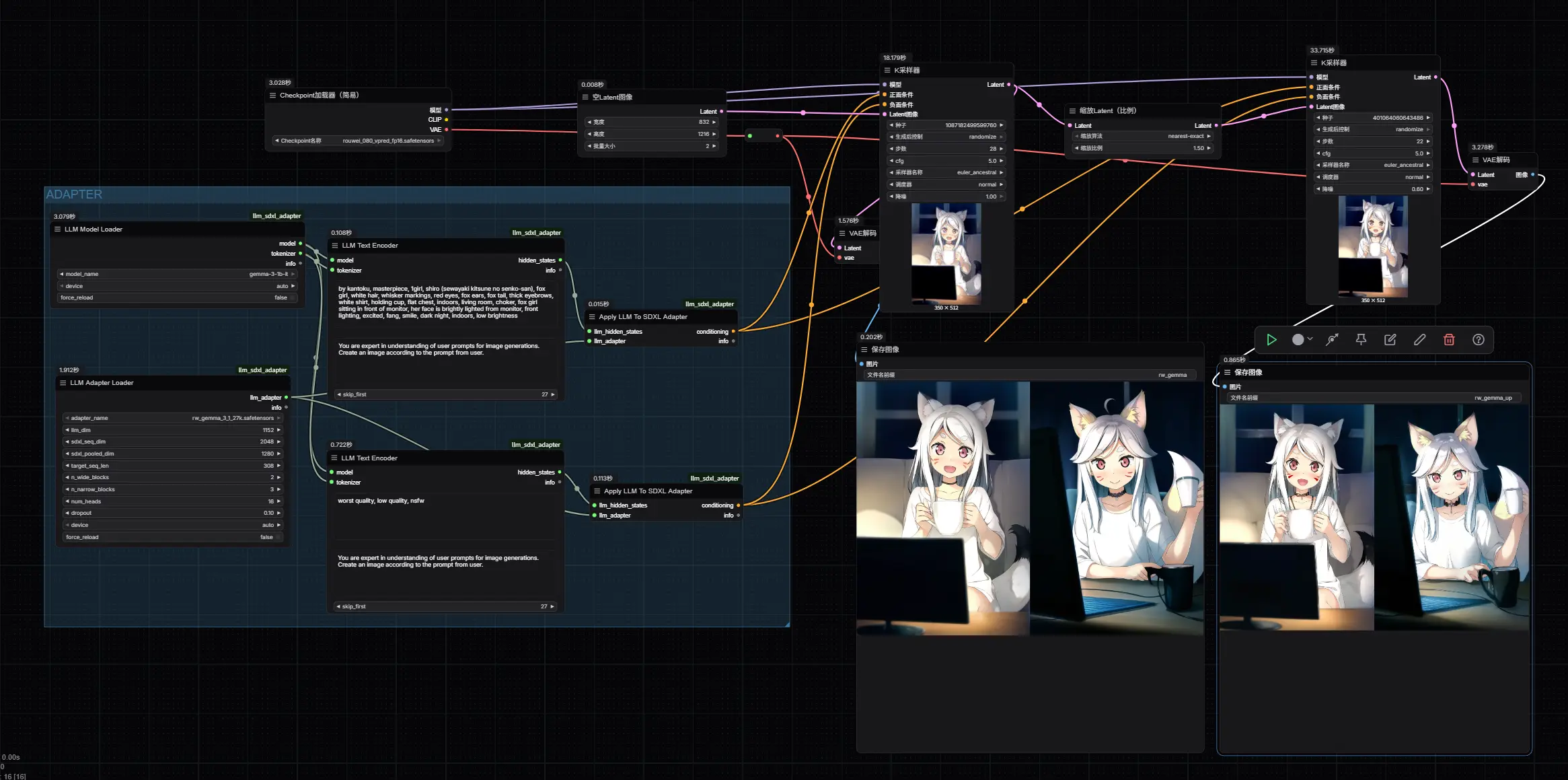

UniPic2-MetaQuery:模块化统一建模范式

针对统一建模中的灵活性不足问题,团队提出 MetaQuery 架构——一种参数高效的模块化连接方式。

其核心思想是:

- 保留原始生成模型冻结;

- 引入小型可训练连接器(connector),桥接生成模块与多模态理解模型 Qwen2.5-VL-7B;

- 支持端到端的“理解 → 编辑 → 生成”闭环。

这一设计带来三大优势:

- 训练成本低:仅需微调连接器;

- 泛化能力强:可适配不同理解或生成 backbone;

- 易于扩展:支持插件式功能集成。

在多跳图像推理、图文问答等任务中,MetaQuery 展现出强大的跨任务泛化能力。

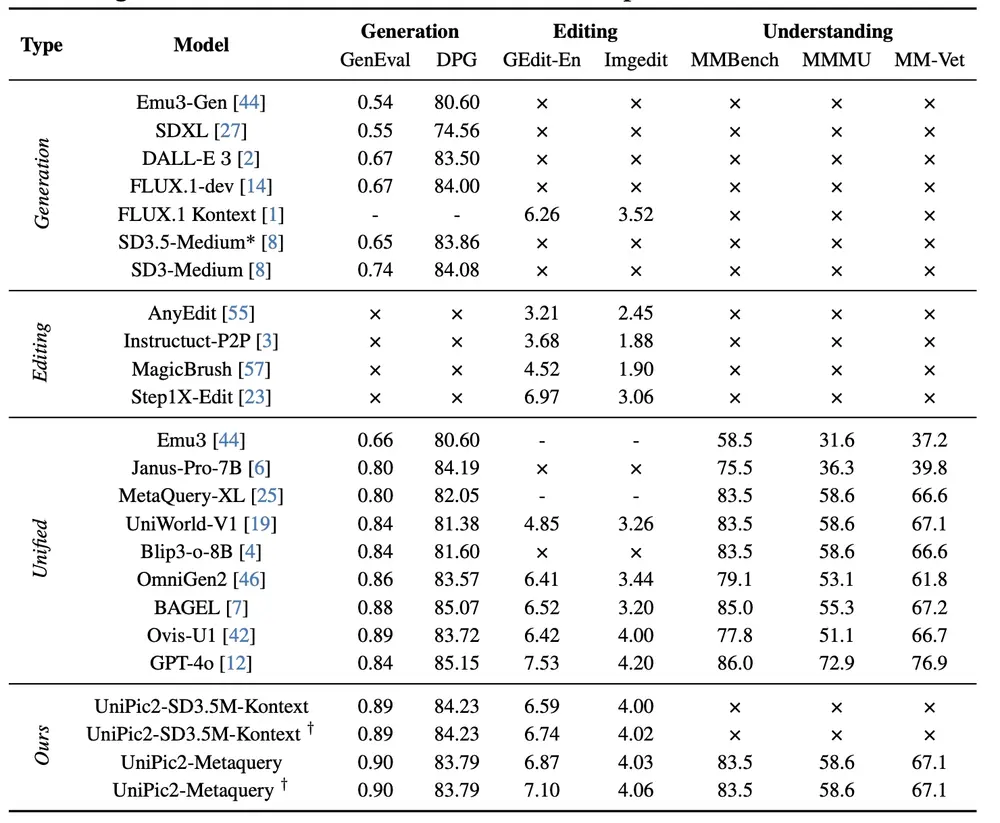

性能表现:多项基准领先

UniPic-2.0 在多个权威图像生成与编辑基准上进行了系统评估,结果如下:

✅ 文本到图像生成(Text-to-Image Generation)

| 模型 | GenEval Score | DPG-Bench Score |

|---|---|---|

| BAGEL (7B) | 78.2 | 69.5 |

| Flux-Kontext (12B) | 80.1 | 71.3 |

| UniPic2-SD3.5M-Kontext (-GRPO) | 82.6 | 73.8 |

尽管参数量仅为对手的 1/6~1/3,UniPic-2.0 在两项指标上均取得最优成绩。

✅ 图像编辑(Image Editing)

在 GEdit 和 ImgEdit 基准测试中,模型需根据自然语言指令修改图像内容(如“将狗换成猫”、“添加雨伞”)。

| 模型 | GEdit Score | ImgEdit Score |

|---|---|---|

| BAGEL | 74.3 | 70.1 |

| Flux-Kontext | 75.8 | 72.4 |

| UniPic2-SD3.5M-Kontext (-GRPO) | 78.9 | 76.2 |

显示出更强的编辑准确性和上下文保持能力。

✅ 多模态理解与推理

通过连接 Qwen2.5-VL-7B,UniPic2-MetaQuery 可执行图像描述生成、视觉问答、跨模态推理等任务,在 MMMU、POPE 等子任务中表现稳健,验证了其统一建模的有效性。

相关文章