当AI画出一张“森林中休息的鹿”,我们如何判断它画得好不好?

是看它是否包含“鹿”和“树木”?还是看光影是否自然、构图是否美观、整体是否令人愉悦?显然,后者更贴近人类的真实审美。然而,当前大多数文本到图像生成模型的评估方式,仍停留在“是否匹配描述”的浅层语义对齐上,难以捕捉真实的人类偏好。

为解决这一问题,来自Mizzen AI、香港中文大学、伦敦国王学院、上海交通大学、上海人工智能实验室、InnoHK等机构的研究团队推出了 HPSv3(Human Preference Score v3) ——一个更全面、更贴近人类感知的图像质量评估体系。它不仅提供了一个覆盖广泛质量范围的新型基准,还提出了一种无需额外训练即可提升生成质量的推理方法。

- 项目主页:https://mizzenai.github.io/HPSv3.project

- GitHub:https://github.com/MizzenAI/HPSv3

- 模型:https://huggingface.co/MizzenAI/HPSv3

这项工作标志着图像生成评估正从“机器可测”迈向“人类可感”。

现有评估方法的三大瓶颈

目前主流的文本到图像评估指标(如CLIP Score、ImageReward等)存在明显局限:

- 数据覆盖窄:多数依赖小规模、高质数据,无法反映从低质到高质的完整谱系;

- 特征提取弱:仅依赖CLIP等通用模型提取特征,缺乏对美学、真实感等细粒度维度的建模能力;

- 损失函数粗放:使用标准排序损失,忽视人类标注中的不确定性与主观差异。

这些问题导致模型评分与真实人类偏好之间存在显著偏差。

为此,团队提出 HPSv3,通过构建大规模偏好数据集、改进训练机制和引入新推理范式,系统性地提升评估的广度与精度。

HPDv3:首个宽谱人类偏好数据集

HPSv3 的核心基础是 HPDv3(Human Preference Dataset v3) ——目前规模最大、覆盖最广的文本-图像人类偏好数据集。

数据构成

- 108万组文本-图像对

- 117万组人类标注的图像对比较(即“A vs B,哪个更好?”)

数据来源多样

- 来自 Stable Diffusion、Midjourney、DALL·E 3 等先进生成模型的输出

- 包含大量 真实世界高质量图像

- 特别纳入 Midjourney 用户实际选择结果,增强现实偏好代表性

标注质量保障

每组比较由 9–19名专业标注者 独立评估,确保结果具备高置信度和统计稳健性。

💡 关键创新:HPDv3 首次实现了“宽谱”覆盖——既包含低质量生成图,也涵盖接近摄影级的真实图像,使评估更具普适性和实用性。

HPSv3:基于VLM的偏好模型

在 HPDv3 基础上,团队训练了新一代偏好打分模型 HPSv3,其核心技术路径如下:

1. 特征提取:采用强大视觉语言模型(VLM)

使用如 QWen2-VL 等先进VLM提取图像与文本的联合嵌入表示,相比传统CLIP模型,能更好捕捉细节、风格与语义一致性。

2. 训练目标:不确定性感知的排序损失(Uncertainty-Aware Ranking Loss)

传统排序损失假设标注绝对正确,但人类偏好本身具有主观性。HPSv3 引入不确定性建模,允许模型识别“模糊判断”样本,并降低其权重,从而提升训练鲁棒性。

✅ 效果:显著减少因标注噪声导致的过拟合,提升泛化能力。

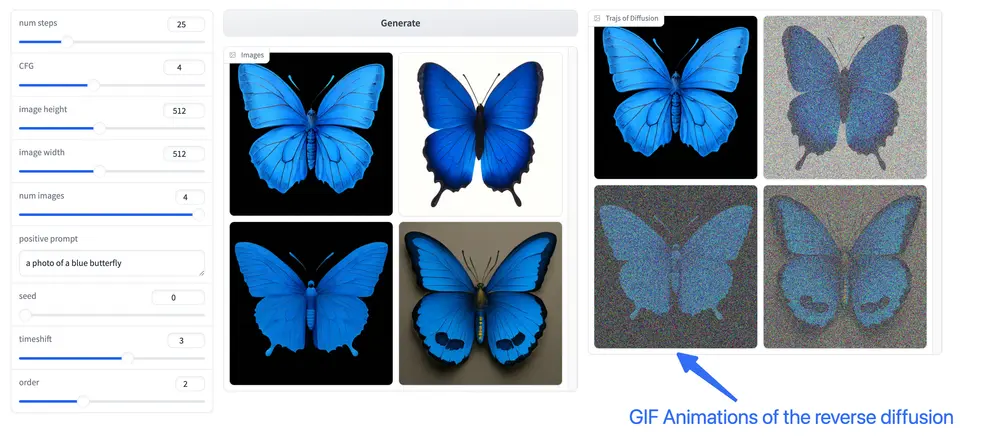

CoHP:无需训练的图像质量迭代优化

除了评估,HPSv3 还催生了一种全新的推理策略——Chain-of-Human-Preference (CoHP),即“人类偏好链”。

这是一种迭代式图像精炼方法,在不修改模型参数、不引入新训练数据的前提下,逐步提升生成质量。

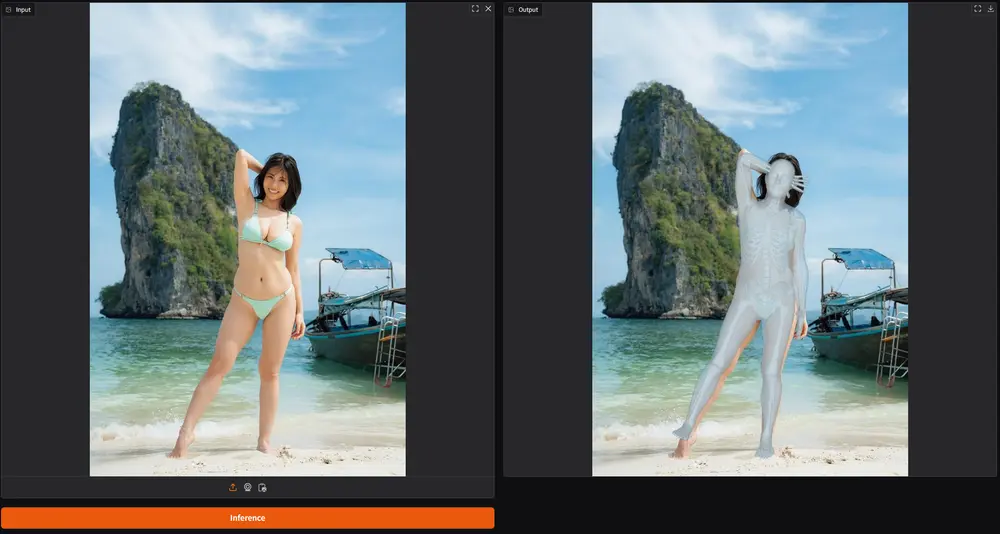

CoHP 工作流程

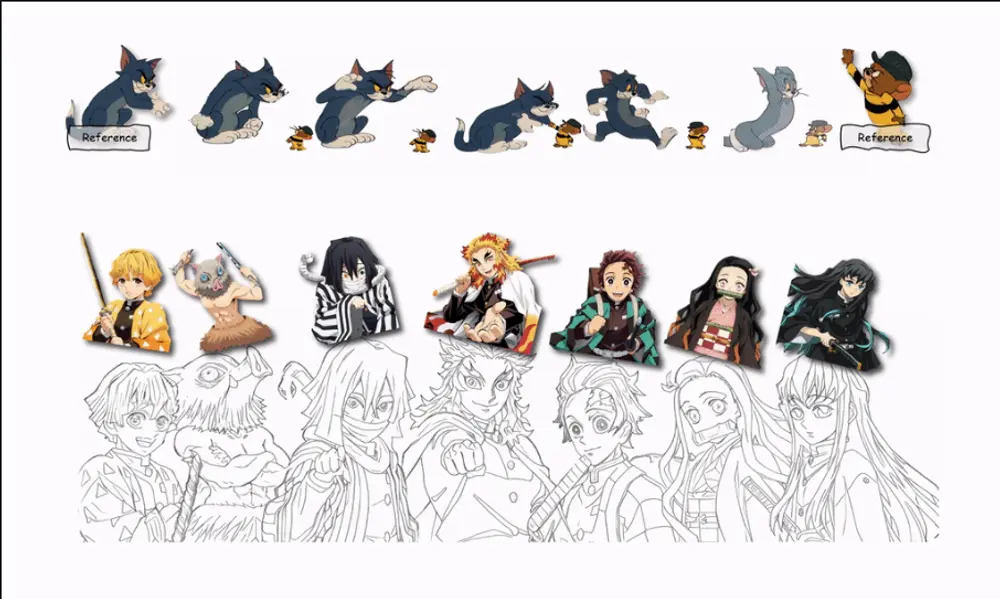

- 多模型生成:多个文本到图像模型对同一提示生成候选图像;

- HPSv3评分筛选:用 HPSv3 打分,选出当前最优图像;

- 反馈优化:将高分图像作为参考,微调提示或采样策略,再次生成;

- 循环迭代:重复上述过程,逐步逼近人类偏好的高质量输出。

示例

提示:“一只在森林中休息的鹿,周围环绕着茂密的植被。”

- 第一轮生成可能包含构图杂乱、光影失真的图像;

- HPSv3 识别出其中最接近自然美感的一张;

- 利用该图像反馈调整提示(如“柔和晨光”、“远景虚化”),进入下一轮生成;

- 经过2–3轮迭代,最终输出更符合人类审美的作品。

🔁 CoHP 实现了“评估即优化”,将评价器转化为优化引擎。

实测表现:全面超越现有方法

1. 自动评估一致性(vs 人类标注)

| 指标 | Spearman 相关系数 | Kendall 相关系数 |

|---|---|---|

| HPSv3 | 0.94 | 0.82 |

| 其他主流方法 | 最高 0.85 | 最高 0.71 |

HPSv3 与人类判断的一致性达到新高,尤其在复杂场景下优势明显。

2. 跨数据集泛化能力

| 测试集 | HPSv3 准确率 | 次优方法 |

|---|---|---|

| ImageReward | 66.8% | 58.3% |

| PickScore | 72.8% | 65.1% |

| HPDv2 | 85.4% | 79.6% |

均显著领先。

3. 真实人类评估结果

在100组双盲测试中(每组展示两张图像,由人类选择更优者):

- 当 HPSv3 推荐图像 vs 其他模型推荐图像时,胜率达87%

这表明 HPSv3 不仅“算得准”,而且“看得懂”。

应用场景:不止于评估

HPSv3 与 CoHP 的组合,为多个实际场景提供了新工具:

| 应用场景 | 解决方案 |

|---|---|

| 模型对比与选择 | 在多个生成模型中自动选出最适合当前任务的模型 |

| 生成质量优化 | 通过 CoHP 迭代提升单次生成质量,无需重新训练 |

| 人机协作系统 | 作为用户反馈代理,帮助非专业用户筛选和优化图像 |

| AIGC产品评测 | 提供标准化、可量化的用户体验评估基准 |

相关文章