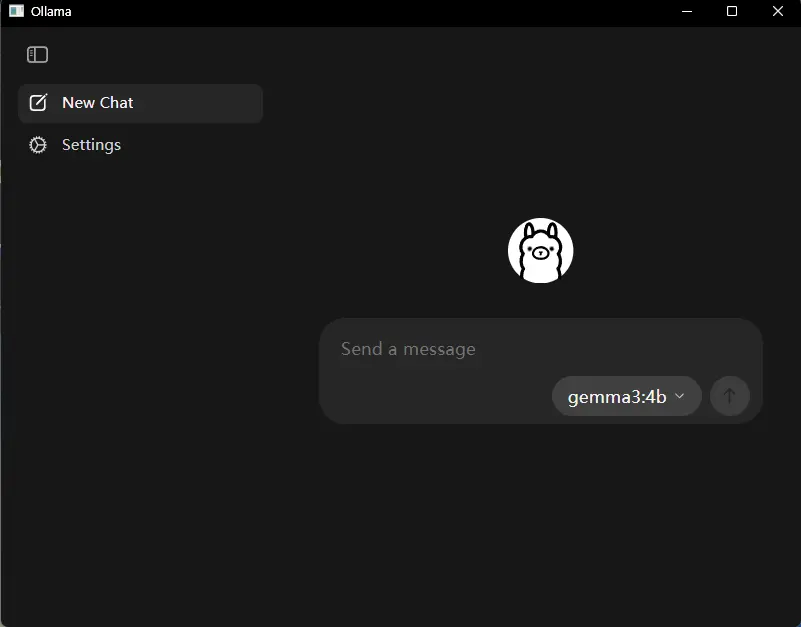

Ollama 正式发布 v0.10.0 版本,带来多项关键更新,显著提升了本地大模型的使用体验。最引人注目的是,此次更新首次引入了图形用户界面(GUI),不再局限于命令行操作,让非技术用户也能轻松上手。

这一变化标志着 Ollama 正在从开发者工具向更广泛的用户群体迈进。

一、图形界面上线,操作更直观

过去使用 Ollama,用户需要通过终端输入命令来下载和运行模型。v0.10.0 版本为 macOS 和 Windows 推出了原生桌面应用,内置图形界面,用户可以直接在界面上:

- 浏览可用模型

- 点击下载目标模型

- 实时查看运行状态

- 与模型进行对话交互

无需记忆命令,也不用切换终端窗口,整个流程更加流畅自然。

二、支持文件拖放,提升文档处理效率

新版本支持将本地文件直接拖入应用窗口,目前可处理文本文件和 PDF 文档。

例如:

- 拖入一份项目需求文档,快速提取重点内容;

- 上传会议纪要,让模型帮你总结关键决策;

- 分析技术文档或研究报告,获取结构化信息。

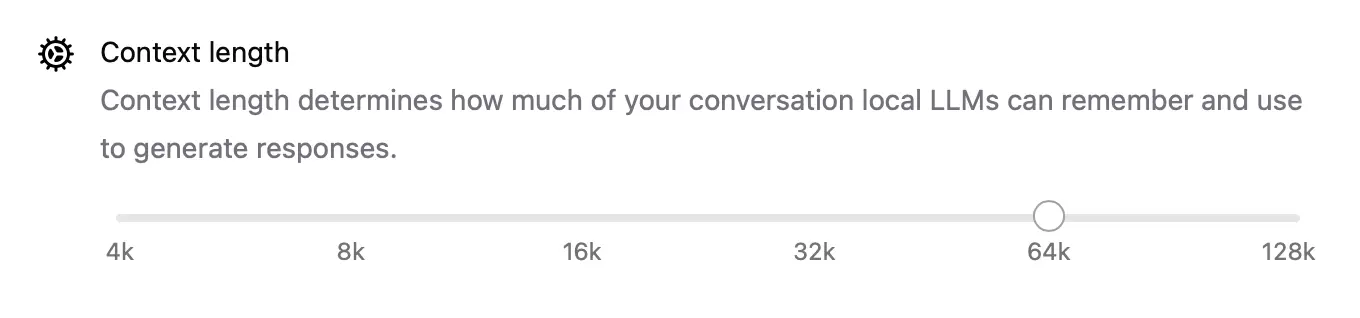

⚠️ 提示:若需处理较长文档,可在设置中调高上下文长度(context length)。但请注意,这会增加内存占用,建议在内存充足的设备上使用。

三、多模态能力上线,支持图像识别

v0.10.0 引入了全新的多模态引擎,使得 Ollama 能够处理图像输入。只要使用支持视觉理解的模型(如 Google DeepMind 的 Gemma 3 多模态版本),即可实现:

- 图像内容描述

- 图表信息提取

- 手写笔记识别

- 截图问答等场景

例如,拖入一张产品设计草图,询问“这个界面有哪些交互元素?”,模型即可给出分析结果。

四、代码文件也能被理解

除了文本和图像,Ollama 现在还能读取代码文件。开发者可以将 .py、.js 或其他源码文件拖入应用,让模型帮助:

- 解释代码逻辑

- 查找潜在问题

- 生成注释或文档

- 实现简单重构建议

这对代码审查、知识传承和技术学习都具有实际价值。

五、跨平台支持,开箱即用

目前,Ollama 桌面应用已正式支持:

- macOS(Apple Silicon 及 Intel 芯片)

- Windows(x86_64 架构)

安装包轻量,启动迅速,本地运行保障数据隐私,所有计算均在设备端完成,无需联网上传内容。

写在最后

Ollama v0.10.0 的更新,是一次从“工具”到“平台”的重要演进。图形界面降低了使用门槛,文件交互和多模态支持拓展了应用场景,使得本地大模型真正开始融入日常工作效率流程。

对于希望在本地安全、高效地使用大模型的用户来说,这次更新值得立即体验。

相关:

相关文章