如果你正在使用 英伟达 RTX 50 系列(Blackwell 架构) 显卡,并希望在 Windows 上运行 ComfyUI、Fooocus 或 FramePack,那么本指南将帮助你显著提升生成效率。

网友Rogala整理了针对这些应用的预编译加速包(如 xformers、Flash Attention、SageAttention)以及详细安装说明,帮助你在 Windows 环境下轻松部署高性能 AI 工作流。

包含内容

本指南提供以下优化工具:

- xformers:高效的注意力机制库,广泛用于图像生成模型。

- Flash Attention:专为快速注意力计算设计,显著提升推理速度。

- SageAttention:另一款高性能注意力优化工具。

- 详细安装指南:帮助你快速将这些加速工具集成到 ComfyUI、Fooocus 或 FramePack 中。

- 直接下载链接:一键获取编译好的轮子文件(wheel)。

🖥️ 系统要求与兼容性

| 项目 | 要求 |

|---|---|

| 显卡 | 英伟达 RTX 50 系列(Blackwell 架构,SM120) |

| 操作系统 | Windows |

| Python | 推荐使用 Python 3.12.x(编译使用 3.12.10) |

| 编译工具 | CUDA Toolkit 12.8,Visual Studio 2022 |

⚠️ 所有加速包均专为 RTX 50系列优化,不保证与其他 英伟达 显卡兼容。

为什么使用本指南?

如果你正在使用 RTX 50系列显卡并运行 ComfyUI/Fooocus/FramePack,你会发现默认安装的 Torch 和注意力库可能无法充分发挥性能。本指南提供:

- 专为 CUDA 12.8 编译的 Torch 2.7.x

- 针对 RTX 50 优化的 xformers、FlashAttention、SageAttention

- 完整的部署流程说明,包括便携版、全局 Python 和虚拟环境三种方式

部署方法与 Python 版本挑战

AI 工具通常提供三种部署方式:

方法 1:便携版(下载即用)

- 优点:开箱即用,适合快速上手

- 缺点:内置的

python_embedded环境无法更改 Python 版本,可能导致兼容性问题

常见问题:

- Fooocus:使用 Python 3.10.9 + Torch 2.1.0(不兼容 RTX 50)

- FramePack:使用 Python 3.10.6 + Torch 2.6.0(不兼容 RTX 50)

- ComfyUI v0.3.44+:已使用 Python 3.12.10 + Torch 2.7.1(兼容)

方法 2:全局 Python 安装

- 优点:设置简单,适用于单一项目

- 缺点:多个项目间容易发生依赖冲突

方法 3:虚拟环境(推荐)

- 优点:每个项目独立环境,避免包冲突

- 推荐用于同时运行多个 AI 工具的用户

🛠️ 更新 Torch 以支持 RTX 50 系列

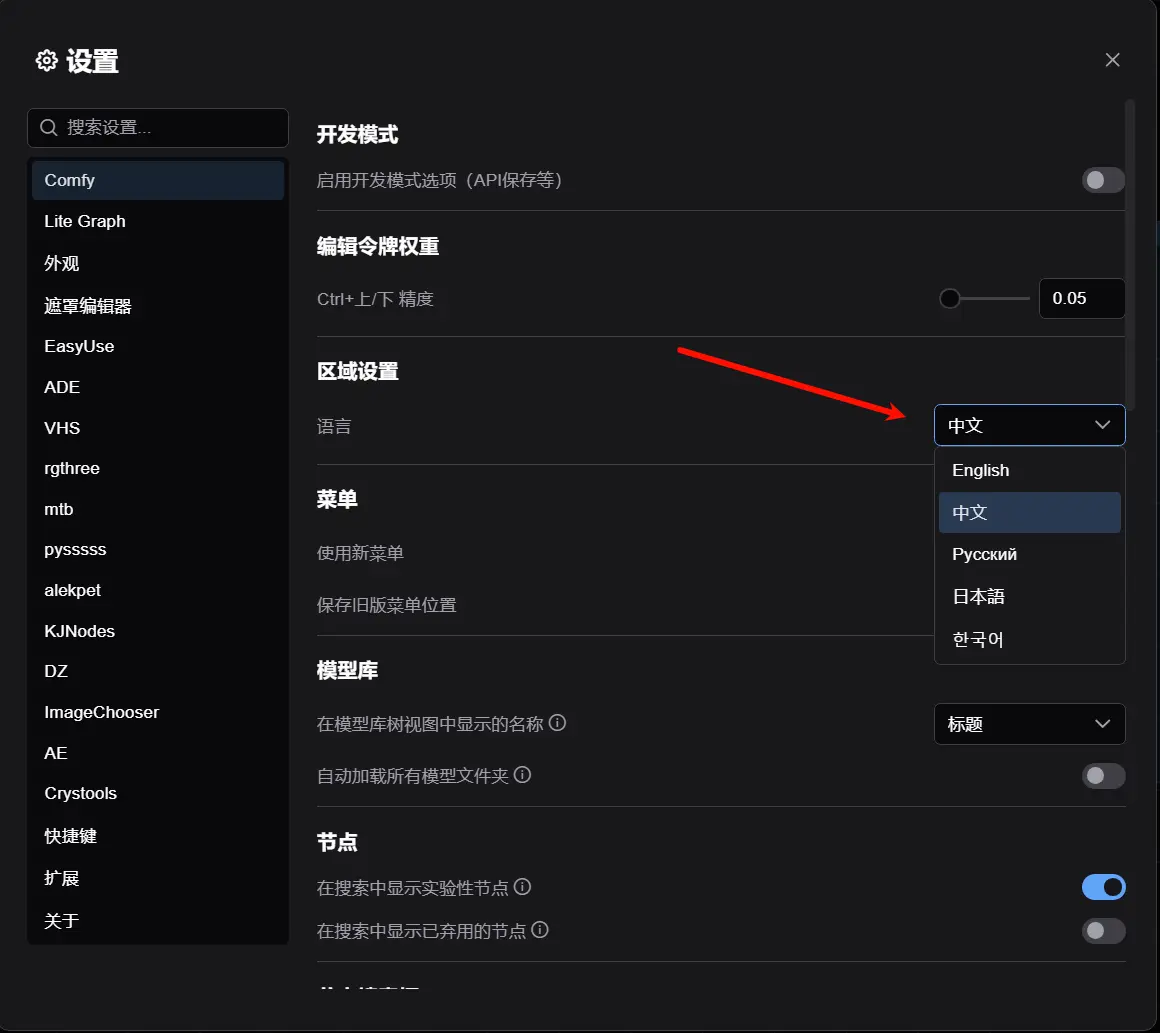

步骤 1:进入嵌入式 Python 环境

打开对应应用的 python_embedded 文件夹,在地址栏输入 cmd 回车,打开命令行。

# 升级 pip

.\python.exe -m pip install --upgrade pip

# 安装 CUDA 12.8 版本的 Torch

.\python.exe -m pip install torch torchvision torchaudio --extra-index-url https://download.pytorch.org/whl/cu128🧪 安装加速包指南

安装 xformers

# 便携版:

.\python.exe -m pip install xformers --index-url https://download.pytorch.org/whl/cu128

# 虚拟环境版:

pip install xformers --index-url https://download.pytorch.org/whl/cu128✅ Torch 2.7.0 用户请指定版本:

pip install xformers==0.0.30 --index-url https://download.pytorch.org/whl/cu128安装 FlashAttention(仅 FramePack 和 ComfyUI)

pip install https://huggingface.co/lldacing/flash-attention-windows-wheel/resolve/main/flash_attn-2.7.4.post1%2Bcu128torch2.7.0cxx11abiFALSE-cp312-cp312-win_amd64.whl安装 SageAttention(需先安装 Triton)

pip install triton-windows

pip install https://github.com/woct0rdho/SageAttention/releases/download/v2.2.0-windows/sageattention-2.2.0+cu128torch2.7.1-cp312-cp312-win_amd64.whl启动脚本示例

你可以创建 run.bat 文件启动应用,以下为模板:

Fooocus

@echo off

call .\venv\Scripts\activate.bat

python .\Fooocus\entry_with_update.py --theme dark

pauseFramePack

@echo off

call .\venv\Scripts\activate.bat

python .\FramePack\demo_gradio_f1.py --server 127.0.0.1 --inbrowser

pauseComfyUI

@echo off

call .\venv\Scripts\activate.bat

python .\ComfyUI\main.py --auto-launch

pause⚙️ 启动参数说明

| 应用 | 参数 | 说明 |

|---|---|---|

| Fooocus | --disable-xformers | 禁用 xformers |

| FramePack | 默认启用 | 自动使用 xformers、FlashAttention、SageAttention |

| ComfyUI | --disable-xformers | 禁用 xformers |

| ComfyUI | --use-flash-attention | 启用 FlashAttention(需禁用 xformers) |

| ComfyUI | --use-sage-attention | 启用 SageAttention(可与 xformers 共存) |

基准测试工具

在 bench 文件夹中提供了以下测试脚本,帮助你验证安装效果:

environment.py:查看系统信息和已安装包fp32-16-8-4_bf16_gpt-bench.py:Torch、xformers、FlashAttention 的性能基准测试sa-fa_gpt.py:比较 SageAttention 与 FlashAttention 的表现

小结

本指南为使用 英伟达 RTX 50 系列显卡的用户提供了完整的性能优化方案,包括:

- CUDA 12.8 优化的 Torch 版本

- 高性能注意力机制库(xformers、FlashAttention、SageAttention)

- 三种部署方式(便携版、全局 Python、虚拟环境)

- 启动脚本模板与参数说明

- 基准测试工具

通过本指南,你可以充分发挥 RTX 50 的性能,显著提升 AI 生成效率。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...