你是否希望在 ComfyUI 中轻松调用轻量级但强大的语言模型,来辅助你的 AI 创作?比如写故事、生成提示词、设计对话内容?

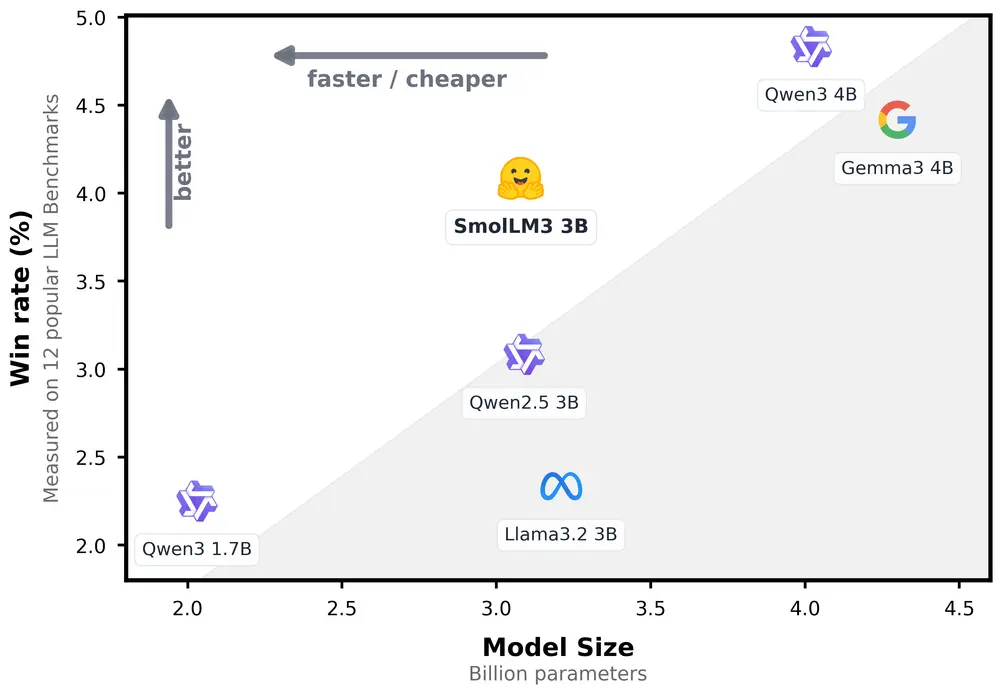

今天介绍的这款插件 —— ComfyUI-SmolLM3 正是为此而生。它将 Hugging Face 推出的 SmolLM3 系列语言模型 引入 ComfyUI,支持从基础文本补全到完整对话式交互,适合各种创意任务。

功能亮点

- ✅ 简单直观:加载即用,无需复杂配置

- ✅ 双模型支持:可选通用文本模型或指令优化模型

- ✅ 灵活生成:适用于聊天、补全、创意写作等场景

- ✅ 多种精度支持:fp16、fp32、bf16,兼顾性能与兼容性

- ✅ 可重复输出:支持设置种子(seed),确保结果一致性

- ✅ ComfyUI 原生集成:无缝融入现有工作流

插件包含的三大节点

| 节点名称 | 功能描述 |

|---|---|

| SmolLM3 模型加载器 | 加载 SmolLM3 模型,作为后续生成的起点 |

| SmolLM3 采样器(聊天) | 支持完整对话模板,适用于多轮交互 |

| SmolLM3 简单生成 | 快速进行文本补全,适合一次性生成任务 |

安装步骤

手动安装

1、进入 ComfyUI 的 custom_nodes 文件夹:

cd ComfyUI/custom_nodes2、克隆项目仓库:

git clone https://github.com/XmYx/ComfyUI-SmolLM3.git3、安装依赖:

cd ComfyUI-SmolLM3

pip install -r requirements.txt重启 ComfyUI,即可在节点库中看到新添加的功能!

使用方法

基本流程如下:

- 添加 SmolLM3 模型加载器节点

- 在下拉菜单中选择模型:

HuggingFaceTB/SmolLM3-3B-Base:适用于通用文本生成HuggingFaceTB/SmolLM3-3B:适用于聊天和指令遵循

- 将输出连接至以下任一节点:

- SmolLM3 采样器(聊天):用于对话式交互

- SmolLM3 简单生成:用于快速文本补全

- 输入你的提示(prompt)

- 设置参数(如温度、种子等)

- 点击“生成”开始创作!

参数建议

| 参数名 | 推荐值 | 说明 |

|---|---|---|

temperature | 0.6 | 控制输出多样性,数值越高越随机 |

top_p | 0.95 | 核采样策略,控制生成质量与多样性平衡 |

seed | 自定义整数 | 可重复生成相同输出 |

chat_template | 开启 | 启用后支持对话格式输入(如用户/助手交替) |

device | CPU/GPU | 若 GPU 内存有限,可切换为 CPU 模式运行 |

示例提示语

以下是一些你可以尝试的提示语:

- “用简单语言简要解释重力。”

- “写一首关于人工智能的俳句。”

- “列出回形针的三种创意用途。”

- “继续这个故事:从前在一个数字王国里……”

只需输入这些提示,SmolLM3 就会为你生成高质量的回答或续写内容。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...