香港中文大学和字节跳动的研究人员推出多模态框架Tar,通过统一的离散语义表示将视觉理解和生成任务整合到一个共享空间中。该框架的核心是 Text-Aligned Tokenizer (TA-Tok),它利用从大语言模型(LLM)词汇表中投影出的文本对齐码本,将图像转换为离散的标记。通过将视觉和文本整合到一个统一的空间中,Tar 支持跨模态输入和输出,无需针对特定模态进行设计。

- 项目主页:https://tar.csuhan.com

- GitHub:https://github.com/csuhan/Tar

- 模型:https://huggingface.co/collections/csuhan/tar-68538273b5537d0bee712648

- Demo:https://huggingface.co/spaces/csuhan/Tar

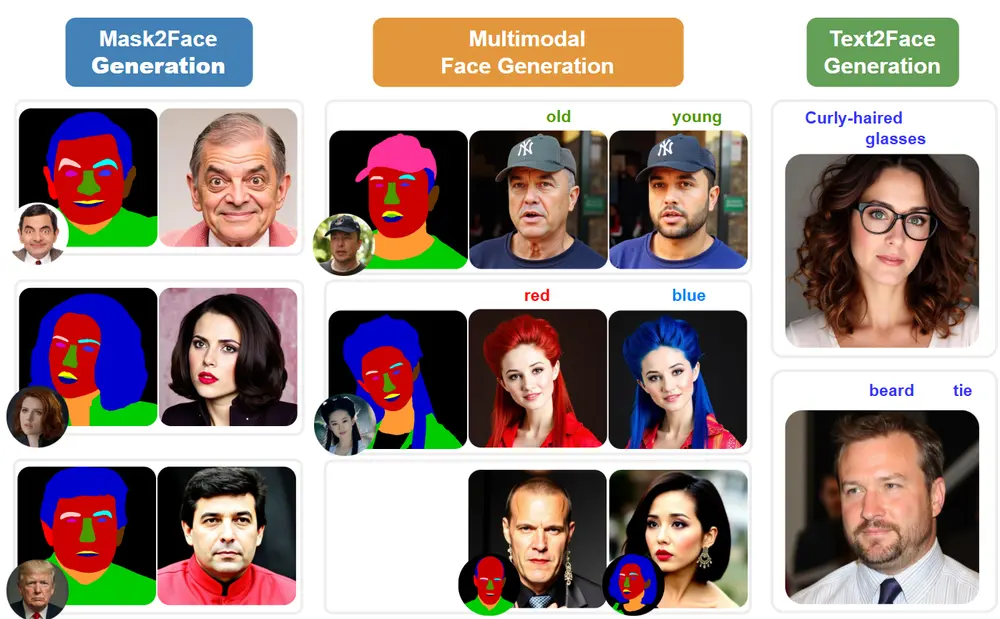

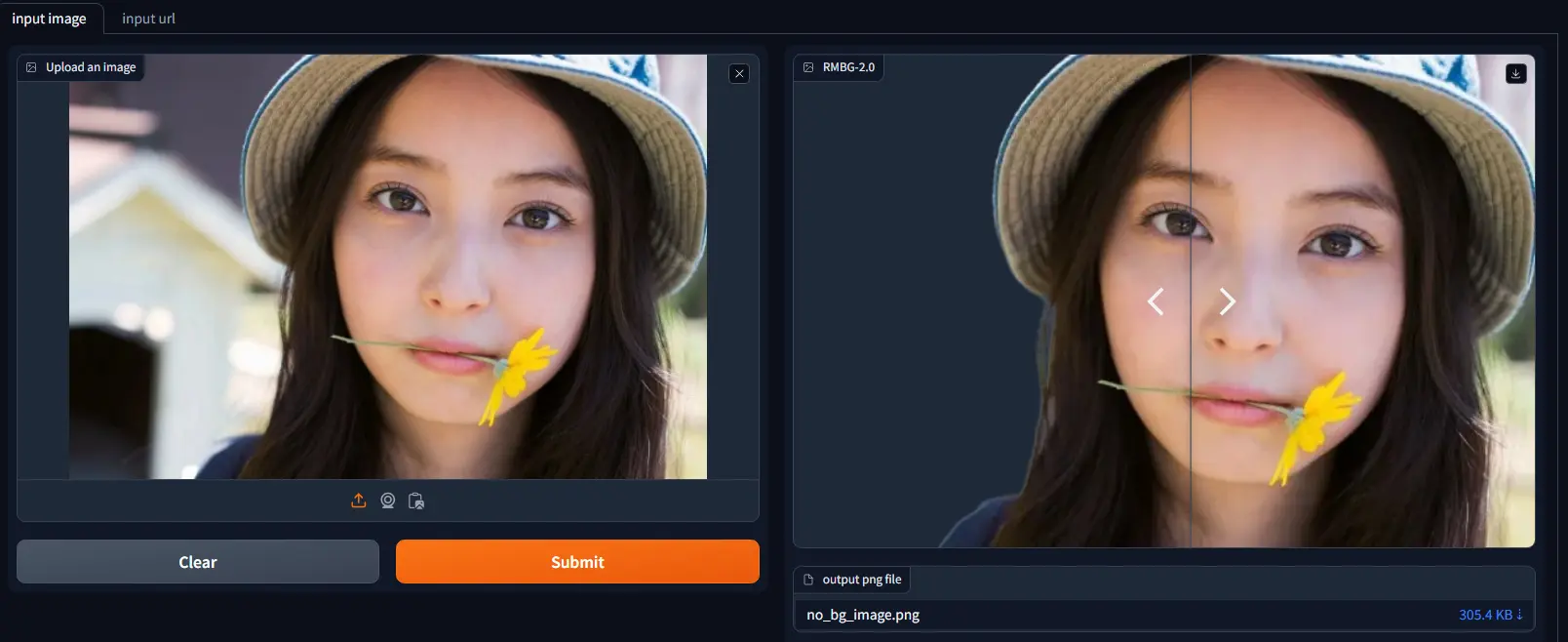

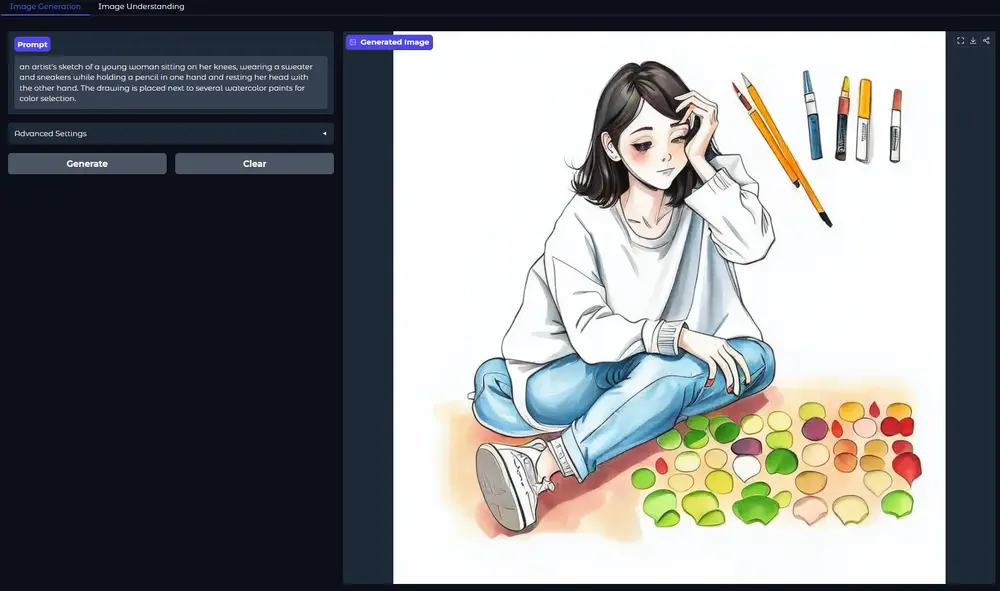

例如,在视觉理解任务中,模型可以将图像编码为离散的语义标记,然后通过 LLM 进行处理,生成描述图像的文本。在视觉生成任务中,模型可以根据文本提示生成图像。这种统一的表示方法使得模型能够同时处理理解和生成任务,而无需在不同模态之间进行复杂的转换。

主要功能

- 统一视觉理解和生成:Tar 能够处理视觉理解和生成任务,无需为每个任务设计特定的模型。

- 跨模态输入和输出:支持图像和文本的无缝输入和输出,通过共享接口实现。

- 高效的多模态推理:通过离散的语义表示,Tar 能够快速处理复杂的多模态任务,提高推理效率。

主要特点

- 文本对齐的离散表示:TA-Tok 使用从 LLM 词汇表中投影的码本,将图像转换为离散的语义标记,确保视觉和文本标记在 LLM 的潜在空间中对齐。

- 可扩展的编码和解码:通过 Scale-Adaptive Pooling and Decoding,模型可以根据任务需求调整标记的粒度,平衡效率和细节。

- 生成解码器:使用两种互补的解码器——自回归模型和基于扩散的模型,以生成高质量的视觉输出。

工作原理

- 文本对齐的标记化:TA-Tok 将图像编码为离散的语义标记,这些标记与 LLM 的词汇表对齐,使得图像和文本能够在同一个潜在空间中处理。

- 多粒度特征提取:通过 Scale-Adaptive Pooling 和 Decoding,模型可以提取不同粒度的特征,以适应不同的任务需求。

- 生成解码器:使用自回归模型和基于扩散的模型将离散的语义标记解码为高质量的图像。自回归模型适用于离散标记,而扩散模型则利用预训练的图像生成器生成高质量的输出。

测试结果

- 视觉理解:在多个基准测试中,Tar 的性能与专门的视觉理解模型相当,甚至在某些任务上超越了现有的多模态 LLM 方法。

- 视觉生成:在 GenEval 和 DPG Bench 等基准测试中,Tar 的表现优于或接近现有的多模态生成模型,展示了其在图像生成任务上的强大能力。

- 效率和收敛速度:Tar 在训练效率和收敛速度上表现出色,能够在较少的训练数据和较短的训练时间内达到较高的性能。

应用场景

- 视觉理解:用于图像分类、目标检测、视觉问答等任务,帮助模型更好地理解图像内容。

- 视觉生成:用于根据文本提示生成图像,适用于创意设计、内容创作等领域。

- 多模态交互:在需要同时处理视觉和文本信息的场景中,如智能助手、教育工具等,Tar 能够提供高效的多模态交互体验。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...