近年来,随着扩散模型等深度生成技术的发展,视频生成能力取得了显著进步。然而,在涉及多个参考主体的场景中,如何保证各主体之间的视觉一致性、身份一致性和生成稳定性,依然是一个重大挑战。

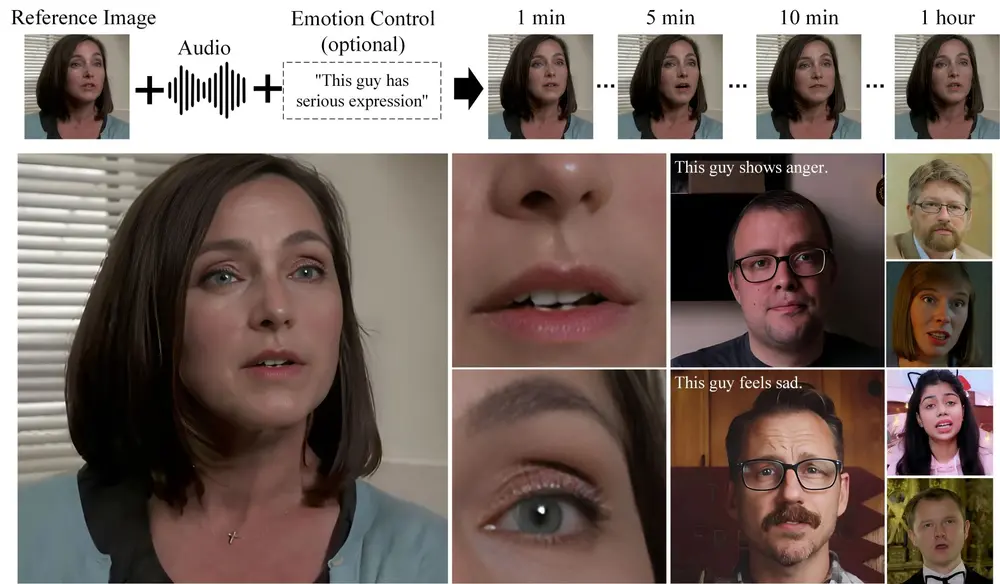

为了解决这一问题,字节跳动团队提出了一种统一的任意参考视频生成框架——MAGREF。该框架能够基于多种参考图像(如人物面部、物体、背景)以及文本提示,生成连贯、高质量且多主体一致的视频内容。

什么是 MAGREF?

MAGREF 是一个多模态视频生成框架,其核心目标是:

- 从多个参考图像中提取关键特征

- 结合文本提示生成符合描述的动态视频

- 在多主体场景下保持身份和外观的一致性

例如,用户可以提供一张人物的面部照片和一张公园背景图,并输入提示词“一个人在公园里散步”,MAGREF 就能生成一段自然行走的视频,人物的面部特征和姿态都会与参考图像高度一致。

核心技术亮点

✅ 区域感知动态掩码机制

MAGREF 引入了一种灵活的区域感知机制,将所有参考图像放置在一个空白画布上,并生成对应的二值掩码来标记每个主体的位置。这种方式使得单一模型可以处理包括人物、物体和背景在内的多种主体组合,无需更改网络结构。

此外,掩码在训练过程中随机打乱,增强了模型对不同组合方式的适应能力。

✅ 像素级通道拼接机制

传统的视频生成方法通常直接将参考图像与视频帧拼接,容易导致身份信息丢失。MAGREF 则采用像素级通道拼接策略,在通道维度上融合参考图像的特征表示与视频帧特征,从而在不改变原始模型结构的前提下,保留更多细节信息,提升生成质量。

✅ 零样本泛化能力

令人惊喜的是,MAGREF 虽然仅在单主体数据上训练,却具备强大的零样本泛化能力,能够自然地扩展到双人互动、群体场景甚至包含物体和环境的复杂组合中。

工作原理简述

- 数据准备阶段

- 对原始视频进行场景分割、对象提取和人脸检测,构建高质量的训练样本集。

- 每个样本包含参考图像(如人物、物体)和对应文本描述。

- 区域感知动态掩码生成

- 所有参考图像被统一放置在空白画布上。

- 系统生成掩码标记各主体位置,增强模型对组合多样性的适应能力。

- 像素级通道拼接

- 将参考图像特征与视频帧特征在通道维度拼接,注入生成流程。

- 有效保留外观细节,提升视频的真实感和一致性。

- 视频生成阶段

- 使用预训练视频生成模型(如 Wan2.1),结合上述机制生成最终视频。

应用场景展示

🧑🦰 单主体视频生成

给定一张面部参考图像,MAGREF 可以生成在不同场景和动作中保持身份一致的视频。例如:“一个女孩在海边跳舞”或“一名男子在办公室演讲”。

👥 多主体视频生成

支持两个或多个独立身份的参考图像,合成具有真实互动效果的视频。例如:两人对话、多人聚会等场景,保持每个人物的身份和表情一致性。

🐶 主体-物体-环境联合生成

通过融合人类身份、物体(如宠物、汽车)和背景环境,实现更丰富的视频合成。例如:“一只狗跟着主人跑步”、“一位厨师正在切菜”。

性能表现与评估

为了验证 MAGREF 的有效性,研究团队构建了一个全面的多主体视频基准数据集,并进行了大量实验:

🔢 定量评估结果

| 指标 | 表现 |

|---|---|

| 身份一致性(FaceSim) | 最高分,优于现有开源和商业模型 |

| 视觉质量(Aesthetics) | 显著提升 |

| 文本相关性(GmeScore) | 表现优异 |

| 运动强度(Motion Score) | 合理且自然 |

🎞 定性评估结果

对比其他方法,MAGREF 在以下方面展现出明显优势:

- 更高的身份保真度

- 更自然的动作过渡

- 更稳定的生成过程

🧪 消融实验验证

通过对区域感知掩码机制和通道拼接机制的逐一测试,验证了这些设计对整体性能的关键贡献。结果显示,这两项创新在身份一致性和视觉稳定性方面带来了显著提升。

相关文章