南洋理工大学和字节跳动的研究人员推出一种新型单步视频修复(VR)技术SeedVR2,通过扩散模型(Diffusion Model)和对抗性后训练(Adversarial Post-Training, APT)实现高效、高质量的视频修复和超分辨率。该方法通过一系列创新设计,显著提高了视频修复的速度和质量,同时保持了模型的灵活性和泛化能力。

- 项目主页:https://iceclear.github.io/projects/seedvr2

- GitHub:https://github.com/IceClear/SeedVR2

- Demo:https://huggingface.co/spaces/ByteDance-Seed/SeedVR2-3B

主要功能

SeedVR2的主要功能包括:

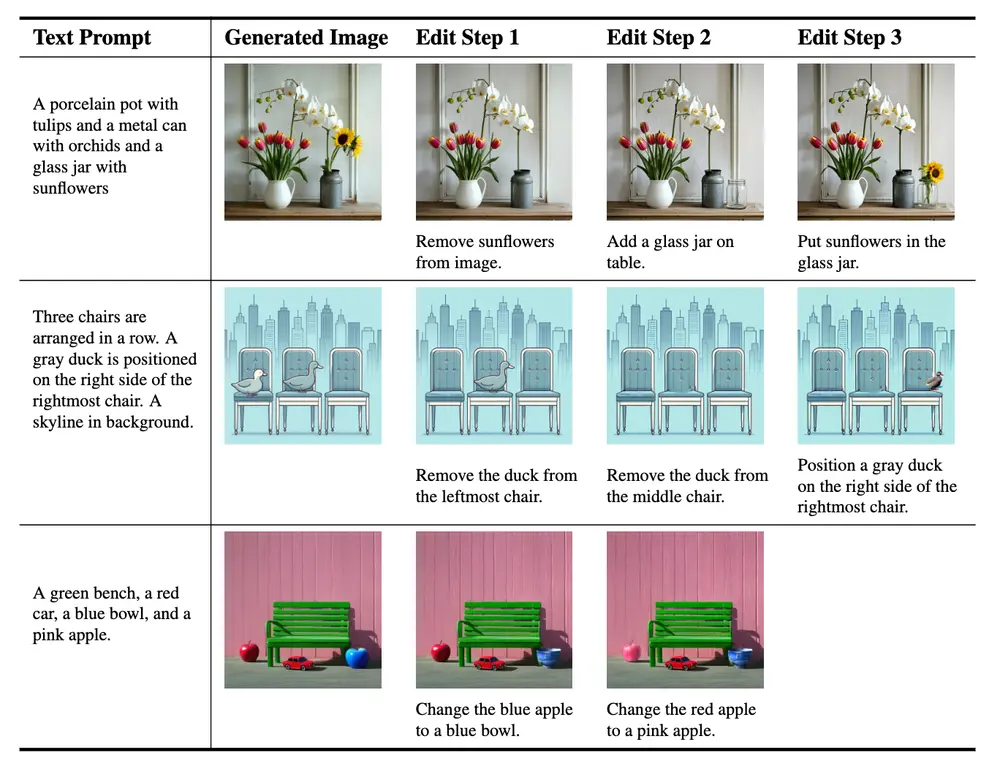

- 单步视频修复:将低质量的视频输入(如模糊、低分辨率视频)修复为高质量的视频,同时保持细节和纹理的完整性。

- 超分辨率:将低分辨率视频提升到高分辨率,如从720p提升到1080p或更高,同时增强视觉效果。

- 对抗性训练:通过对抗性训练提高模型的生成能力和鲁棒性,使其能够处理复杂的现实世界场景。

主要特点

SeedVR2的主要特点包括:

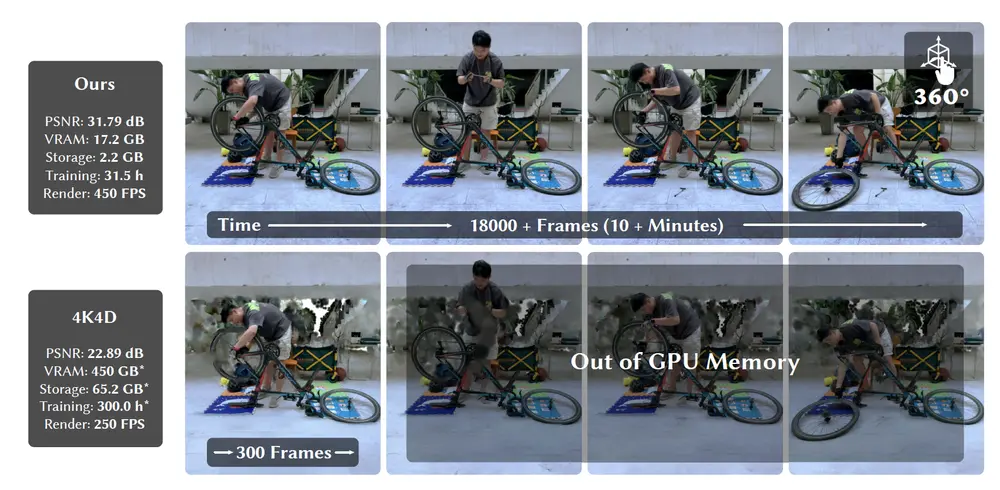

- 单步生成:与传统的多步扩散模型相比,SeedVR2能够在单步中完成视频修复,显著提高了效率。

- 自适应窗口注意力机制:通过动态调整窗口大小以适应不同分辨率的输入,避免了高分辨率视频修复中的边界伪影问题。

- 对抗性后训练:采用对抗性训练框架,通过真实数据的反馈进一步优化模型,提高了生成视频的质量。

- 特征匹配损失:提出了一种新的特征匹配损失函数,用于替代传统的LPIPS损失,提高了训练效率和模型的稳定性。

- 大规模模型训练:训练了迄今为止最大的视频修复生成对抗网络(GAN),参数量达到160亿,显著提高了模型的生成能力。

工作原理

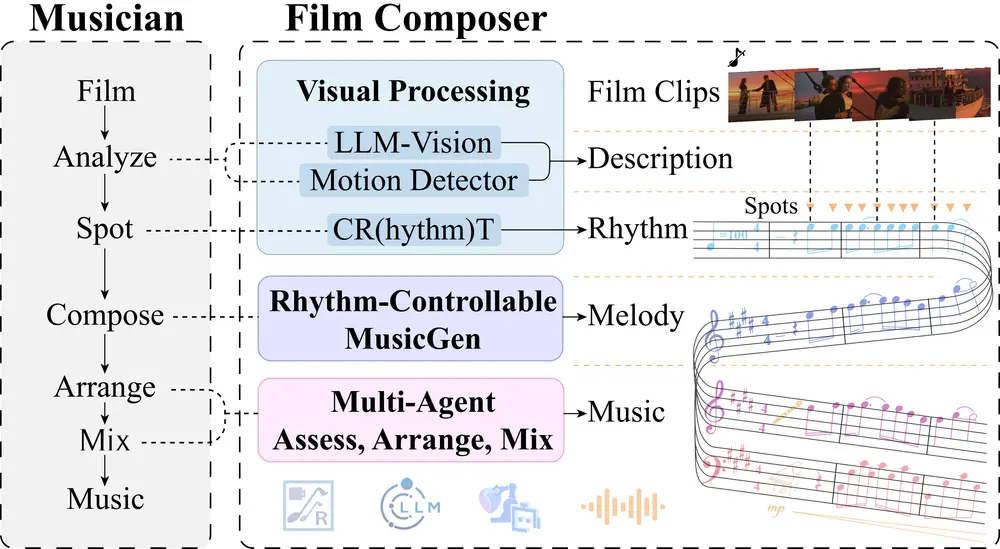

SeedVR2的工作原理基于以下几个关键步骤:

- 预训练模型初始化:使用预训练的扩散模型(如SeedVR)作为初始化,该模型已经在大规模数据上进行了训练。

- 对抗性后训练:通过对抗性训练进一步优化模型,使其能够更好地适应真实世界的数据。具体来说,使用真实视频数据对模型进行微调,以提高其生成能力和鲁棒性。

- 自适应窗口注意力:在高分辨率视频修复中,传统的固定窗口注意力机制会导致边界伪影。SeedVR2通过动态调整窗口大小,使其能够更好地适应不同分辨率的输入,从而提高模型的鲁棒性和生成质量。

- 特征匹配损失:为了提高训练效率和模型的稳定性,提出了一种新的特征匹配损失函数。该损失函数通过直接从判别器中提取特征,并测量预测和真实值之间的特征距离,从而替代了传统的LPIPS损失。

测试结果

SeedVR2在多个基准数据集上进行了广泛的实验,结果表明其性能优于现有的视频修复方法:

- 定量结果:在多个合成和真实世界的基准数据集上,SeedVR2在感知质量指标(如LPIPS和DISTS)上表现优异。例如,在YouHQ40数据集上,SeedVR2的LPIPS和DISTS指标分别为0.274和0.110,优于其他方法。

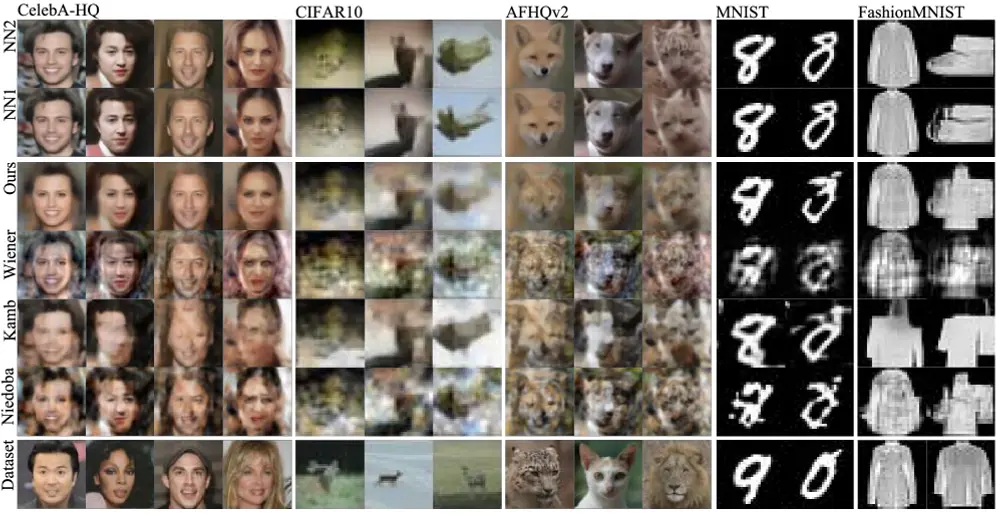

- 定性结果:通过视觉比较,SeedVR2生成的视频在细节和纹理上表现出色,能够有效去除低质量视频中的退化,同时保持原始内容的完整性。

- 用户研究:通过用户偏好测试,SeedVR2在视觉质量上获得了较高的评分,表明其生成的视频更符合人类视觉感知。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...