生成式 AI 发展到今天,很多问题已经解决,但仍有两大“顽疾”困扰着企业用户:

- 文本转 SQL 的准确性问题:AI 写出来的 SQL 看起来像模像样,但在真实数据库上却执行失败;

- AI 推理的速度与成本问题:推理太慢影响用户体验,推理太贵又难以大规模部署。

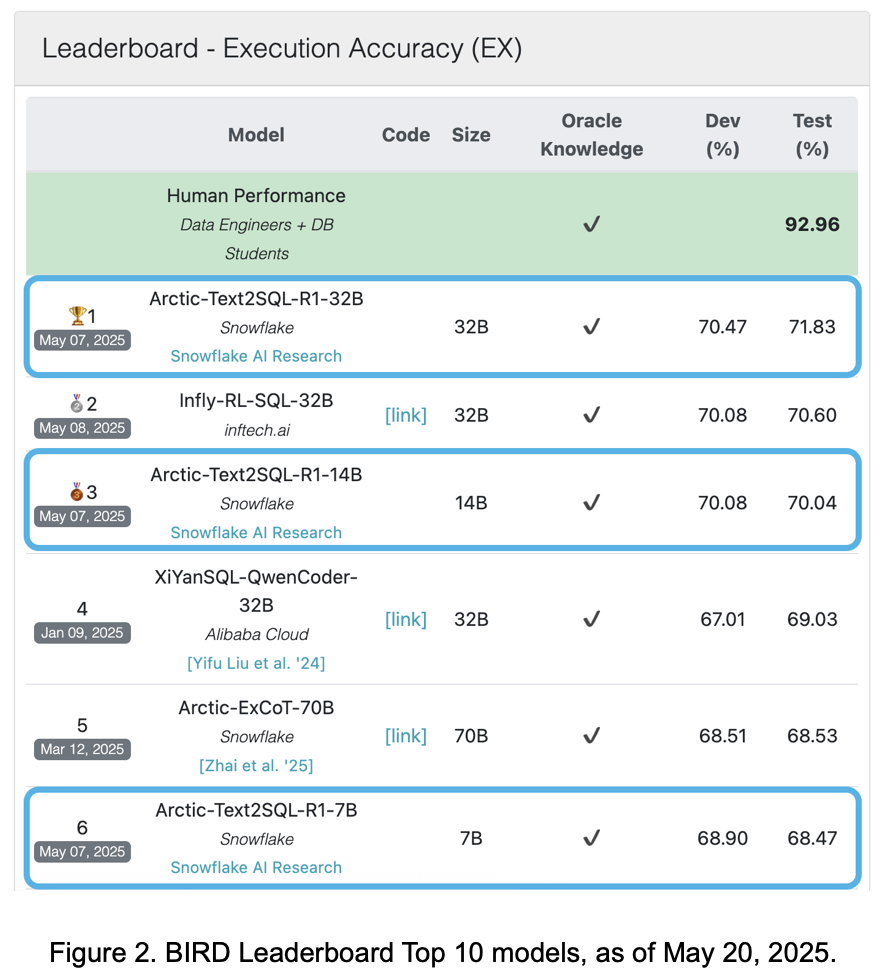

最近,全球领先的数据云平台 Snowflake 宣布开源两款新工具——Arctic-Text2SQL-R1 和 Arctic Inference,分别针对上述两个痛点提出了解决方案。

- Arctic-Text2SQL-R1 :https://huggingface.co/Snowflake/Arctic-Text2SQL-R1-7B

- Arctic Inference:https://github.com/snowflakedb/ArcticInference

它们不仅是技术上的创新,更是对企业级 AI 实际需求的深度回应。

🧠 文本到 SQL:不是写得像人就行,关键是能跑通!

很多大语言模型(LLM)都能把自然语言翻译成 SQL 查询语句,比如你输入“帮我找下过去三个月销售额最高的产品”,AI 就能自动生成对应的 SQL 命令。

听起来很酷,但现实往往很残酷:这些生成的 SQL 在真实数据库中经常执行失败。

为什么?

因为大多数模型训练的目标是“看起来像人类写的 SQL”,而不是“真的能在数据库里跑出结果”。当查询涉及复杂表结构、模糊描述或嵌套逻辑时,AI 往往会“想当然地模仿”,导致错误。

❗ Snowflake 的解决方案:让 AI 学会“执行正确性”

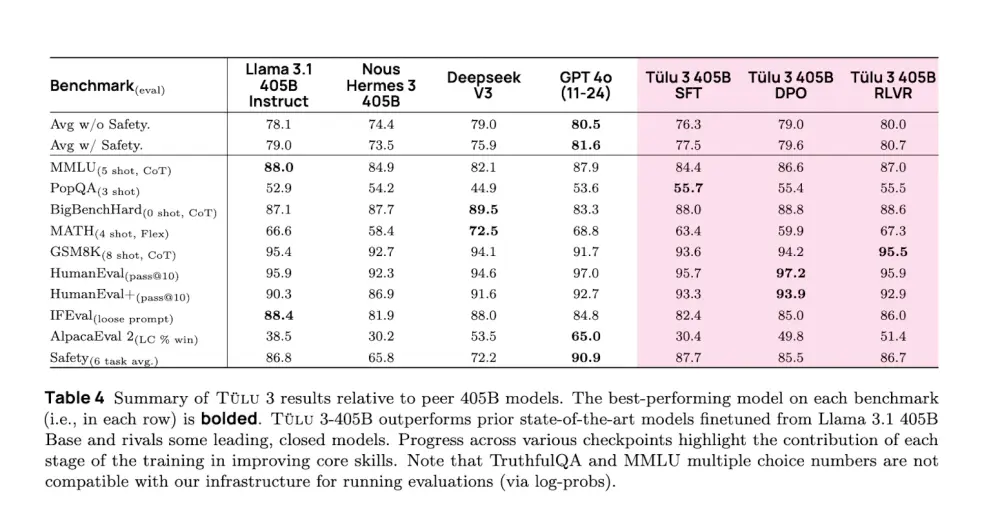

Snowflake 推出了一个全新的文本到 SQL 模型 —— Arctic-Text2SQL-R1,它不同于传统方法的关键在于:

不是训练 AI 写“看起来对”的 SQL,而是直接训练它写出“能跑通”的 SQL。

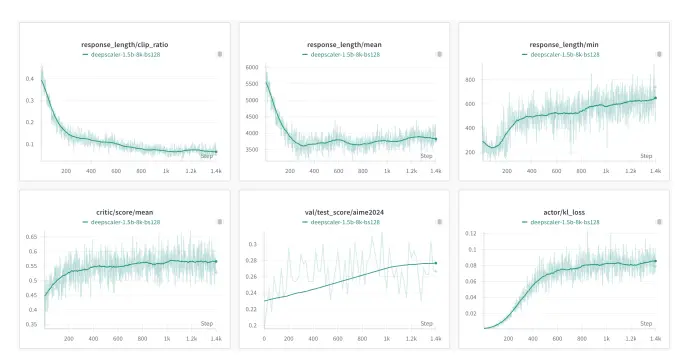

他们采用了一种叫做 Group Relative Policy Optimization (GRPO) 的强化学习方法,奖励机制非常简单粗暴:

✅ SQL 能不能跑?

✅ 结果是不是正确的?

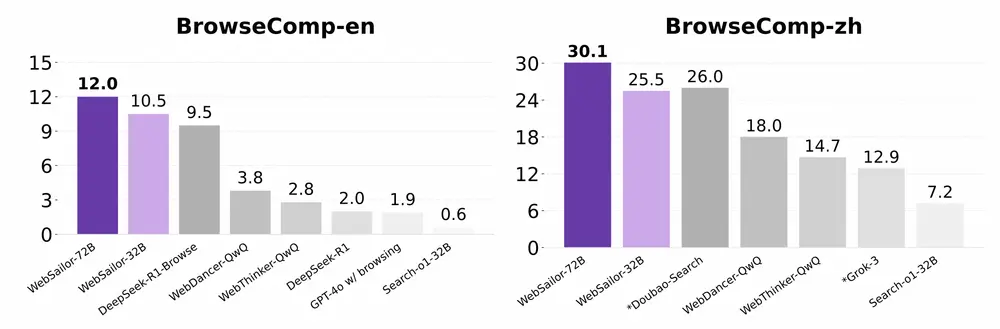

这种“以执行为导向”的训练方式,使得 Arctic-Text2SQL-R1 在多个基准测试中表现优于现有主流模型。

Snowflake 的 AI 工程师 Yuxiong He 表示:“我们不关心 AI 写出来的 SQL 是否像人写的,我们只在乎它能不能真正用。”

⚡ 推理速度 vs 成本效率:终于可以“鱼与熊掌兼得”了

另一个长期困扰企业的难题是:AI 推理到底要快,还是要省?

目前的推理系统通常只能二选一:

- 如果你追求响应速度快,就得牺牲吞吐量,GPU 利用率低;

- 如果你想节省成本,就只能接受较长的响应时间。

这背后的原因在于:不同并行化策略之间互不兼容,无法动态切换。

❗ Snowflake 的解决方案:Shift Parallelism 技术

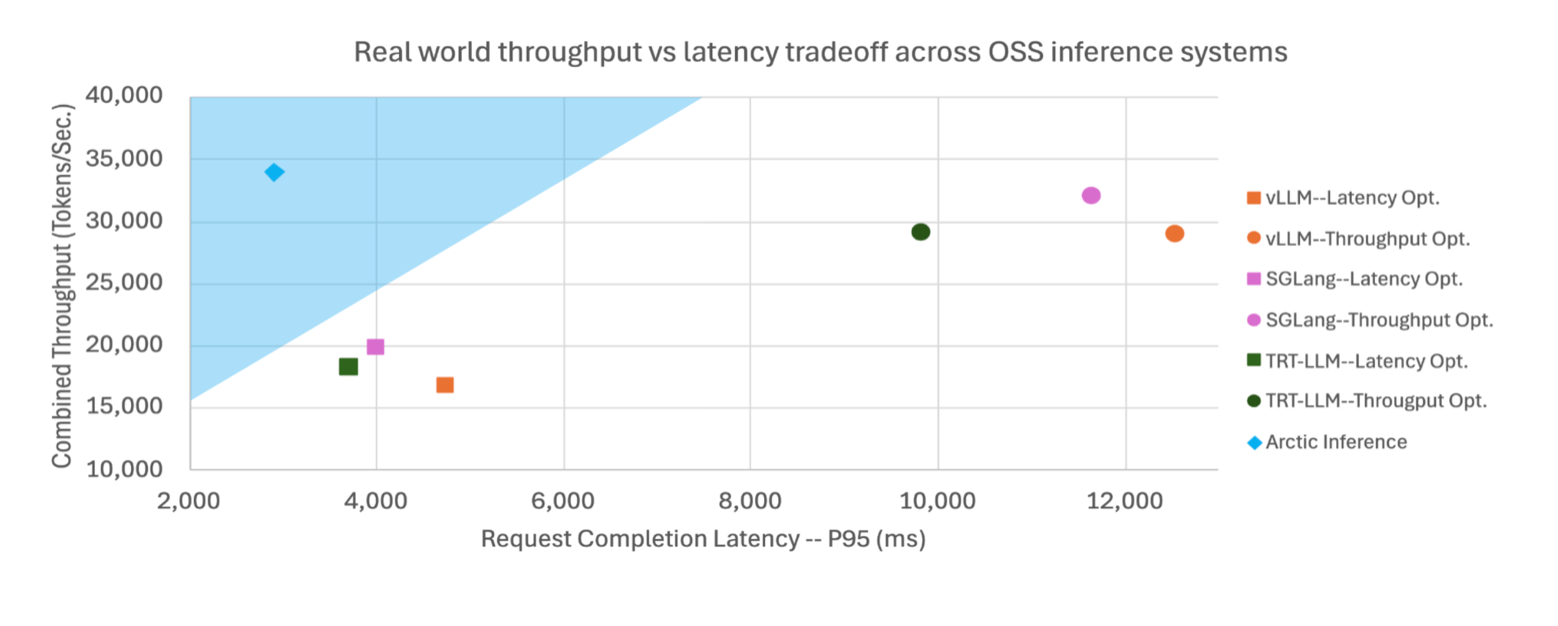

Snowflake 推出了 Arctic Inference,引入了一项名为 Shift Parallelism 的新技术,可以在运行时根据实时流量情况,自动切换不同的并行策略。

它的核心原理是:

- 流量低时使用张量并行(Tensor Parallelism);

- 流量高时切换到 Arctic Sequence Parallelism,将长序列拆分到多个 GPU 上并行处理。

这种方式既保证了响应速度,又提升了 GPU 的利用率,从而实现性能提升 + 成本下降的双重目标。

据 Snowflake 首席 AI 架构师 Samyam Rajbhandari 介绍:

“Arctic Inference 让 AI 推理速度比当前任何开源项目快两倍以上。”

而且,它还能无缝集成到现有的 vLLM 推理服务中,无需修改原有工作流,真正做到“开箱即用”。

🏢 对企业的战略意义

这两项开源技术并不是为了“秀技术肌肉”,而是直击企业在部署 AI 过程中最实际的问题:

✅ 文本到 SQL:让业务人员也能轻松查数据

对于非技术人员来说,SQL 是一道门槛。而 Arctic-Text2SQL-R1 可以让他们通过自然语言就能完成复杂的数据库查询,极大降低数据分析的门槛。

更重要的是,它解决了“看似正确实则无效”的问题,让 AI 真正成为值得信赖的数据助手。

✅ AI 推理:统一部署路径,降本增效

Arctic Inference 提供了一个既能应对突发流量、又能兼顾日常负载的统一推理架构,帮助企业避免维护多套系统的复杂性。

这对于正在考虑规模化部署 AI 应用的企业来说,是一个极具吸引力的解决方案。

相关文章