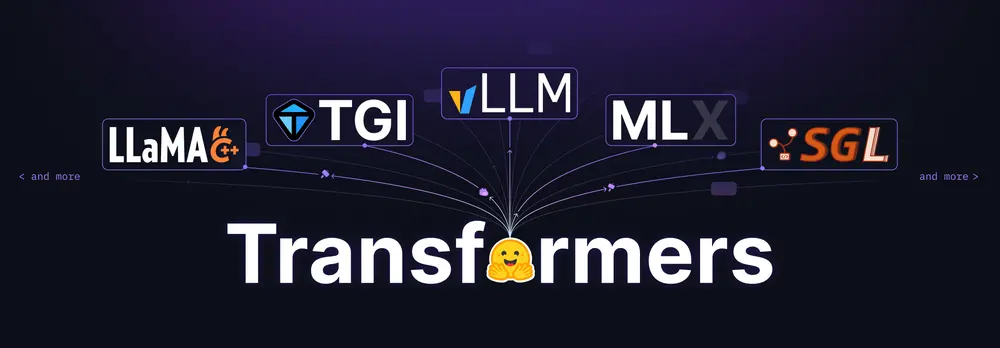

自 2019 年首次发布以来,Hugging Face 的 Transformers 库已经成为机器学习生态系统的核心组件之一。它不仅是自然语言处理(NLP)领域的标杆工具,还逐渐扩展到音频、计算机视觉以及多模态领域。如今,Transformers 已成为 Python 生态系统中大语言模型(LLM)和视觉语言模型(VLM)的默认库,支持超过 300 种模型架构,并以每周新增约 3 种的速度持续扩展。

随着生态系统的快速发展,Transformers 正在推动模型定义的标准化,旨在为开发者提供更高效、更互操作的工具链。以下是对其最新进展和未来方向的详细解读。

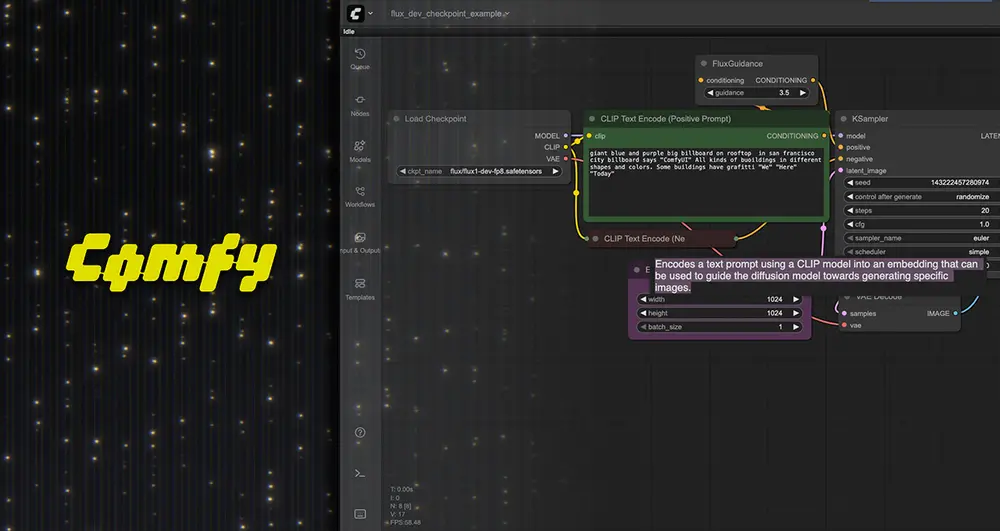

Transformers 的核心地位

Transformers 库已深度集成到主流训练框架和推理引擎中,包括 Axolotl、Unsloth、DeepSpeed、FSDP、PyTorch-Lightning 等训练框架,以及 vLLM、SGLang、TGI 等推理引擎。这种广泛的支持使得新模型一旦被添加到 Transformers 中,即可无缝地在这些工具中使用,同时享受各引擎的优势,如推理优化、动态批处理和专用内核。

例如,在 vLLM 中使用 Transformers 后端只需几行代码,即可实现超快速的产品级服务部署。此外,Transformers 还与 llama.cpp 和 MLX 等工具紧密合作,确保广泛的互操作性。例如:

- 社区的努力使 GGUF 文件可以轻松加载到 Transformers 中进行微调。

- Transformers 的 safetensors 文件与 MLX 模型直接兼容,简化了跨平台的工作流程。

通过这些合作,Transformers 的模型格式正逐渐成为社区的标准,为开发者提供了前所未有的灵活性和互操作性。

追求更简单的模型贡献

为了进一步降低模型贡献的门槛,Hugging Face 正在推进一系列简化措施,预计在未来几周内显著加速这一进程:

- 建模代码的简化

- 每种模型的建模代码将进一步优化,提供清晰、简洁的 API,涵盖关键组件(如 KV 缓存、不同注意力机制、内核优化等)。

- 弃用冗余组件,推崇简单、统一的使用方式。例如,鼓励高效的令牌化器,弃用慢速令牌器,并使用快速矢量化的视觉处理器。

- 模块化设计

- 目标是让新模型的集成仅需最少的代码更改。过去需要 6000 行代码和 20 个文件更改的情况将成为历史。

- 新模型的贡献者可以专注于核心逻辑,而无需担心复杂的集成问题。

- 社区驱动的标准化

- Hugging Face 致力于通过社区驱动的方式标准化模型实现,降低跨库贡献的门槛。

- 一次贡献即可让模型在所有集成了该实现的下游库中可用,从而大幅减少重复劳动。

这对你有什么影响?

作为模型用户

你将在使用的工具中体验到更高的互操作性。无论是训练、推理还是生产环境,标准化的模型定义将使工具之间的协作更加高效。这意味着你可以更轻松地在不同的工具之间切换,而无需担心兼容性问题。

作为模型创建者

通过标准化的模型实现,你的模型可以更快地集成到各种工具中,而无需为每个工具单独适配。这不仅降低了发布的压力,还能让你的模型更快地触达更多用户。

未来的方向

Transformers 团队正在积极推动以下目标:

- 提升互操作性:通过标准化模型定义,促进训练、推理和生产工具之间的无缝协作。

- 简化贡献流程:进一步降低模型贡献的复杂性,吸引更多开发者参与。

- 支持新兴领域:继续扩展对音频、视觉和多模态模型的支持,适应不断变化的需求。

为什么标准化如此重要?

在一个快速发展的生态系统中,碎片化往往是最大的挑战之一。通过标准化模型定义,Transformers 不仅降低了开发者的负担,还促进了工具链之间的协作。无论你是希望快速部署模型的工程师,还是致力于前沿研究的科学家,Transformers 都将为你提供更高效、更灵活的支持。

相关文章