LightDiffusion-Next 是一款集速度、精度和灵活性于一身的 AI 驱动图像生成工具,支持图形界面(GUI)和命令行界面(CLI)。它基于原始的 LightDiffusion 仓库重构并改进而成,不仅提升了可用性、可维护性和功能性,还引入了大量新功能,极大地简化了创作流程。

- GitHub:https://github.com/LightDiffusion/LightDiffusion-Next

- Demo:https://huggingface.co/spaces/Aatricks/LightDiffusion-Next

开发动机

LightDiffusion 最初计划用 Rust 编写,但由于 AI 社区对 Rust 的支持不足,最终选择 Python 实现。其目标是打造一个简单且快速的 AI 图像生成工具。首个版本的 LightDiffusion 仅包含 3000 行代码,基于 Pytorch 开发。然而,随着项目复杂度的提升,重构的需求日益凸显。于是,LightDiffusion-Next 应运而生,它拥有更模块化、更可维护的代码库,并引入了众多新功能和优化。

核心亮点

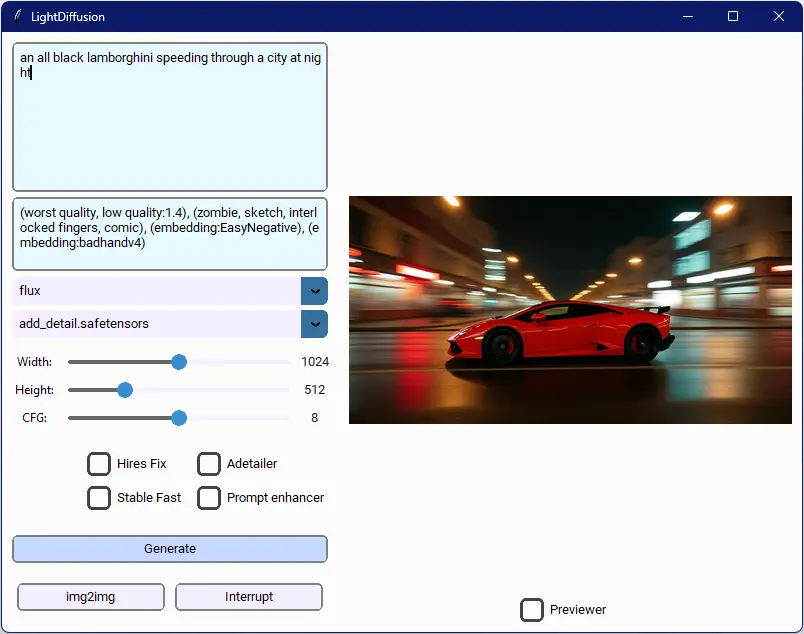

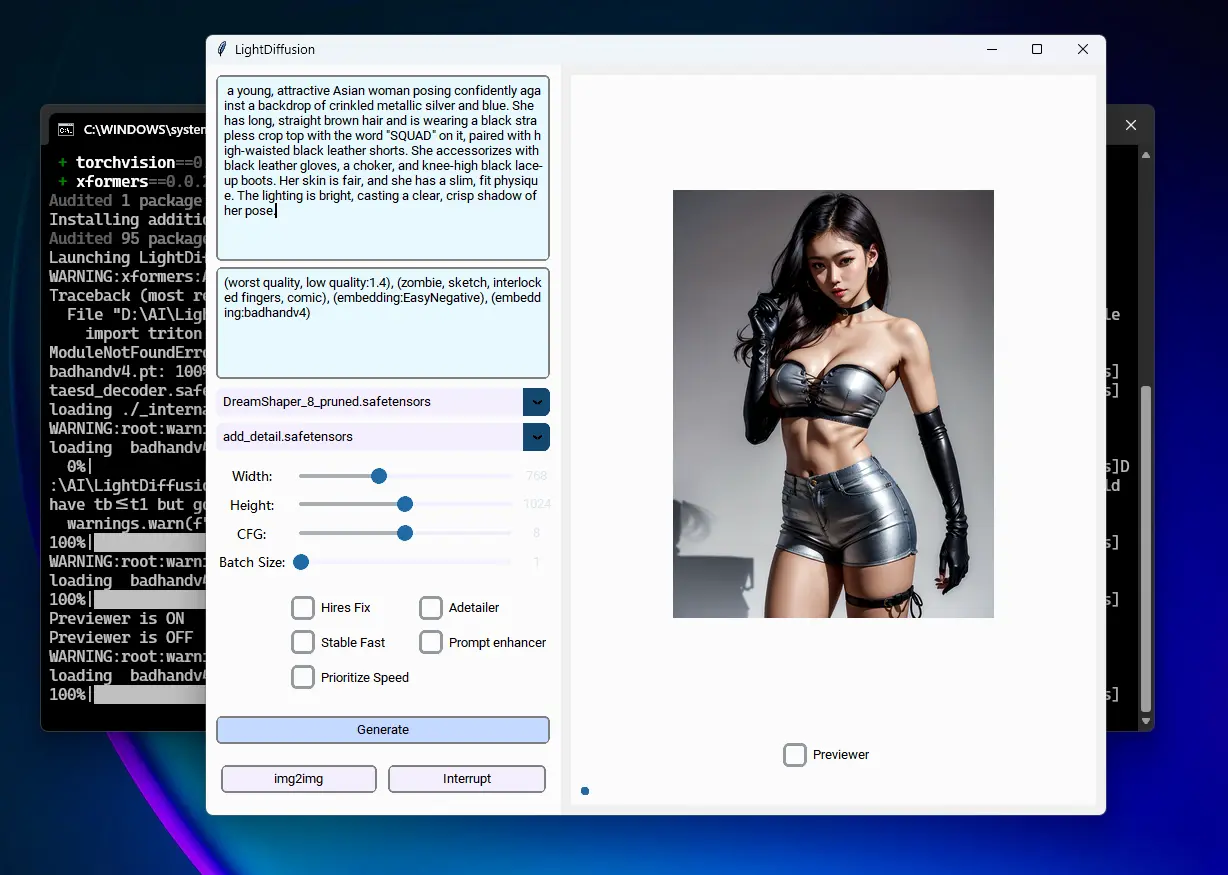

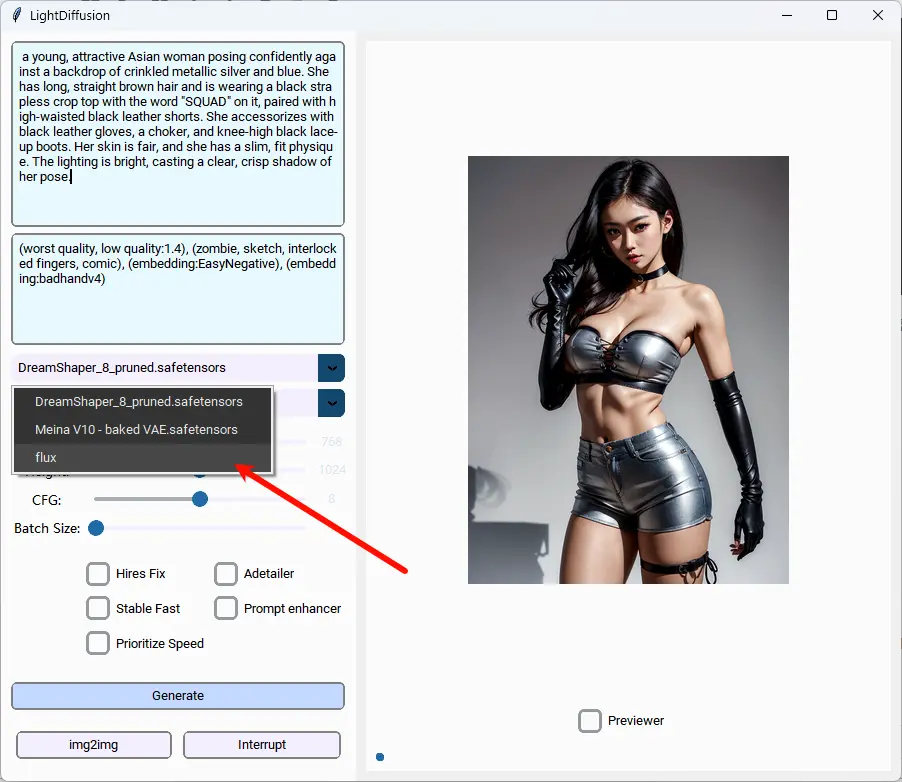

LightDiffusion-Next 提供了一套强大的工具,满足不同层次创作者的需求。其核心功能包括文本到图像(Txt2Img)和图像到图像(Img2Img)生成,支持多种放大方法和采样器,帮助用户轻松生成令人惊叹的图像。

高级功能

- 高级工具:支持注意力语法、Hires-Fix 和 ADetailer 等功能,为生成复杂和高分辨率的图像提供更好的质量和灵活性。

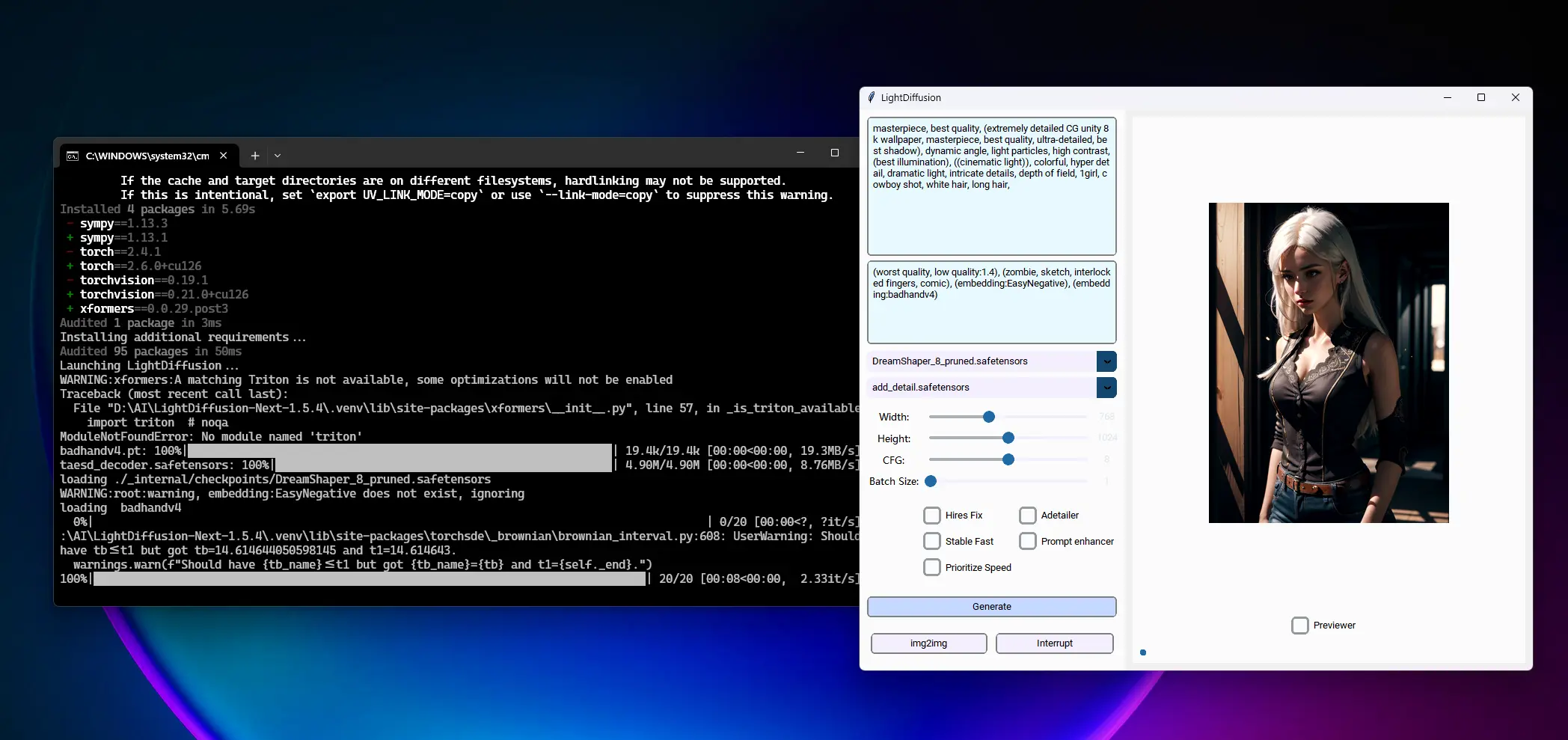

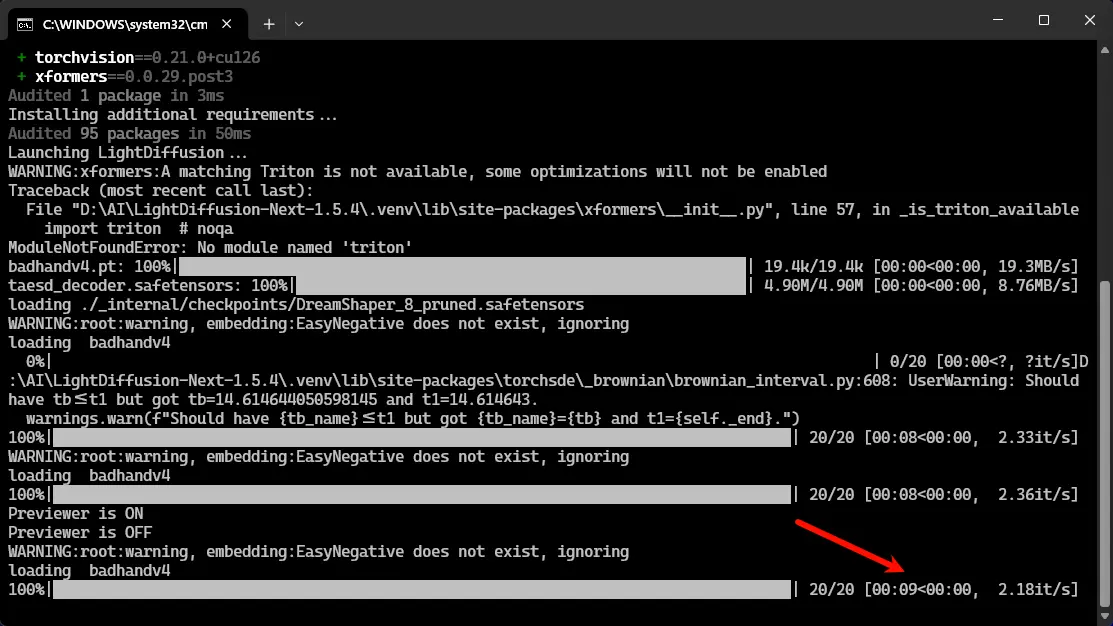

- 性能优化:通过 Xformers 加速、BFloat16 精度支持、WaveSpeed 动态缓存和 Stable-Fast 模型编译(速度提升高达 70%),确保在高负载下也能高效运行。

功能展示

- 速度与效率:内置 Xformers、Pytorch、WaveSpeed 和 Stable-Fast 优化,性能领先行业。与 SD1.5 中的其他 AI 图像生成工具相比,速度提升 30%,Flux 提升 2 倍。

- 自动细节处理:使用基于 Impact Pack 的 AI 驱动工具,轻松增强面部和身体细节。

- 状态保存:保存进度并随时恢复,确保会话间无缝过渡。

- 多种界面支持:提供高级 GUI、WebUI 和 CLI,用户可选择图形界面、浏览器界面或命令行界面进行创作。

- 集成协作:通过 Boubou 在 Discord 中协作,或使用 TAESD 预览模式动态预览图像。

- 图像预览与放大:使用 TAESD 实现实时预览,通过 UltimateSDUpscaling 等高级选项提升图像质量。

- 提示词优化:借助 Ollama 驱动的自动提示词增强器,生成更准确、更详细的输出。

- 定制化功能:支持 LoRa 和文本反转嵌入,实现高度定制化创作。

- 设备兼容性:支持低端设备,仅需 2GB VRAM 或无需 GPU,确保所有用户都能使用。

- CFG++:采用改进的采样器,与传统方法相比,获得更高质量的结果。

性能基准

在性能方面,LightDiffusion-Next 表现卓越。以下是基于 1024x1024 分辨率、批量大小为 1、BFloat16 精度的基准测试结果(使用配备 SD1.5 的 3060 移动 GPU 测试):

| 工具 | 速度(it/s) |

|---|---|

| LightDiffusion with Stable-Fast | 2.8 |

| LightDiffusion | 1.9 |

| ComfyUI | 1.4 |

| SDForge | 1.3 |

| SDWebUI | 0.9 |

凭借其卓越的速度和效率,LightDiffusion-Next 成为 AI 图像生成工具的新标杆。

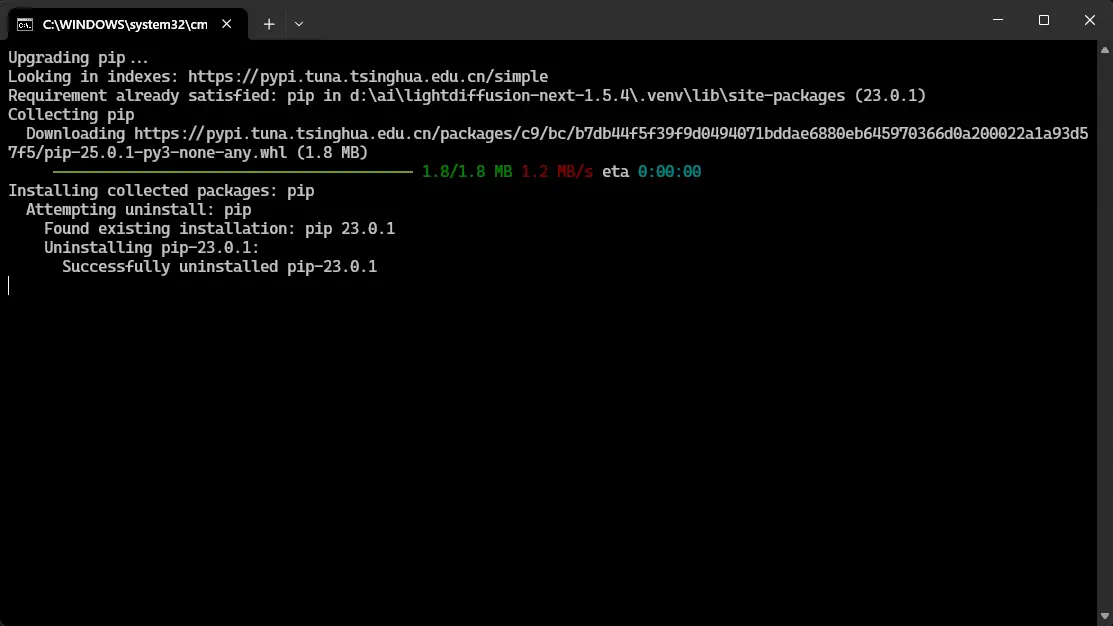

快速安装与使用

- 下载发布版本或克隆仓库。

- 在终端运行

run.bat。 - 开始创作

PS:运行run.bat后会自动安装相关组件及两款SD1.5模型,如果想使用Flux模型,需要满足以下条件:

前提条件

在开始之前,请确保你有以下物品:

- 硬盘上至少有25GB的可用空间(建议40-50GB)

- 支持CUDA的GPU,至少6GB显存(建议16GB以上)

技巧和窍门

- 推荐的分辨率:Flux在特定分辨率下表现最佳。请参考这份指南,了解最佳的分辨率选择。

- 内存管理:Flux需要大量的显存。调整批次大小和分辨率设置以优化内存使用。

- 尝试不同的提示:Flux 可能对提示的反应与标准模型不同。可以尝试不同的提示风格,找出最有效的方法。

相关软件

Traintrain Standalone - 最新版

RapidRAW - 最新版

![LightDiffusion-Next 的使用截图[1]](https://pic.sd114.wiki/wp-content/uploads/2025/03/1740993495-1740993495-LightDiffusion-Next-2.webp)