2025 年 2 月 25 日,阿里通义实验室正式开源了其最新一代视频生成模型 Wan2.1 系列。这一系列模型包括文生视频和图生视频,每个模型都具备独特的优势和应用场景:

- Wan2.1-I2V-14B:图生视频,提供 480P 和 720P 两种分辨率,能够生成展示复杂视觉场景和运动模式的视频。

- Wan2.1-T2V-14B:文生视频,能够生成具有强大运动动态的高质量视觉效果。

- Wan2.1-T2V-1.3B:支持在几乎所有消费级显卡上运行,仅需 8.19 GB 显存即可生成 5 秒的 480P 视频。

尽管这些模型功能强大,且 ComfyUI 官方已经原生支持 Wan2.1 系列,第三方插件作者也进行了优化,但由于模型体积较大,多数用户的显卡在运行时会爆显存。(相关:ComfyUI 宣布已原生支持阿里开源视频生成模型Wan2.1)

- ComfyUI官方工作流:https://comfyanonymous.github.io/ComfyUI_examples/wan

- ComfyUI官方量化模型:Hugging Face|魔塔 (国内用户请从魔塔下载)

不过,开源社区的力量不容小觑,开发者们已经通过量化模型和优化节点来降低显存占用。今天,我们将分享两款仅需 12GB 显存即可运行的 Wan2.1 480P I2V 模型的工作流。

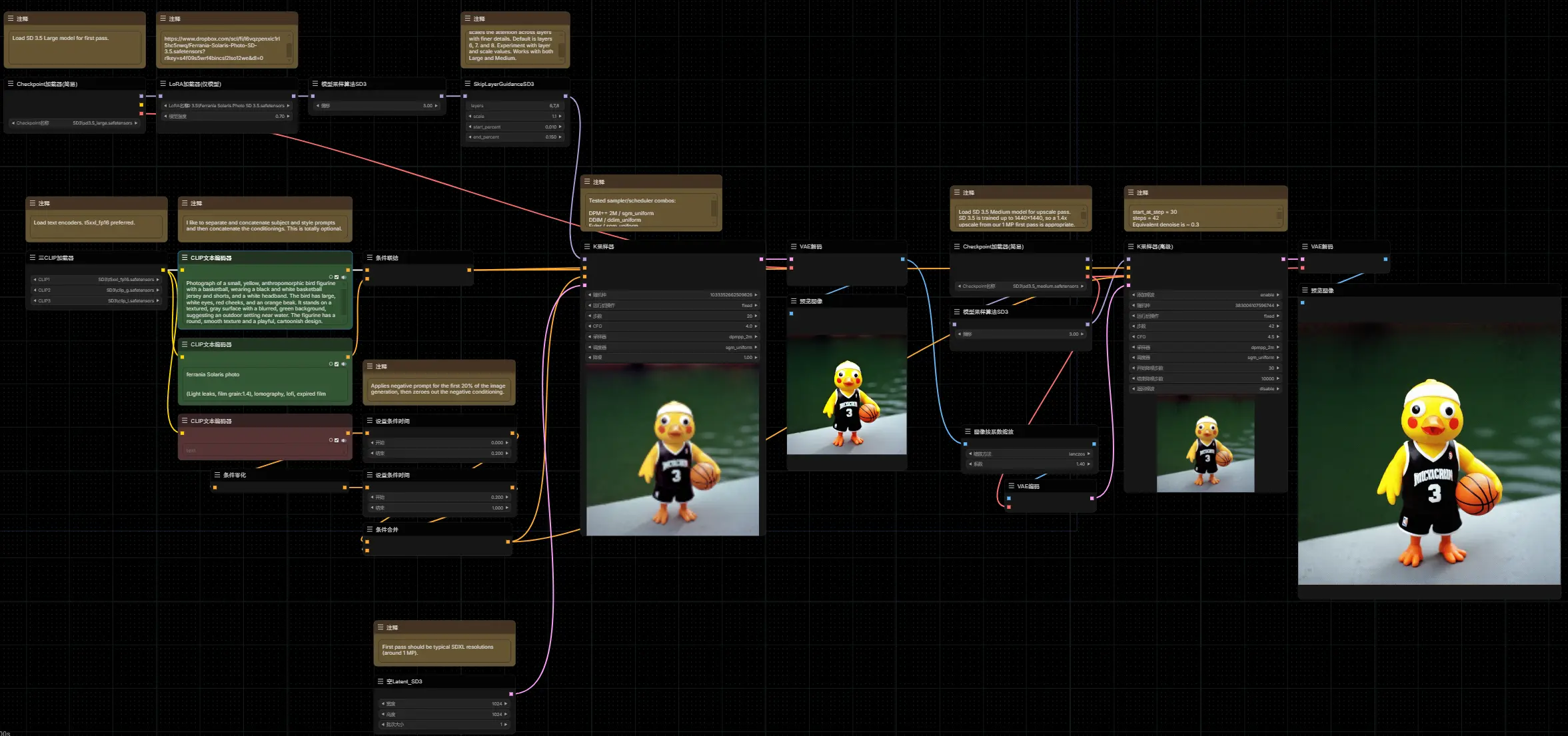

第一款:Wan 2.1 GGUF I2V + Upscale

这款工作流主要依赖 ComfyUI-GGUF 和 ComfyUI-KJNodes 两款插件,运用了 Triton 和 SageAttention 等加速技术。此前,Triton 在 Windows 上的安装较为复杂,但近期已有开发者将其移植到 Windows 平台,并上架至 PyPI。

- 工作流:https://civitai.com/models/1278171

- ComfyUI-GGUF:https://github.com/city96/ComfyUI-GGUF

- ComfyUI-KJNodes:https://github.com/kijai/ComfyUI-KJNodes

- triton-windows:https://github.com/woct0rdho/triton-windows

- GGUF量化模型:Hugging Face|魔塔 (国内用户请从魔塔下载)

安装方法

- 找到你安装的 ComfyUI 文件夹下的

python目录,定位到python.exe文件。 - 鼠标右键单击

python.exe,选择“复制文件地址”。 - 打开终端(以管理员身份运行),并使用以下命令安装依赖:

python_embeded\python.exe -m pip install sageattention

python_embeded\python.exe -m pip install triton-windows将 python_embeded\python.exe 替换为你复制的 python.exe 文件地址。

模型放置

- Wan2.1 480p I2V:

/unet(根据需要调整) - Clip vision:

/clip_vision - Vae:

/vae - Text encoder:

/clip或/text_encoders - (可选) Upscale:

/upscale_models

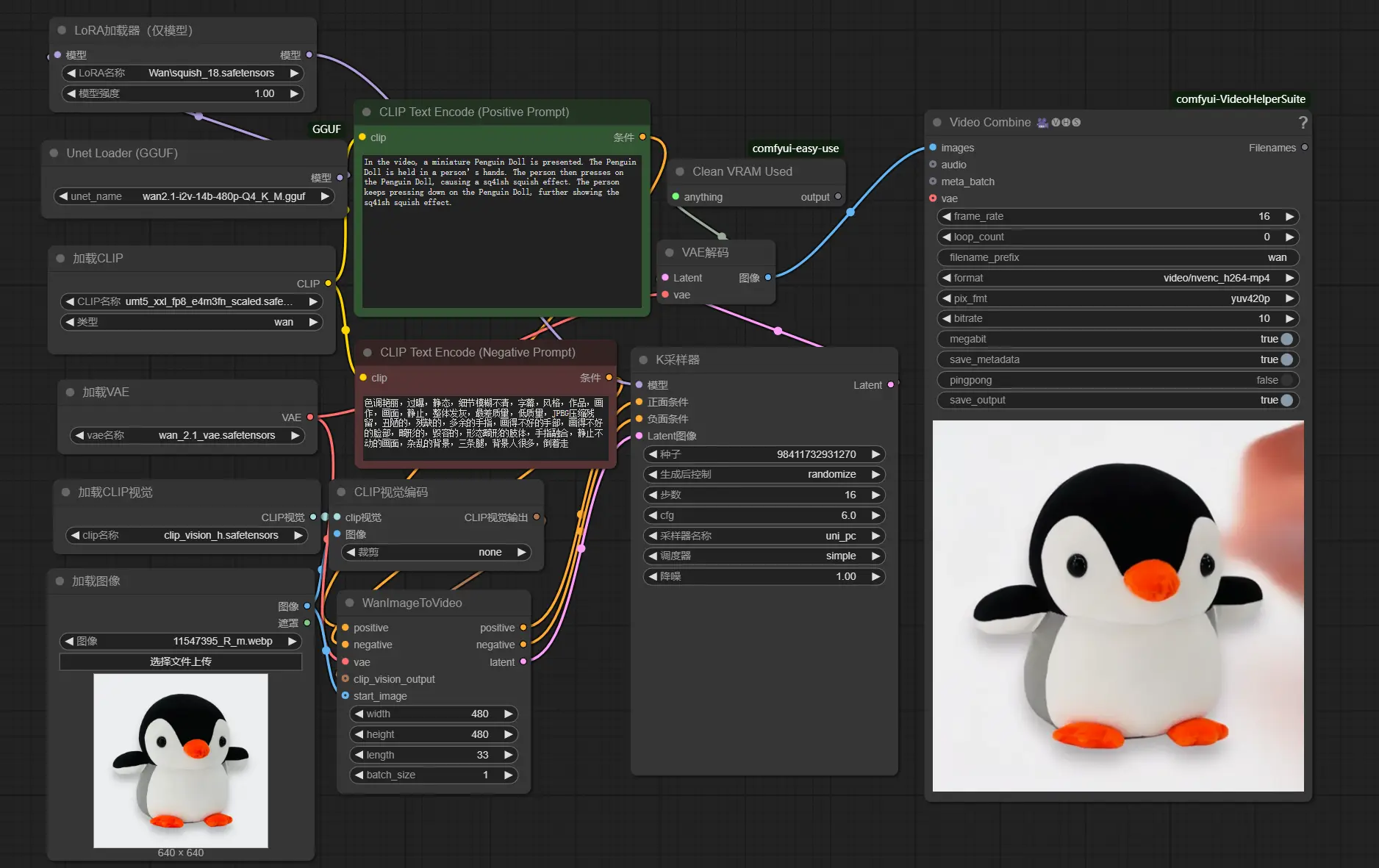

第二款:Wan 2.1 简单工作流

这款工作流相对简单,主要依赖 ComfyUI-GGUF 插件,使用了作者 city96 优化的量化版 GGUF 模型。通过这一版本,用户可以在较低显存的设备上快速生成视频,而无需复杂的配置。

总结

开源模型的强大之处在于社区的支持和持续优化。通过上述两款工作流,用户可以在仅需 12GB 显存的设备上运行 Wan2.1 480P I2V 模型,大大降低了硬件门槛。无论是复杂的图生视频还是高效的文生视频,Wan2.1 系列都能满足你的需求。希望这些优化方案能帮助你更好地利用这一强大的工具,释放你的创造力。

- 工作流备份下载:https://www.123865.com/s/hyQyTd-wuhDv 提取码:qewS

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...