如果你使用的是 AMD Radeon™ 显卡,现在也可以在 Windows 上高效运行基于 PyTorch 的 AI 工作流,例如 ComfyUI。通过 Windows Subsystem for Linux (WSL) 结合 ROCm™ 软件平台,你可以充分利用 AMD显卡的计算能力,本地加载 Flux、Wan等大模型,进行图像生成与创意探索。

本文将带你完成从环境搭建到启动 ComfyUI 的完整流程,涵盖 WSL 配置、ROCm 驱动安装、PyTorch 适配以及 ComfyUI 的部署与运行,帮助你在 AMD 平台上构建稳定高效的 AI 开发环境。

前提条件

在开始前,请确认你的系统满足以下要求:

- 支持 ROCm 的 AMD Radeon™ 显卡

- AMD Software: Adrenalin Edition™ 25.6.1 或更高版本

- 已启用 WSL,并准备安装 Ubuntu 22.04 或 24.04(推荐 24.04)

💡 提示:ROCm 对显卡型号有明确支持列表,建议查阅 AMD 官方文档 确认你的设备是否在支持范围内。

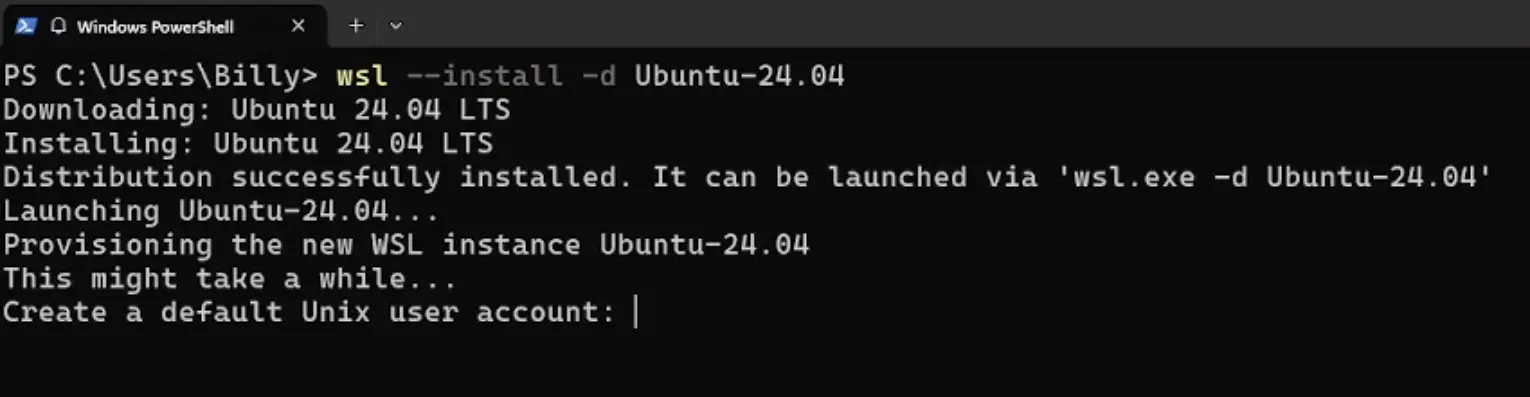

步骤 1:安装 WSL 与 Ubuntu

以管理员身份打开 PowerShell 或命令提示符,执行以下命令:

wsl --install -d Ubuntu-24.04

系统将自动下载并安装 Ubuntu 24.04 的 WSL 实例。安装完成后,会提示你创建用户名和密码,请妥善记住,后续操作将频繁使用。

安装完成后,可通过以下命令启动:

wsl -d Ubuntu-24.04

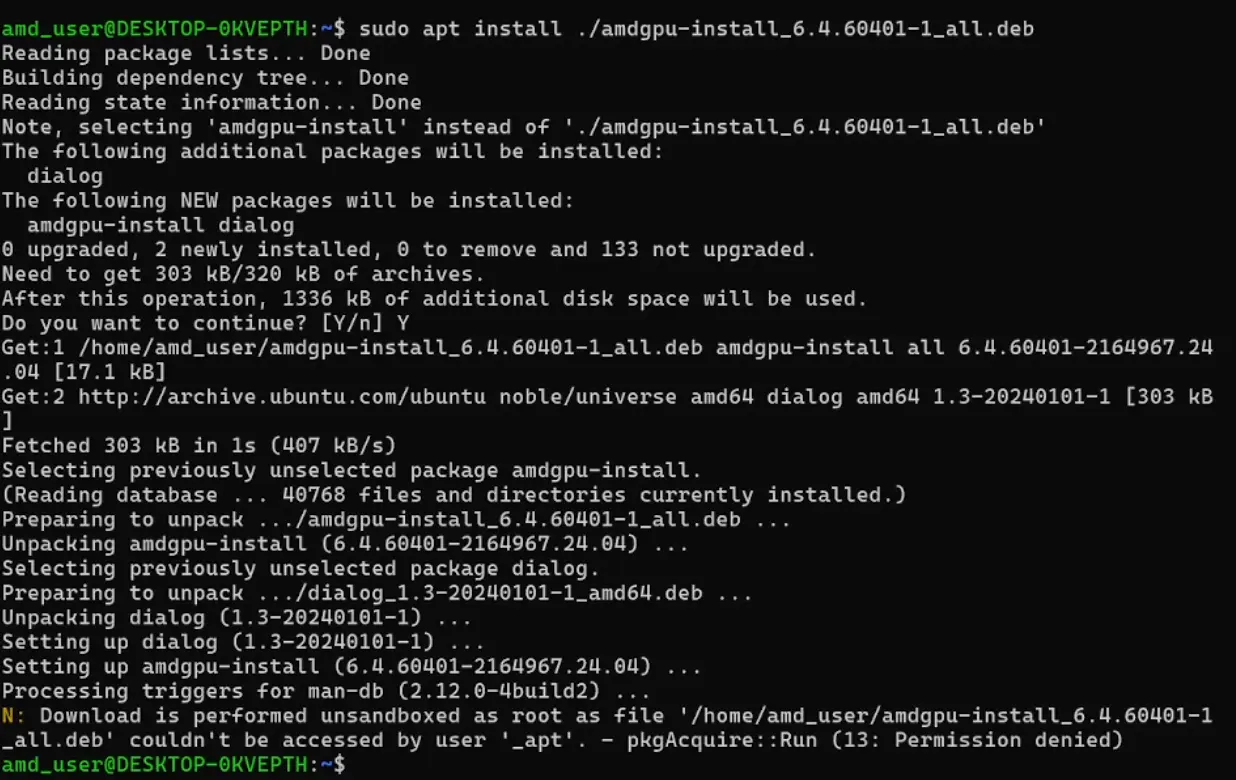

步骤 2:配置 AMD 驱动仓库

进入 WSL 环境后,首先更新软件包列表,并添加 AMD 官方驱动仓库:

sudo apt update

wget https://repo.radeon.com/amdgpu-install/6.4.2.1/ubuntu/noble/amdgpu-install_6.4.60402-1_all.deb

sudo apt install ./amdgpu-install_6.4.60402-1_all.deb

该脚本为 Ubuntu 24.04(代号 Noble)提供 ROCm 和图形驱动支持。

步骤 3:安装 ROCm 软件栈

运行以下命令安装适用于 WSL 的 ROCm 统一构建包:

amdgpu-install -y --usecase=wsl,rocm --no-dkms

此过程可能需要数分钟。安装完成后,验证 ROCm 是否正常识别 GPU:

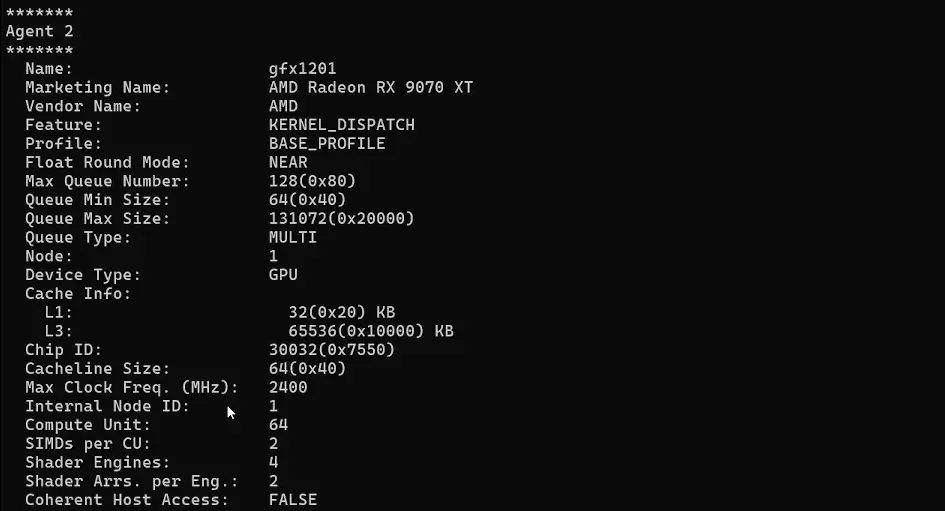

rocminfo

若输出中包含 Agent 信息并列出你的 GPU 型号(如 Radeon RX 7900 XTX),说明 ROCm 已成功加载。

步骤 4:部署 ComfyUI 环境

4.1 创建 Python 虚拟环境

为避免依赖冲突,建议使用虚拟环境:

python3 -m venv venv --system-site-packages

source venv/bin/activate

4.2 安装 Python 基础工具

sudo apt install python3-pip -y

pip3 install --upgrade pip wheel

⚠️ 注意:当前

numpy v2.0与 ROCm 版本的 PyTorch 不兼容。如遇问题,手动降级:pip3 install numpy==1.26.4

4.3 安装支持 ROCm 的 PyTorch

AMD 推荐从官方仓库安装经过验证的 PyTorch WHL 包,而非 PyTorch.org 的 nightly 构建。

以 ROCm 6.4.1 + Python 3.12 为例,执行以下命令:

wget https://repo.radeon.com/rocm/manylinux/rocm-rel-6.4.1/torch-2.6.0%2Brocm6.4.1.git1ded221d-cp312-cp312-linux_x86_64.whl

wget https://repo.radeon.com/rocm/manylinux/rocm-rel-6.4.1/torchvision-0.21.0%2Brocm6.4.1.git4040d51f-cp312-cp312-linux_x86_64.whl

wget https://repo.radeon.com/rocm/manylinux/rocm-rel-6.4.1/torchaudio-2.6.0%2Brocm6.4.1.gitd8831425-cp312-cp312-linux_x86_64.whl

wget https://repo.radeon.com/rocm/manylinux/rocm-rel-6.4.1/pytorch_triton_rocm-3.2.0%2Brocm6.4.1.git6da9e660-cp312-cp312-linux_x86_64.whl

pip3 uninstall torch torchvision torchaudio pytorch-triton-rocm -y

pip3 install torch-2.6.0+rocm6.4.1.git1ded221d-cp312-cp312-linux_x86_64.whl \

torchvision-0.21.0+rocm6.4.1.git4040d51f-cp312-cp312-linux_x86_64.whl \

torchaudio-2.6.0+rocm6.4.1.gitd8831425-cp312-cp312-linux_x86_64.whl \

pytorch_triton_rocm-3.2.0+rocm6.4.1.git6da9e660-cp312-cp312-linux_x86_64.whl

🔧 修复 WSL 运行时库冲突

由于 WSL 环境中存在库路径问题,需手动移除冲突的 HSA 运行时库:

location=$(pip show torch | grep Location | awk -F ": " '{print $2}') cd ${location}/torch/lib/ rm libhsa-runtime64.so*

4.4 验证 PyTorch 安装

运行以下命令确认 PyTorch 能识别 AMD GPU:

python3 -c 'import torch; print(torch.cuda.is_available())'

预期输出为 True。

进一步查看设备信息:

python3 -c "import torch; print(f'device name [0]:', torch.cuda.get_device_name(0))"

应显示你的 AMD 显卡型号。

4.5 克隆并配置 ComfyUI

git clone https://github.com/comfyanonymous/ComfyUI.git

cd ComfyUI

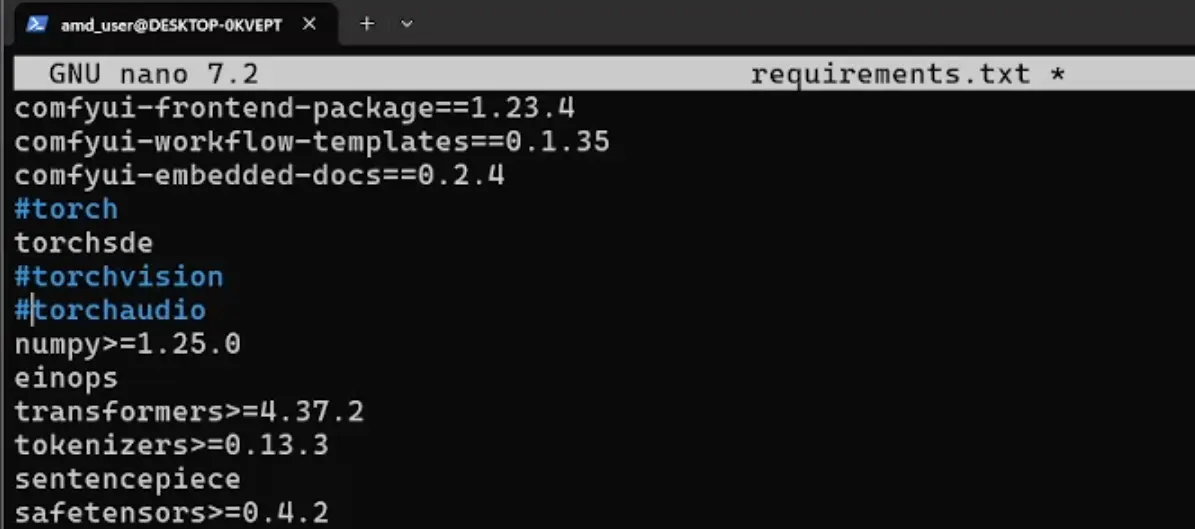

由于我们将使用 ROCm 版本的 PyTorch,需避免重复安装官方 PyTorch 包。编辑 requirements.txt,注释掉以下三行:

# torch

# torchaudio

# torchvision

使用 nano 编辑:

sudo nano requirements.txt

保存后安装其余依赖:

pip install -r requirements.txt

4.6 添加模型文件

将本地模型放入指定目录,例如 Stable Diffusion 3:

cd ComfyUI/models/checkpoints

将模型文件(如 sd3_medium_incl_clips.safetensors)复制至此目录。注意:部分模型需登录 Hugging Face 下载。

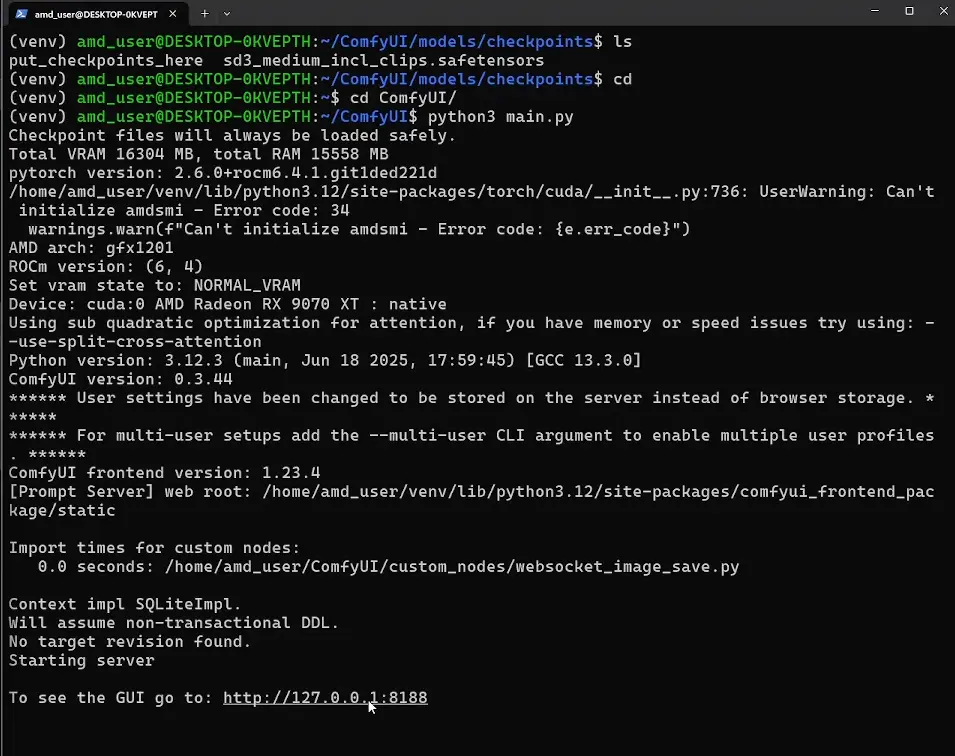

步骤 5:启动 ComfyUI

返回 ComfyUI 主目录并启动服务:

cd ..

python3 main.py

启动后,终端将输出类似以下信息:

To see the GUI go to: http://127.0.0.1:8188

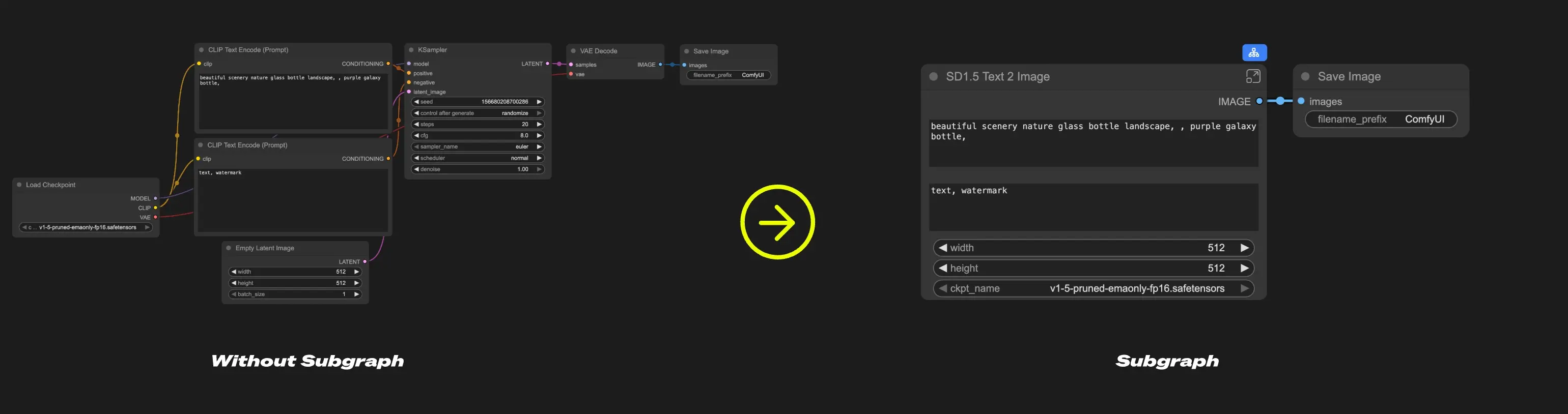

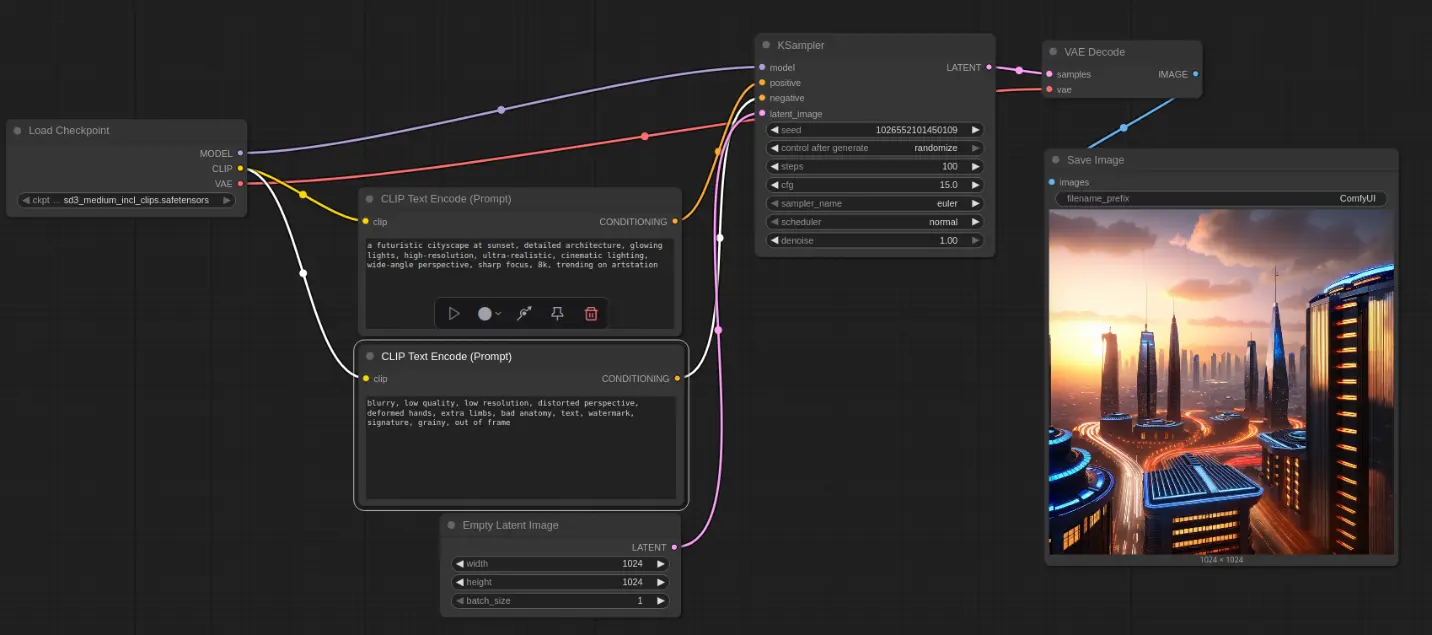

在 Windows 的浏览器中打开该地址,即可访问 ComfyUI 界面,开始你的图像生成流程。

后续使用:快速启动流程

每次重新使用时,只需依次执行以下命令:

wsl -d Ubuntu-24.04

source venv/bin/activate

cd ComfyUI

python3 main.py

浏览器打开提示的地址即可继续使用。

常见问题与注意事项

- ROCm 与 Python 版本需严格匹配:安装 WHL 包时注意

cp312或cp310标识,对应 Python 3.12 或 3.10。 - Conda 环境不被官方支持:如使用 Conda,可能遇到

GLIBCXX_3.4.30缺失问题,需手动升级 GCC。 - Docker 是替代方案:AMD 提供预构建的

rocm/pytorch镜像,可减少配置时间。 - 模型兼容性:确保使用的模型支持 ROCm 后端,部分插件可能需要额外适配。

总结

通过 WSL + ROCm + ComfyUI 的组合,AMD 显卡用户现在可以在 Windows 上构建完整的本地 AI 图像生成环境。整个流程虽然涉及多个组件的协同配置,但一旦完成,即可稳定运行 Stable Diffusion 等大模型,无需依赖云端服务。

这不仅提升了本地 AI 应用的可访问性,也为开发者和创作者提供了更灵活、更可控的工具链。(来源)

参考链接

相关文章