LibreFLUX是基于FLUX.1 [schnell] 的去蒸馏版本,旨在提供完整的 T5 上下文长度支持,使用注意力掩码,恢复无分类器指导,并移除了大部分 FLUX 美学微调/DPO。这些改动使得 LibreFLUX 相对于基础的 FLUX 模型更加灵活,但也牺牲了一些美学效果。

LibreFLUX 的特点

开源与灵活性

- Apache 2.0 许可:用户可以自由使用、修改和分发 LibreFLUX,无需从 Black Forest Labs 获取商业许可证。

- 易于微调:虽然 LibreFLUX 的初始美学效果不如基础 FLUX,但其设计使其更容易适应新的数据分布和应用场景。

技术细节

- 完整的 T5 上下文长度:支持完整的 T5 上下文长度,提高了模型对长文本输入的处理能力。

- 注意力掩码:通过在注意力过程中屏蔽填充 Token,防止信息泄露,提高模型的性能。

- 无分类器指导:恢复了无分类器指导,简化了生成过程,但需要为条件和无条件图像生成样本,增加了计算成本。

与 FLUX 系列的对比

- FLUX.1-dev:蒸馏版本,生成速度快,但需要为条件和无条件图像生成样本。

- FLUX.1-schnell:进一步蒸馏,生成速度更快,但默认情况下使用 CFG 效果较差。

FLUX 模型的蒸馏与去蒸馏

- 蒸馏模型:通过在教师模型的输出上训练学生模型,减少模型的复杂性和生成时间。例如,FLUX.1-schnell 只需 4 步条件生成即可获得图像。

- 去蒸馏模型:恢复原始训练目标,重新训练模型以恢复其完整功能。去蒸馏模型需要更多的训练时间和计算资源,但提供了更高的创造性和灵活性。

注意力掩码的作用

- T5-XXL 文本模型:FLUX 模型使用 T5-XXL 作为文本编码器,将文本填充到 256(schnell)或 512(dev)个 Token。

- 信息存储:模型利用填充 Token 存储信息,这可能导致长文本输入的性能下降。

- 注意力掩码:通过在注意力过程中屏蔽这些填充 Token,防止信息泄露,提高模型的性能和稳定性。

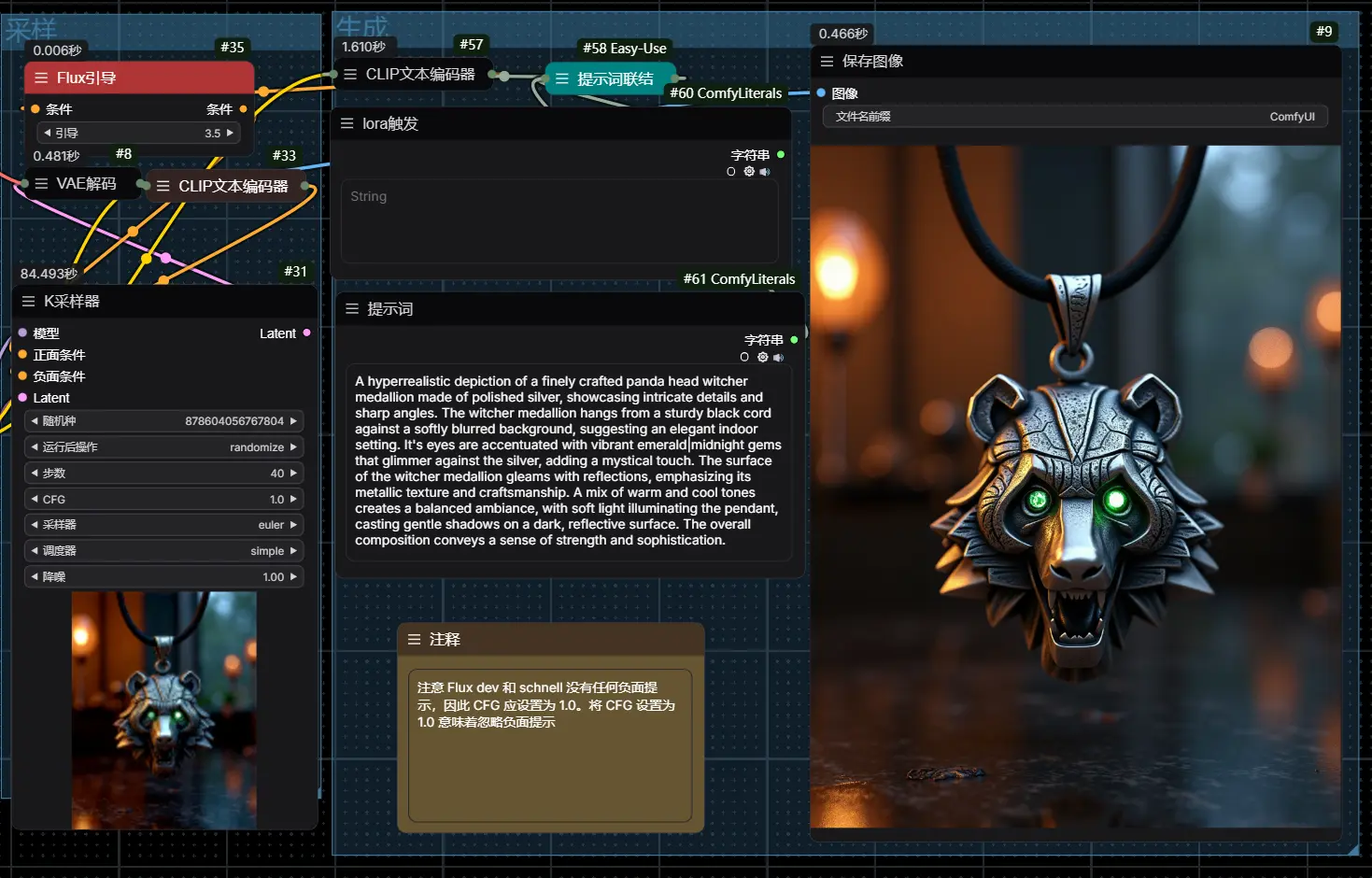

实验观察

- CFG 比例值:当使用大于 4.0 的 CFG 比例值时,LibreFLUX 和 OpenFLUX.1 模型可能会出现奇怪的阴影或模糊现象。

- 训练时间:这些模型的训练时间相对较短,可能不足以完全恢复蒸馏前的性能。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

![蓝莓真身!Black Forest Labs推出FLUX1.1 [pro]和BFL API,生成质量更高速度更快](https://pic.sd114.wiki/wp-content/uploads/2024/10/1727983937-FLUX1-1.webp~tplv-o4t1hxlaqv-image.image)