近期,互联网上兴起了一股购买Mac mini运行OpenClaw的热潮。作为一款开源自托管AI助手,OpenClaw(原名 Clawdbot,后因商标问题更名为 Moltbot,最终定名为 OpenClaw)的定位是个人专属助理,能在用户自有硬件后台持续运行,支持大量聊天应用、AI模型及各类流行工具的集成,还可实现远程控制。无论是处理财务事宜、管理社交媒体账号,还是规划日常日程,用户都能通过自己常用的消息应用完成操作,实用性拉满。

但问题来了:如果不想额外购置专用硬件,是否还能高效、安全地使用OpenClaw?答案是肯定的。今天要给大家介绍的Moltworker,就是一套中间件Worker和适配脚本,能让OpenClaw顺畅运行在Cloudflare的Sandbox SDK及开发者平台API之上,无需依赖本地专用设备。

在Cloudflare上运行个人AI助手,核心支撑是什么?

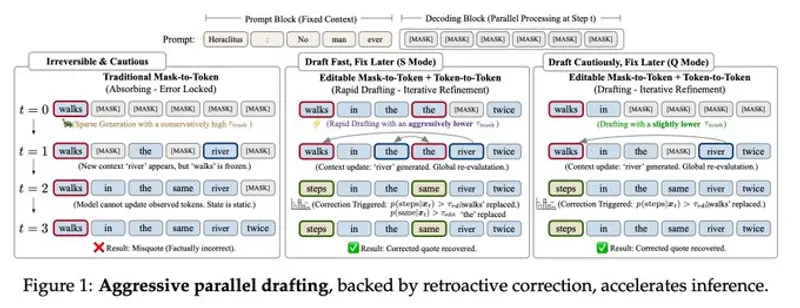

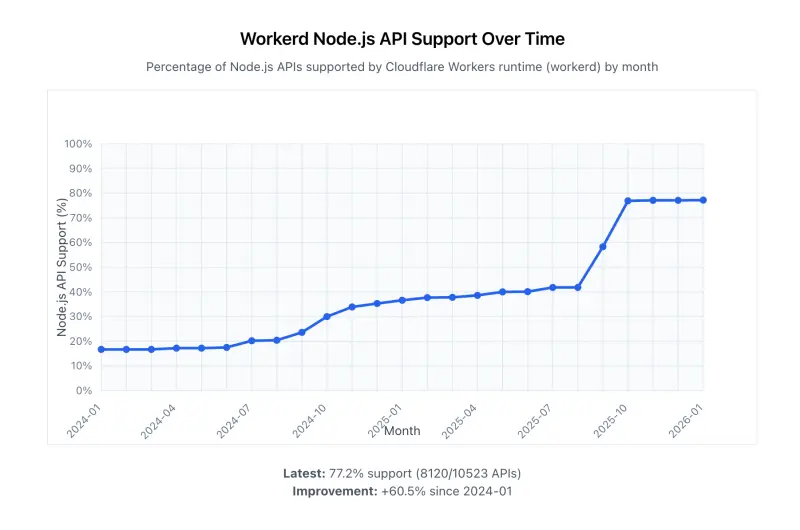

Cloudflare Workers对Node.js的兼容性,如今已达到前所未有的高度。放在过去,不少软件包要在Workers上运行,必须通过模拟API才能实现;而现在,这些关键API已被Workers Runtime原生支持,彻底改变了开发者在Cloudflare Workers上构建工具的模式。

以热门网络测试与自动化框架Playwright为例,它需要依托浏览器渲染功能运行。最初我们适配Playwright时,不得不依赖memfs作为替代方案——这种方式不仅属于临时变通,还引入了外部依赖,导致我们的代码偏离了Playwright官方代码库,后续维护和升级都十分繁琐。好在随着Node.js兼容性的持续提升,我们得以直接原生使用node:fs模块,既降低了系统复杂性,也让Playwright的版本升级变得轻松便捷。

目前,Cloudflare原生支持的Node.js API列表还在持续扩容。官方博客文章《在Cloudflare Workers中改进Node.js兼容性的一年》,详细梳理了当前的适配进展及后续规划,感兴趣的开发者可以深入研读。

为了验证兼容性成果,我们开展了一项针对性实验:选取1000个最受欢迎的NPM包,模拟软件工程师的实际使用场景,让AI尝试在Cloudflare Workers中安装并运行这些包。最终结果远超预期:排除构建工具、CLI工具、仅适用于浏览器等不适用场景后,仅有15个包确实无法运行,失败率仅为1.5%。

我们还整理了内部实验结果的专属页面,详细展示各NPM包在Cloudflare Workers上的运行情况,点击即可查看完整信息。

其实OpenClaw本身对Workers的Node.js兼容性要求并不高,因为其大部分代码原本就运行在容器中。但我们之所以重点强调这一兼容性进展,核心原因在于:当开发者从零搭建全新AI助手应用时,完全可以将大量核心逻辑部署在Workers中,让服务节点更靠近用户,提升响应效率。

除此之外,Cloudflare开发者平台的产品与API生态,也为AI助手的部署提供了坚实基础。如今,任何人都能在这个平台上构建并运行各类应用——即便是什么复杂、资源需求极高的应用,都能稳定承载。而且应用一经部署,就能直接复用Cloudflare全球网络的安全保障与可扩展性能力,无需额外投入成本搭建防护和扩容体系。

具体来说,有三大核心产品模块为Moltworker的实现提供了关键支撑:

- Sandboxes(沙箱):可在隔离环境中安全运行不受信任的代码,为OpenClaw的核心运行提供了安全的环境载体;

- Browser Rendering(浏览器渲染):支持通过编程方式控制无头浏览器实例,满足OpenClaw浏览网页、执行自动化操作等需求;

- R2存储:提供稳定的对象持久化存储能力,解决了容器临时存储易丢失数据的问题。

基于这三大核心模块,我们正式启动了OpenClaw的平台适配工作,最终形成了可在Workers上运行的Moltworker方案。

深度解析:Moltworker如何适配Cloudflare平台?

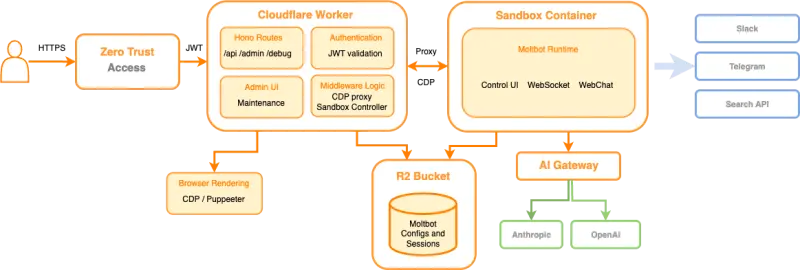

运行在Workers上的OpenClaw(即Moltworker),并非单一组件,而是一套完整的协同体系:核心包含一个入口点Worker,承担API路由、平台API与隔离环境之间的代理职责,且全程由Cloudflare Access提供安全防护;同时配套提供管理界面,连接运行标准Moltbot Gateway运行时及其集成功能的Sandbox容器,并通过R2实现数据持久化存储。

下面我们从核心模块切入,拆解整个适配流程的关键细节:

1. AI网关:简化对接,管控成本与可靠性

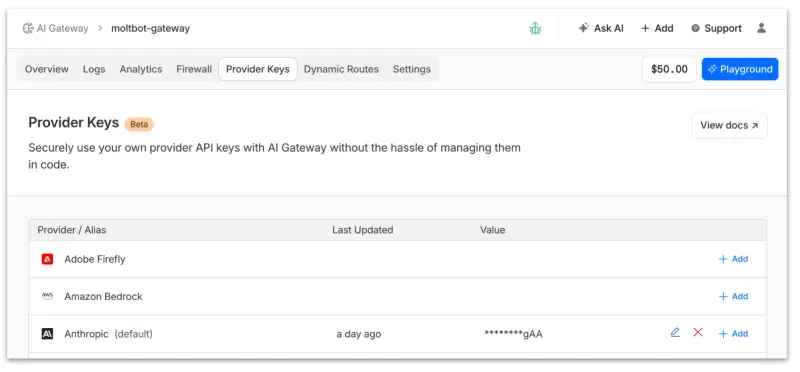

Cloudflare AI网关的核心作用,是作为AI应用与各类主流AI提供商之间的中间代理,帮助用户集中监控、管控所有通过的请求,降低多平台对接的复杂度。

近期,AI网关新增了“自带密钥”(BYOK)模式:用户无需在每次请求时以明文形式传递提供商密钥,由Cloudflare集中管理密钥,用户仅需在网关配置中调用即可,大幅提升了密钥安全性。

更便捷的是“统一计费”模式:用户完全无需端到端管理AI提供商的密钥,只需为自己的Cloudflare账户充值,即可通过AI网关直接与所有支持的AI提供商交互,费用由Cloudflare从账户余额中自动扣除,省去了多平台充值、对账的麻烦。

将OpenClaw接入AI网关的操作十分简单,全程无需修改代码:第一步,创建新的AI网关实例;第二步,启用Anthropic等目标AI提供商;第三步,添加自有密钥(如Claude密钥)或购买统一计费额度;最后,设置ANTHROPIC_BASE_URL环境变量,指定AI网关的端点地址即可。

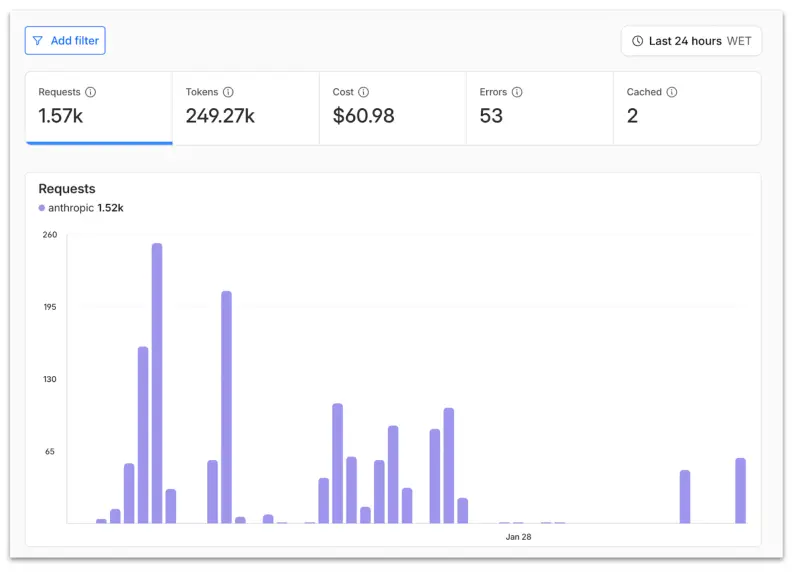

接入完成后,用户能全面掌握AI助手的使用成本,同时可通过日志和数据分析功能,清晰了解AI助手调用各提供商服务的具体情况。需要说明的是,Anthropic只是其中一个可选提供商,OpenClaw和AI网关均支持多个主流AI平台。

借助AI网关的优势,后续若有提供商推出更优模型,用户无需修改AI助手配置、重新部署,仅需在网关配置中切换模型即可;同时还能设置模型或提供商的故障转移策略,应对请求失败场景,保障AI助手的稳定运行。

2. Sandboxes:安全隔离,简化代码执行管理

早在去年,Cloudflare就预判到AI助手对“安全运行不受信任代码”的需求会持续增长,因此推出了Sandbox SDK。该SDK基于Cloudflare容器构建,提供了简洁易用的API,支持执行命令、管理文件、运行后台进程、暴露服务等核心操作,所有功能都可通过Workers应用程序触发。

对开发者而言,Sandbox SDK最大的价值在于“屏蔽复杂性”——它自动处理容器生命周期、网络配置、文件系统管理、进程调度等底层工作,开发者只需编写几行TypeScript代码,就能专注于核心应用逻辑的开发。以下是一段基础使用示例:

import { getSandbox } from '@cloudflare/sandbox';

export { Sandbox } from '@cloudflare/sandbox';

export default {

async fetch(request: Request, env: Env): Promise<Response> {

const sandbox = getSandbox(env.Sandbox, 'user-123');

// 创建项目结构

await sandbox.mkdir('/workspace/project/src', { recursive: true });

// 检查 node 版本

const version = await sandbox.exec('node -v');

// 运行一些 python 代码

const ctx = await sandbox.createCodeContext({ language: 'python' });

await sandbox.runCode('import math; radius = 5', { context: ctx });

const result = await sandbox.runCode('math.pi * radius ** 2', { context: ctx });

return Response.json({ version, result });

}

};

这一特性恰好适配OpenClaw的运行需求:我们无需在用户本地Mac mini上部署Docker,而是将Docker运行在Cloudflare Containers上,通过Sandbox SDK向隔离环境发送指令,并借助回调机制与入口点Worker建立双向通信通道,实现指令与数据的高效交互。

3. R2存储:解决容器临时存储痛点,实现数据持久化

在本地计算机或VPS上运行程序时,持久化存储通常是“默认福利”,但容器的本质是“临时存储”——一旦容器被删除,其中生成的所有数据都会丢失,这对需要保存会话记忆、对话记录的AI助手来说,无疑是致命问题。

Sandbox SDK提供的sandbox.mountBucket()方法,完美解决了这一痛点。开发者在容器启动时,可通过该方法将R2存储桶自动挂载为文件系统分区,此时容器内的指定目录就具备了持久化存储能力,即便容器被销毁,存储在该目录下的数据也不会丢失。

在Moltworker方案中,我们正是通过这种方式,为OpenClaw分配了专属的持久化存储目录,用于保存会话记忆文件、历史对话记录及其他需要长期留存的资源,确保AI助手的使用体验不受容器生命周期的影响。

4. Browser Rendering:赋能网页自动化,支撑复杂交互场景

AI助手在实际使用中,经常需要处理网页相关的任务——比如浏览结构不规则的网页、自动填写表单、截取页面快照等,这些操作都离不开浏览器环境的支持。虽然我们可以在Sandboxes上直接运行Chromium,但通过专用的Browser Rendering API,能进一步简化操作流程,降低开发成本。

Cloudflare Browser Rendering支持通过编程方式,控制边缘网络中大规模部署的无头浏览器实例,兼容Puppeteer、Stagehand、Playwright等主流开发工具,开发者只需少量代码改动,就能快速上手使用,同时还支持AI的MCP(模型控制协议)功能。

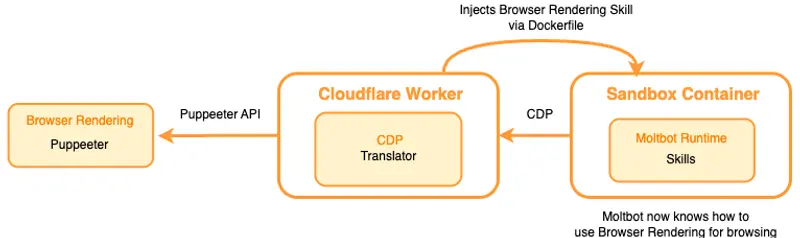

为了让Browser Rendering与OpenClaw高效协同,我们主要做了两项核心适配工作:

- 搭建精简的CDP代理(CDP是基于Chromium浏览器的调试协议),实现Sandbox容器与Moltbot Worker的连接,再通过Puppeteer API对接Browser Rendering服务;

- 在Sandbox启动时,向运行时注入专属的Browser Rendering技能,让OpenClaw能直接识别并调用浏览器相关功能。

对OpenClaw运行时而言,整个适配完成后,相当于拥有了一个本地CDP端口,可直接连接并执行各类浏览器任务,完全无需感知底层的服务对接细节。

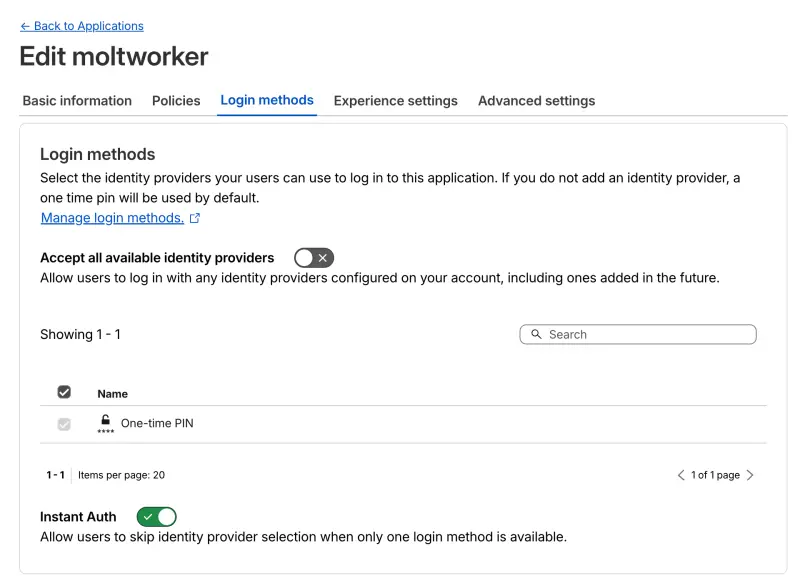

5. Zero Trust Access:筑牢安全防线,实现精细化访问管控

AI助手通常会处理用户的敏感信息,因此API和管理界面的安全防护至关重要。从零搭建一套完善的身份验证体系,不仅开发难度大,还需要持续投入精力维护,属于“重复造轮子”的低效行为。

Cloudflare Zero Trust Access(零信任访问)服务,恰好解决了这一问题。它允许开发者为每个端点定义专属的访问策略和登录方式,所有访问请求都需经过严格的身份验证,从源头阻断未经授权的访问。

当端点被Zero Trust Access保护后,Cloudflare会自动为每一个合法请求添加JWT令牌,并转发至源端点。开发者可通过验证该JWT令牌,进一步确认请求的合法性,确保请求来自Zero Trust Access,而非恶意第三方,形成双重安全防护。

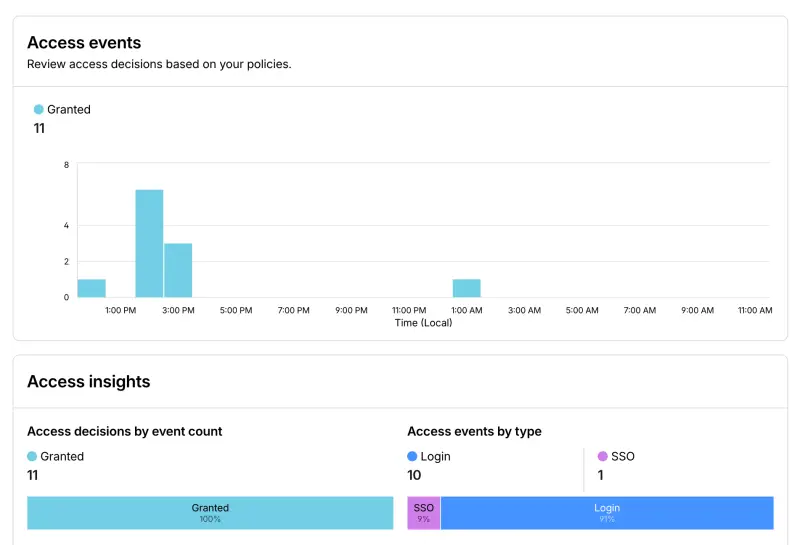

与AI网关类似,所有API接入Zero Trust Access后,用户还能清晰掌握访问日志——包括访问者身份、访问时间、操作内容等信息,实现对OpenClaw实例使用情况的精细化管控。

实战演示:Moltworker能完成哪些实际任务?

为了让大家更直观地了解Moltworker的功能,我们搭建了一个Slack测试实例,接入基于Workers运行的OpenClaw,完成了多个典型场景的测试,效果十分理想。以下是几个核心场景的演示情况:

- 路线查询与截图:在Slack中发送指令,让OpenClaw查找伦敦Cloudflare办公室与里斯本Cloudflare办公室之间的最短路线,并在频道中发送截图。OpenClaw通过Browser Rendering自动打开谷歌地图,完成路线规划和截图操作,整个流程顺畅高效;更值得一提的是,当我们第二次发送相同请求时,OpenClaw的记忆功能正常生效,直接返回了历史结果,无需重复执行操作。

- 美食推荐:发送“想吃亚洲菜”的指令后,OpenClaw快速检索周边的亚洲菜餐厅,并返回详细推荐信息,满足日常生活需求。

- 视频生成:让OpenClaw浏览Cloudflare开发者文档并生成视频。它自动下载并运行ffmpeg工具,捕获浏览器浏览文档时的帧画面,最终生成了完整的视频文件,实现了“自动化内容创作”的需求。

从演示结果来看,Moltworker完全能满足日常办公、生活中的各类AI助手使用场景,且运行稳定、响应高效,无需依赖本地专用硬件。

如何部署自己的Moltworker?

目前,我们已将Moltworker的完整实现开源,代码仓库托管在GitHub上,点击即可访问,大家今天就能基于Workers部署并运行自己的OpenClaw实例。

仓库中的README文件,详细梳理了所有必要的部署步骤,跟着操作就能完成搭建。核心前提条件有两个:一是需要一个Cloudflare账户;二是需要订阅至少5美元/月的Workers付费计划——该计划主要用于使用Sandbox Containers功能,其他核心产品如AI网关可免费使用,Browser Rendering、R2等产品则提供慷慨的免费额度,足够日常测试和使用。

需要特别说明的是,Moltworker目前属于概念验证项目,并非Cloudflare官方产品。我们发布该项目的核心目标,是展示Cloudflare开发者平台的核心能力——包括高效安全运行AI助手、隔离执行不受信任代码、依托全球网络实现高可扩展性等,为开发者提供更多构建AI应用的思路。

我们非常欢迎大家参与项目贡献,或复刻仓库进行二次开发;后续一段时间内,我们也会持续关注项目动态,为大家提供技术支持。同时,我们也在考虑向OpenClaw官方上游项目贡献包含Cloudflare技能的代码,让更多开发者受益。

Cloudflare,AI应用的理想运行平台

通过Moltworker的开发与测试,我们希望能让大家认识到:Cloudflare是运行AI应用和个人助手的理想选择。一直以来,我们都在持续探索AI开发领域的核心需求,提前布局并发布了一系列关键功能:

- Agents SDK:让开发者能在几分钟内搭建自己的第一个AI助手,大幅降低入门门槛;

- Sandboxes:无需处理容器生命周期的复杂性,就能在隔离环境中安全运行任意代码;

- AI Search:Cloudflare托管的向量搜索服务,为AI应用提供高效的内容检索能力。

如今,Cloudflare已为AI开发提供了一套完整的工具链:涵盖推理服务、存储API、数据库、有状态工作流的持久执行,以及各类内置AI功能。这些核心构建模块相互协同,让开发者能在Cloudflare全球边缘网络上,轻松构建并运行即使是最苛刻的AI应用程序。

如果您对AI技术充满热情,且希望参与下一代Cloudflare产品和API的构建,我们正在全球范围内招聘相关人才,期待您的加入!(来源)

相关文章