LM Studio 是一款广受好评的本地大模型运行工具,允许用户在 Windows、macOS 或 Linux 设备上离线运行 Llama、Gemma、GPT-OSS 等开源模型,无需依赖云服务。最新发布的 0.4.0 版本 带来了架构级重构——将核心推理引擎与图形界面彻底解耦,并引入全新的命令行工具 llmster,大幅扩展了部署灵活性。

架构升级:GUI 与核心分离,支持无头部署

此前,LM Studio 是一个一体化桌面应用。而在 0.4.0 中,团队将底层功能提取为独立的 llmster 工具(基于 llama.cpp 2.0),而桌面应用仅作为其图形前端。

这意味着:

llmster可作为守护进程独立运行,无需 GUI- 支持部署在 Linux 服务器、云实例、GPU 工作站,甚至 Google Colab

- 终端用户可通过命令行直接调用,适合自动化脚本或 CI/CD 集成

- 桌面用户仍可享受熟悉的聊天界面,体验无缝衔接

官方说明:“llmster 可以完全独立于应用程序运行,并部署在任何地方……当然,它仍然可以在没有 GUI 的本地机器上运行。”

这一变化使 LM Studio 从“桌面工具”升级为“本地 AI 基础设施”,与 Ollama 等服务器方案形成直接竞争。

核心能力增强:并发推理与 API 扩展

得益于 llama.cpp 2.0 的集成,新版本解锁关键能力:

- ✅ 同一模型支持多会话并发推理

例如:可同时运行两个基于 Llama-3 的聊天窗口,互不阻塞 - ✅ 增强的 REST API

新增端点用于在多步骤工作流中持久化对话响应 ID,便于构建复杂 Agent 系统 - ✅ 终端交互式聊天

通过lms chat命令直接启动 CLI 聊天(注意:此功能仍依赖桌面版 LM Studio,非llmster)

桌面应用体验优化

尽管架构重构,桌面端也迎来多项改进:

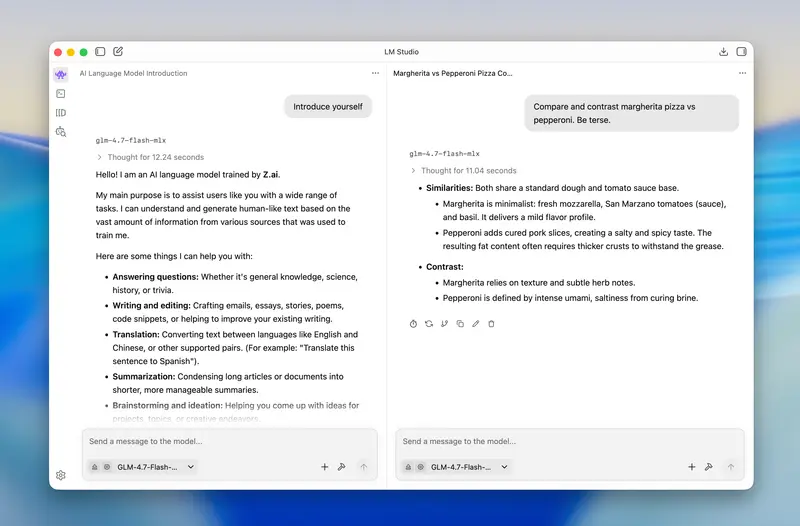

- 全新 UI 设计:更一致、更简洁,延续 ChatGPT/Gemini 的熟悉感

- 分屏模式:支持并排打开多个聊天窗口,方便对比或上下文切换

- 聊天导出:可将对话保存为 PDF、Markdown 或纯文本,便于归档或分享

这些更新进一步巩固了 LM Studio 作为“本地 ChatGPT 替代品”的定位。

为什么这很重要?

当前自托管 LLM 生态中,用户常面临选择困境:

- Ollama:轻量但功能有限,调试困难

- Text Generation WebUI:灵活但配置复杂

- vLLM / llama.cpp 原生:高性能但缺乏易用接口

LM Studio 0.4.0 试图兼顾三者优势:

- 易用性:桌面 GUI 降低入门门槛

- 灵活性:

llmster支持无头部署与脚本集成 - 性能:基于 llama.cpp 2.0,支持 GPU/NPU 加速与并发

对于希望在本地运行模型、又不愿陷入复杂配置的开发者或创作者而言,这可能是目前最平衡的选择。

快速开始

- 桌面版下载:https://lmstudio.ai(支持 Win/macOS/Linux)

llmster部署指南:详见官方公告博客(提供 Docker 与裸机安装方式)

提示:首次使用需在应用内下载模型(如

Meta-Llama-3-8B-Instruct),LM Studio 会自动调用本地 GPU/NPU 进行推理。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...