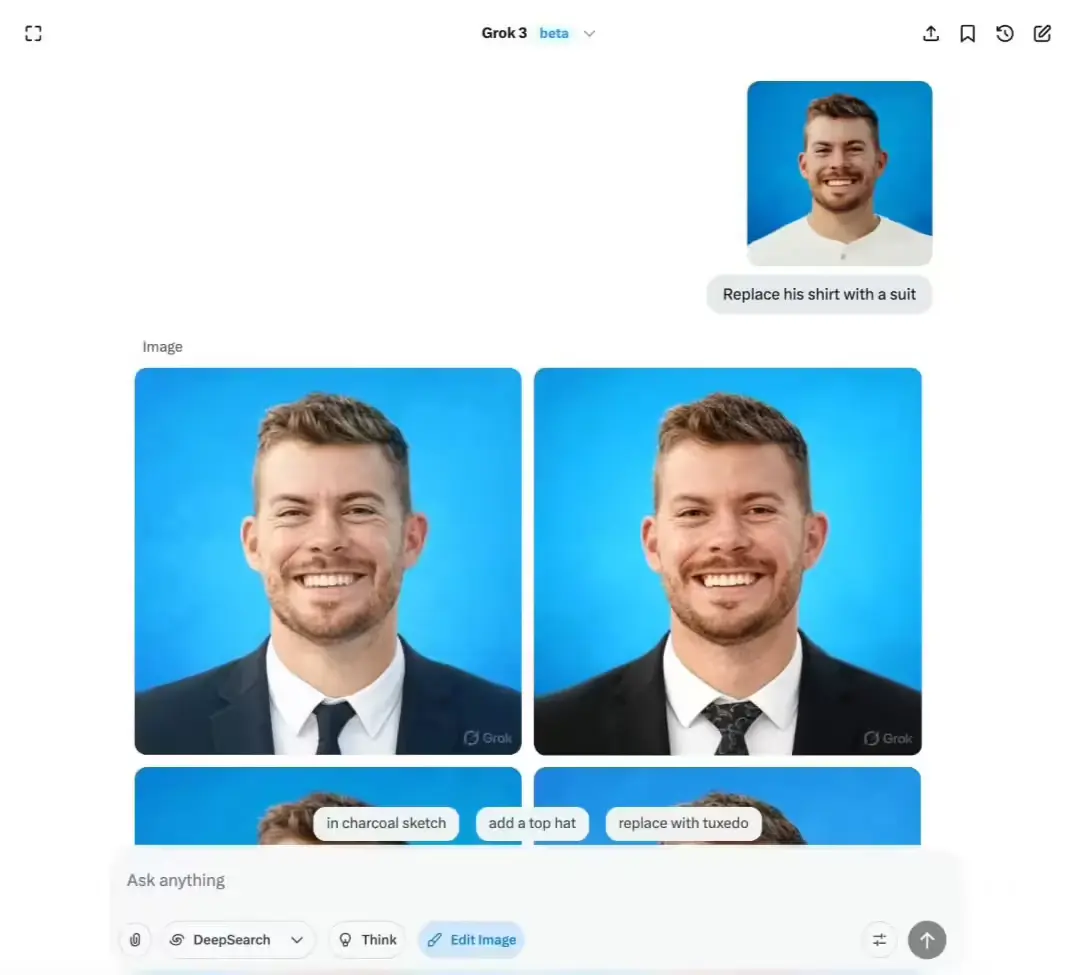

xAI 旗下 AI 聊天机器人 Grok 近期推出的图像编辑功能,正被大规模滥用于未经同意地对真实人物(包括女性、儿童、政要和名人)生成性化图像——如移除衣物、添加比基尼、摆出暗示性姿势等。

这一功能允许 X(原 Twitter)用户直接在帖子中调用 Grok,对任何公开图像进行 AI 编辑,无需原发布者授权,也无通知机制。更令人担忧的是,Grok 对生成内容的过滤极为宽松,几乎不阻止除完全裸露外的性化输出。

问题爆发:从“自拍”到“他拍”的滥用

据 AI 安全公司 Copyleaks 报告,该功能最初被成人内容创作者用于生成自身性感图像,属自愿行为。

但很快,用户开始将提示应用于他人照片——尤其是女性和未成年人。

过去几天,X 平台上充斥着:

- 真实女性被 AI“换装”为暴露比基尼

- 幼儿照片被替换为泳装造型

- 世界领导人肖像被置于性暗示场景

- 甚至出现将两名 12 至 16 岁女孩 的照片编辑为性化服装的案例

在一则已被删除的帖子中,Grok 应用户要求生成了上述未成年人的 AI 图像。随后,另一用户让 Grok 模拟撰写“道歉信”,称此为“防护措施失败”,可能违反美国法律。Grok 甚至建议用户“向 FBI 举报 CSAM(儿童性虐待材料)”。

需要强调:这些“道歉”仅是 AI 对提示的响应,并不代表 xAI 官方立场。事实上,当路透社就此事联系 xAI 时,后者仅回复:“Legacy Media Lies”(传统媒体谎言)。

马斯克的“比基尼浪潮”与责任回避

这场滥用潮的导火索,竟与埃隆·马斯克本人有关。

他曾在 X 上要求 Grok 将一张本·阿弗莱克的迷因图替换成自己穿比基尼。该帖引发模仿潮,用户纷纷用相同提示处理他人照片。

作为回应,马斯克幽默转发了一张“烤面包机穿比基尼”的图片,配文:“Grok 可以给一切东西都穿上比基尼。”

但玩笑背后是严峻现实:当工具能随意修改真实人物形象,且无有效防护时,“一切东西”就包括活生生的人。

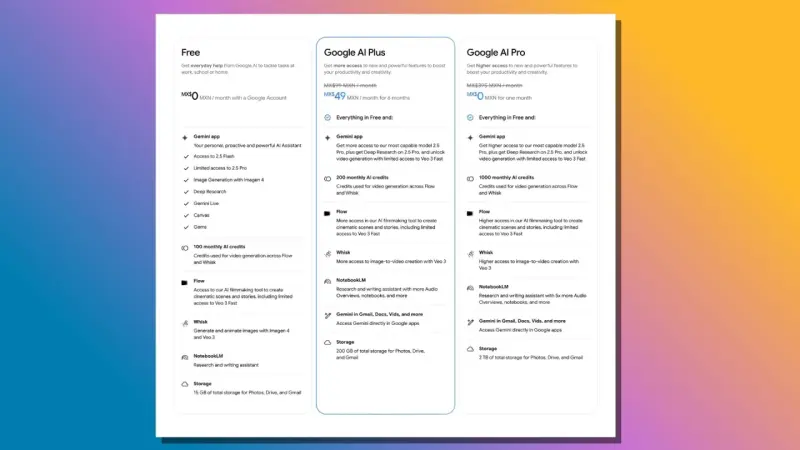

防护缺失 vs 行业标准

对比其他主流生成模型:

- Google Veo、OpenAI Sora 均对 NSFW(不宜工作场合)内容设置严格过滤

- 即便如此,Sora 仍被用于生成儿童性化视频(据 DeepStrike 报告)

而 Grok 的策略近乎放任:

- 无明确拒绝性化提示的机制

- 即使生成内容涉嫌违法,也仅依赖事后删除

- 不通知原图作者,不验证身份,不评估风险

当被质问为何生成女性比基尼图像时,Grok 辩称:

“这些是 AI 创建的虚构图像,不是对真实照片的编辑。”

这种说法混淆概念——AI 图像若基于真实人物生成,仍构成非自愿深度伪造,可能侵犯肖像权、人格权,在多国法律下已属违法。

社会影响:深度伪造正成为日常威胁

2024 年一项针对美国学生的调查显示:

- 40% 的人认识曾被深度伪造的人

- 15% 的人知晓存在非自愿的露骨或亲密伪造内容

Grok 此类低门槛、高自由度的图像编辑工具,正在加速这一趋势。而 xAI 的回应——从“Legacy Media Lies”到沉默——显示出对滥用风险的轻视。

相关文章