Perplexity正式发布 BrowseSafe-Benchmark(简称 BrowseSafe-Bench),这是一款专为浏览器AI智能体打造的安全评估基准与微调检测模型。该工具面向研究人员、浏览器开发者及网络环境中部署AI智能体的组织,聚焦提示词注入、对抗性攻击等核心安全风险,提供了全面的评估环境与防御方案,相关基准数据集与模型已公开,旨在推动浏览器AI智能体安全标准的建立。

- 模型:https://huggingface.co/perplexity-ai/browsesafe

- 数据:https://huggingface.co/datasets/perplexity-ai/browsesafe-bench

核心背景:浏览器AI智能体的安全痛点亟待解决

随着AI智能体在浏览器场景的普及,其“代用户解析网页、交互操作”的核心能力也带来了新的安全隐患:

- 网页内容中可能隐藏提示词注入攻击,诱导智能体执行未授权操作(如泄露用户信息、恶意跳转);

- 对抗性攻击手段日趋隐蔽多样,传统安全检测难以覆盖复杂网络环境中的攻击载荷;

- 缺乏统一的安全评估标准,导致不同厂商的浏览器AI智能体安全性能无法量化对比,防御措施针对性不足。

BrowseSafe-Bench 的推出,正是为了填补这一空白,为行业提供可复用、高仿真的安全评估工具,帮助开发者提前发现漏洞、强化防御能力。

核心特性:高仿真评估+高效检测,兼顾实用性与鲁棒性

1. 高保真威胁场景模拟

基准数据集通过多维度变化构建贴近真实网络环境的攻击场景,确保评估结果的实用性:

- 攻击类型全覆盖:重点包含提示词注入、对抗性误导、权限越界诱导等浏览器AI智能体高频遭遇的攻击类型;

- 注入策略多样化:模拟不同注入方式(如网页文本嵌入、链接伪装、表单隐藏字段),还原攻击的隐蔽性;

- 语言风格差异化:涵盖正式文本、口语化表达、代码片段等多种风格,适配网页内容的多样性,避免检测模型过拟合。

2. 混合专家架构检测模型

配套的检测模型采用混合专家(MoE)架构,实现“安全检测”与“浏览效率”的平衡:

- 实时性保障:针对浏览器网页加载、交互的低延迟需求优化,检测过程不影响用户浏览体验;

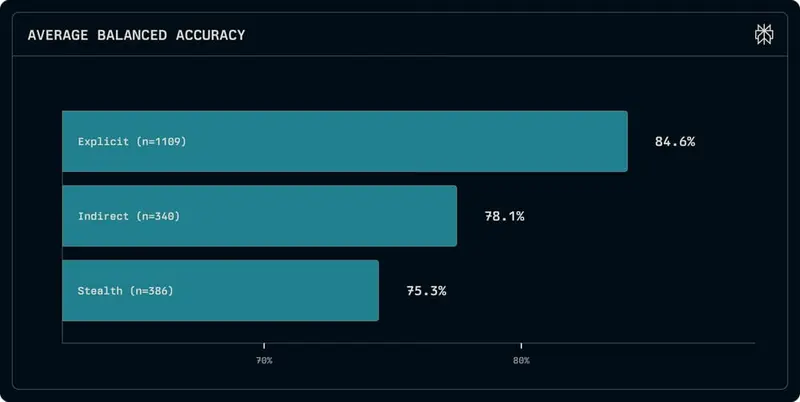

- 高检测精度:通过专家分工处理不同类型的攻击特征,在复杂场景下仍能精准识别隐蔽攻击载荷;

- 动态适配能力:支持通过标记边界案例进行动态再训练,可快速响应新出现的攻击手段,应对不断演变的威胁。

3. 纵深防御策略支撑

BrowseSafe-Bench 不仅提供评估工具,还配套了完整的防御思路:

- 异步混合检测:结合静态特征匹配与动态行为分析,多层次拦截攻击,降低漏检率;

- 开源协作机制:公开数据集与模型代码,鼓励研究社区贡献攻击样本、优化检测算法,提升整个行业的防御水平;

- 标准化评估体系:建立统一的安全性能量化指标,让不同浏览器AI智能体的安全能力可对比、可优化。

核心价值:为浏览器AI智能体安全树立行业标杆

1. 对研究人员

提供高质量、高仿真的基准数据集与检测模型基线,无需从零构建实验环境,可快速开展浏览器AI智能体安全相关研究(如攻击手法分析、防御算法优化)。

2. 对开发者

可直接使用 BrowseSafe-Bench 评估自家浏览器AI智能体的安全短板,针对性优化防御策略,降低上线后遭遇攻击的风险;动态再训练机制也能帮助产品持续适配新威胁。

3. 对行业生态

填补了浏览器AI智能体安全评估的标准空白,通过开源协作促进技术共享,推动行业从“被动防御”向“主动预判”转型,为用户提供更安全的AI浏览体验。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...