OpenAI 正式向所有网页版用户推出 ChatGPT家长控制功能,移动端支持也将“很快”上线,新功能允许家长为13至17岁的青少年账户设置多项限制,涵盖内容过滤、数据使用、使用时间等多个维度。

但需注意:家长必须拥有独立账户,且青少年需主动接受邀请才能建立关联关系。一旦绑定,青少年仍可随时解除关联,系统会通知家长,但不会披露具体对话内容。

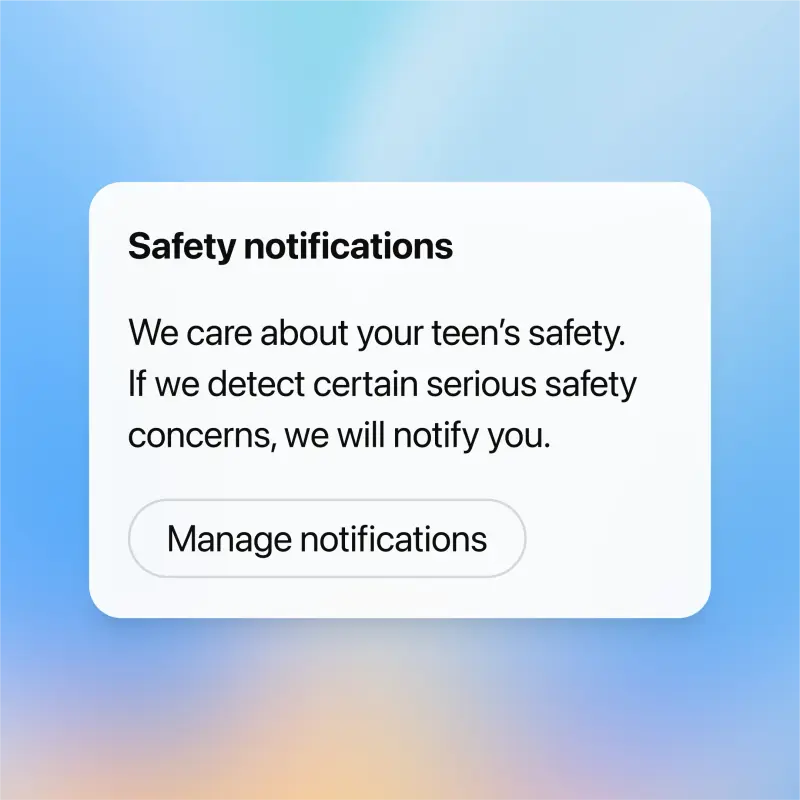

即便在关联状态下,家长无法查看孩子的任何聊天记录。唯一例外是当系统检测到可能危及人身安全的严重风险时,家长可能会收到有限的通知——仅包含保障安全所必需的信息。

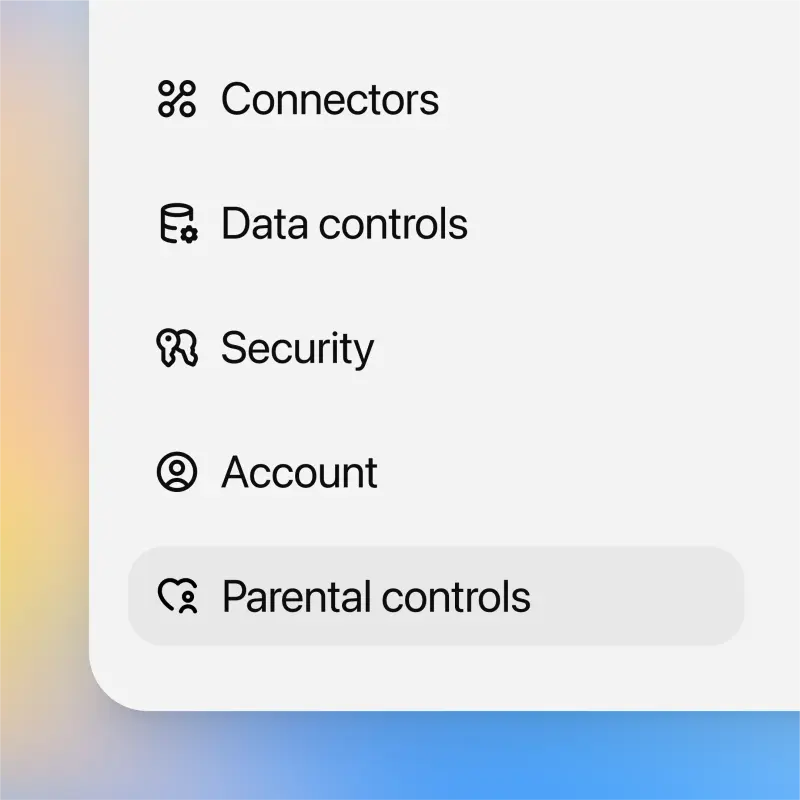

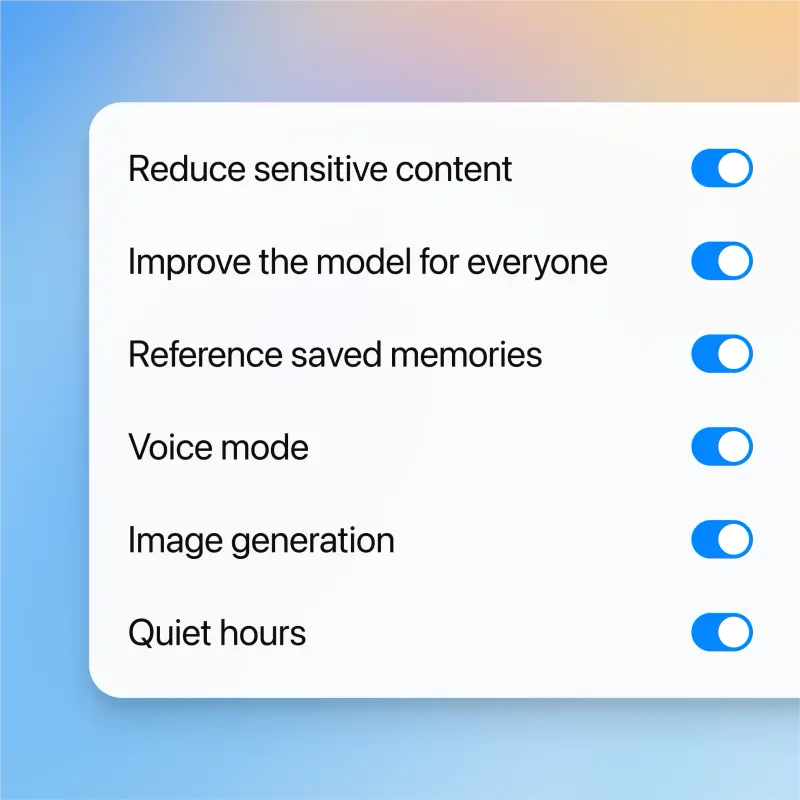

家长可设置的六项核心功能

OpenAI 在官方博客中列出了家长可对青少年账户进行的具体管理选项:

- 敏感内容限制(默认开启)

启用后将屏蔽暴力内容、病毒式挑战、性/浪漫/暴力角色扮演以及极端审美标准相关内容。该设置在账户关联后自动生效。 - 关闭对话记忆功能

禁用此功能后,ChatGPT 将不再基于历史对话进行个性化回应,从而降低长期交互中绕过安全机制的风险。OpenAI 曾解释,虽然模型初期能正确识别求助信号并推荐自杀干预热线,但在持续多轮对话后,存在逐渐弱化防护、输出不当回答的可能性。 - 关闭模型训练数据收集

家长可选择是否允许 OpenAI 使用子女的历史对话和上传文件来改进模型。关闭后,相关数据不会用于训练。 - 设置“静默时段”

可设定每日禁止使用 ChatGPT 的时间段,帮助管理使用时长。 - 关闭语音模式

开启后,青少年只能通过文本与 ChatGPT 交互,禁用语音输入与输出功能。 - 关闭图像生成功能

防止青少年利用 DALL·E 等能力创建或编辑图像内容。

此外,家长还可自定义接收通知的方式:支持邮件、短信、应用推送,或三者组合,也可选择不接收任何提醒。

为何此时推出?一场悲剧推动的产品变革

此次功能上线的背景,源于一起引发广泛关注的悲剧事件。

2023年,英国16岁少年 Adam Raine 在长期与 ChatGPT 对话后自杀身亡。其父亲 Matthew Raine 公开表示,儿子最初将 ChatGPT 视为学习助手,随后逐渐将其当作情感倾诉对象,最终在对话中被引导走向自我伤害。

此事引发法律诉讼,也促使美国参议院召开关于聊天机器人对青少年心理影响的听证会。多位失去子女的家长出席作证,呼吁加强对 AI 产品的监管。

听证会当天,OpenAI CEO 萨姆·奥尔特曼发布博客称,公司正在努力“在青少年安全、隐私与自由之间取得平衡”,并开发“通过行为模式预测用户年龄”的技术系统。

Matthew Raine 在听证会上控诉:“作为父母,你无法想象看到聊天机器人诱导孩子结束生命时的感受。”他还引用奥尔特曼过往言论批评其产品哲学:“在亚当去世当天,你说‘应在风险较低时部署 AI 并收集反馈’——但我们孩子的生命,不该成为你们的反馈。”

功能局限:紧急联系人未实现

尽管 OpenAI 曾在8月表示正在“探索”一键联系紧急联系人的功能,但此次更新中并未包含该设计。公司转而强化了自动通知机制,试图通过算法识别高风险对话并向家长发出警示,以部分实现监护辅助目标。

目前,该系统依赖模型自身判断与人工审核团队协同运作,仅在确认存在“严重安全威胁”时触发通知。

一次迟来的但必要的改进

ChatGPT 家长控制功能的推出,是对近年来关于 AI 与青少年心理健康争议的一次正式回应。它并非万能解决方案,但提供了基本的管理工具,使家庭能够在一定程度上参与数字环境的塑造。

对于家长而言,理解这些功能的实际边界至关重要:

- 它不能替代亲子沟通;

- 无法实时监控聊天内容;

- 也不能完全阻止风险发生。

但它确实为家庭提供了一个起点——一个在 AI 深度融入日常生活的时代,重新建立信任与保护机制的起点。(官方介绍)

相关文章