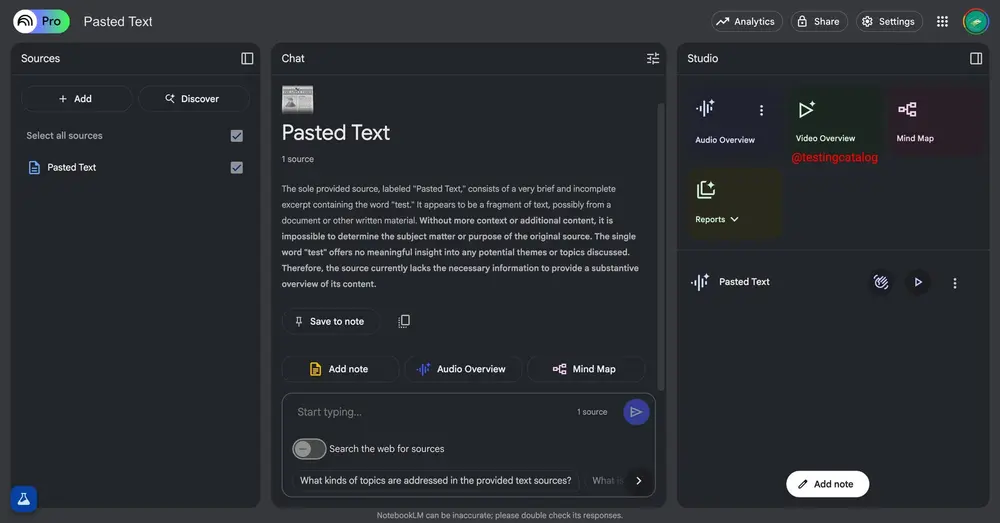

谷歌已在美国正式推出 Search Live 功能,标志着其从传统文本搜索迈向实时、多模态交互的重要一步。该功能现已对所有用户开放,无需加入 Google Labs 或额外启用,通过谷歌应用或 Lens 即可直接使用。

什么是 Search Live?

Search Live 是一种基于 AI 的实时对话式搜索体验。你不再需要手动输入问题,而是可以直接用语音与谷歌助手对话,并结合手机摄像头展示当前场景,获取即时反馈。

它支持两种主要访问方式:

- 在 Google App(Android/iOS)中,点击搜索栏下方的“Live”按钮;

- 在 Google Lens 应用中,底部新增“Live”模式入口,进入后摄像头自动启动,对话随即开始。

这一功能融合了语音识别、计算机视觉与大模型理解能力,实现“边看边问”的自然交互。

多模态交互:让搜索发生在行动中

Search Live 的核心突破在于打破了传统搜索的输入限制,构建了一种更贴近真实人类行为的查询方式——你可以一边操作、一边提问。

例如:

- 准备抹茶饮品时,将摄像头对准工具,询问“这个茶筅怎么用?”或“有没有低糖替代配料?”

- 设置家庭影院设备时,拍摄接线区域,提问“HDMI 线应该插在哪?”

- 化学实验过程中,实时询问反应原理或安全注意事项

这类场景下,Search Live 能根据视觉上下文提供更具针对性的信息,提升信息获取效率。

典型应用场景

谷歌重点推荐以下几类使用场景:

- 设备调试与故障排查

面对复杂的接线、说明书缺失的电器,用户可通过摄像头引导 AI 分析物理连接状态,获得基础配置建议。 - 学习辅助

学生在做科学实验或手工项目时,可让 AI 实时解释现象原理、推荐拓展资源,作为探索性学习的补充工具。 - 生活指导

厨房烹饪、家居维修、园艺种植等场景中,实现“所见即所询”,减少频繁切换设备查资料的操作。

使用提示与边界说明

尽管功能新颖,但需注意:

- 当前 Search Live 仍处于早期推广阶段,回答准确性依赖于模型训练数据和场景识别能力;

- 对涉及人身安全、专业维修、高精度计算的任务(如电路改造、数学证明),建议以官方文档或专业人士意见为准;

- 所有对话均遵循谷歌的隐私政策,视频流不会被存储,仅用于实时分析。

从 Labs 到全民可用:一次重要跃迁

Search Live 最初作为 Google Labs 中的实验性功能上线,仅限部分测试用户使用。此次全面开放,意味着谷歌已完成初步稳定性验证,并开始推动该模式成为主流搜索体验的一部分。

虽然它本质上仍是“一个能说话、能看图的谷歌搜索”,但其交互范式的改变值得关注——未来,搜索可能不再始于关键词,而是始于一次对话、一个画面。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...