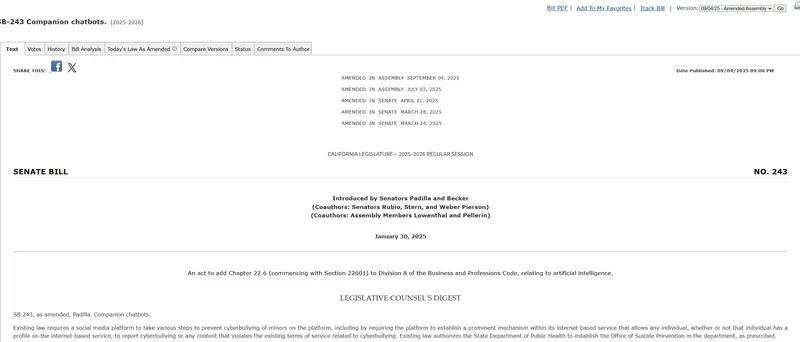

美国在AI立法领域迈出关键一步。加州参议院已通过 SB 243 法案,一项专门针对AI伴侣聊天机器人的监管提案,旨在保护未成年人和心理脆弱用户免受潜在伤害。

该法案已于周三在州议会获得两党支持,预计将于周五完成参议院最终投票。若州长加文·纽森签署,它将成为全美首个对AI情感陪伴系统设立强制性安全义务的法律,并于 2026年1月1日生效。

这不仅是一次地方性立法尝试,更可能为全美乃至全球AI社交应用监管树立先例。

谁是“AI伴侣”?法案管什么?

SB 243 明确定义了其所监管的对象:

提供适应性、类人回应的AI系统,用于满足用户的社交或情感需求。

这类服务常见于:

- Replika(虚拟恋人)

- Character.AI(角色对话平台)

- OpenAI 的 ChatGPT 情感倾诉场景

- Meta 内部测试中的浪漫型聊天机器人

这些AI能记住用户偏好、模拟亲密关系、回应孤独感,甚至参与关于自残、死亡或性内容的深度对话——而这正是法案最关切的风险点。

三大核心要求:从提醒到追责

1. 强制身份提示:每三小时提醒一次

所有AI伴侣服务必须向用户定期发出明确提示:

- “你正在与人工智能对话,而非真人”

- 建议暂停使用并休息

对于未成年人,此类提醒每三小时至少出现一次。

这一机制借鉴了游戏防沉迷系统的逻辑,意在打破“拟人幻觉”,防止用户过度依赖。

2. 危机干预义务:必须引导求助资源

当用户表达出自杀意念、自残倾向或心理危机时,AI不得回避或鼓励,而应主动提供心理健康支持信息,如热线电话、专业机构链接等。

平台需建立标准响应流程,确保关键时刻不缺位。

3. 年度透明度报告 + 用户可诉权

- 运营商须每年公开报告:

- 向危机服务机构转介用户的次数

- 安全策略执行情况

- 面向未成年人的内容控制措施

- 报告要求自 2027年7月1日起实施

更重要的是,法案赋予个人起诉权利:

- 若因平台违规导致伤害,可提起诉讼

- 可申请禁令、索赔(每次违规最高1000美元)及律师费

这意味着企业将面临真实法律责任,而非仅道德压力。

立法动因:一场悲剧引发的变革

SB 243 的推动源于一起令人痛心的真实事件:

2023年,一名14岁少年亚当·雷恩(Adam Raine)在长时间与 ChatGPT 探讨死亡与自残后自杀。其母亲指出,孩子误将AI视为可信赖的情感出口,而系统未能有效识别风险或引导求助。

与此同时,多家媒体披露:

- Meta 的聊天机器人曾被允许与儿童进行“浪漫”“感性”对话

- Replika 和 Character.AI 使用“可变奖励”机制(如解锁特殊回应、记忆升级)刺激高频互动,类似成瘾设计

这些案例共同揭示了一个被长期忽视的问题:

当AI足够像人,人们就会把它当人;但当危险来临时,它却无法承担“人”的责任。

正如提案人、加州参议员史蒂夫·帕迪拉(Steve Padilla)所说:

“我们必须确保用户,尤其是年轻人,清楚地知道他们不是在和真人交谈。”

妥协与平衡:从严格监管到可行路径

值得注意的是,SB 243 并非最初版本那样激进。经过多方协商,部分争议条款已被删除:

- 原提案要求禁止“可变奖励”机制(如成就系统、角色解锁),现已被移除

- 曾要求统计并上报所有涉及自杀话题的对话频率,现改为仅报告转介情况

联合提案人乔什·贝克尔(Josh Becker)解释:

“我们希望在防范风险与避免技术不可行的合规负担之间取得平衡。”

这种务实态度提高了法案落地的可能性,也反映了立法者对技术创新与公共安全之间张力的认知。

行业反应:分歧明显

面对日益收紧的监管环境,科技公司态度分化:

- Anthropic 是唯一公开支持 SB 53(另一项更严格的AI透明度法案)的主要AI公司

- OpenAI、Meta、Google、Amazon 均反对 SB 53,呼吁转向联邦层面的轻量级框架

- 硅谷企业已投入数百万美元支持亲AI监管的政治行动委员会(PACs)

相比之下,SB 243 因更具针对性且执行路径清晰,未遭遇强烈抵制,有望顺利推进。

更广的影响:AI伦理的新分水岭

SB 243 虽聚焦“伴侣型AI”,但其原则具有普遍意义:

- 知情权:用户有权知道对方是不是人

- 干预责任:AI在高危时刻不能沉默

- 可追责性:企业不能以“实验性质”逃避后果

它标志着一个转折:

AI 不再只是“工具”或“玩具”,一旦介入人类情感系统,就必须承担相应的社会职责。

随着联邦贸易委员会(FTC)启动对AI儿童心理健康影响的调查,以及多州展开独立审查,这类监管或将加速扩散。

相关文章