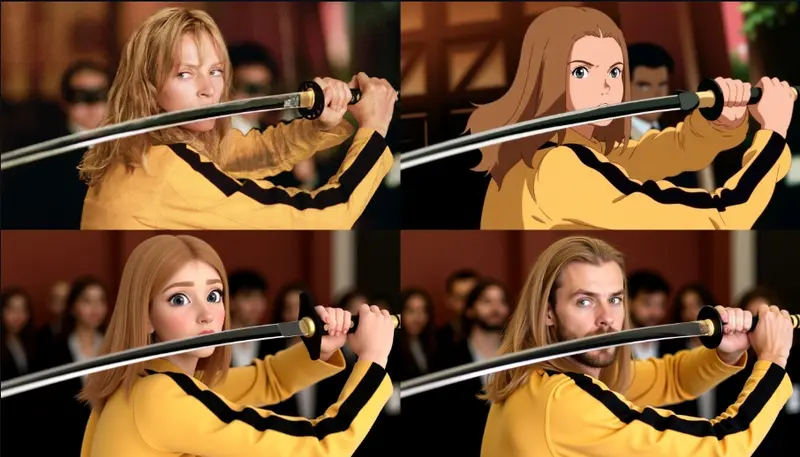

Radial Attention 在长视频生成中展现出显著的效率优势(最高 3.7 倍推理加速,支持 4 倍长度扩展),开发者社区迅速跟进。

ComfyUI-RadialAttn 正是这样一个项目——它将 Radial Attention 机制无缝集成到 ComfyUI 原生工作流中,使用户无需依赖特定封装器,即可在标准节点环境中启用这一高效注意力结构。

适用场景与支持模型

该插件专为使用 Wan 2.1 和 Wan 2.2 14B 模型的用户设计,支持:

- ✅ 文本到视频(T2V)

- ✅ 图像到视频(I2V)

适用于希望在 原生 ComfyUI 工作流中启用 Radial Attention 的用户。

⚠️ 注意:如果你使用的是 kijai 的 ComfyUI-WanVideoWrapper,建议直接使用其内置的

WanVideoSetRadialAttention节点,无需额外安装此插件(但仍需安装相关依赖)。

安装步骤(Windows 用户)

以下为 Windows 平台完整安装流程,Linux 用户可跳过 wheel 安装部分,自行编译或适配。

1. 安装依赖包

请依次安装以下 Python 包:

# 安装 Triton(Windows)

pip install triton-windows

# 安装注意力相关组件

pip install SageAttention

pip install SpargeAttention

# 安装 FlashInfer(仅支持 PyTorch 2.6)

pip install flashinfer-windows

⚠️ 若你使用其他 PyTorch 版本(如 2.4/2.5),可跳过完整依赖安装,仅运行:

pip install --no-deps .\flashinfer_python-0.2.8-cp39-abi3-win_amd64.whl

2. 安装通用依赖

pip install cuda-python einops ninja numpy pynvml requests

3. 安装插件

将项目克隆至 ComfyUI 的自定义节点目录:

git clone https://github.com/first-intelligence/ComfyUI-RadialAttn.git

# 移动到 custom_nodes 目录

mv ComfyUI-RadialAttn /path/to/ComfyUI/custom_nodes/

重启 ComfyUI,即可在节点列表中看到 PatchRadialAttn 节点。

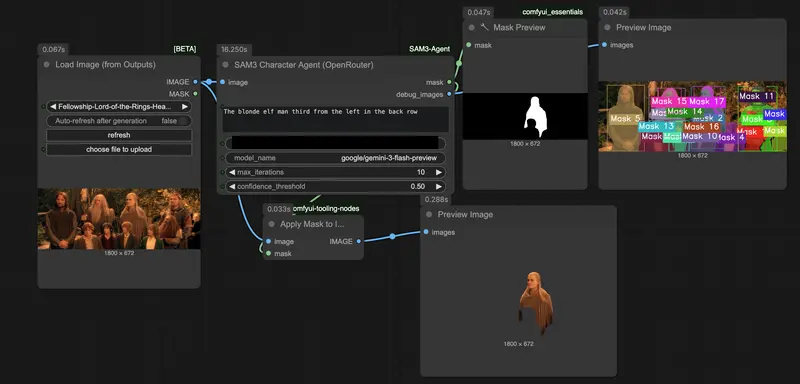

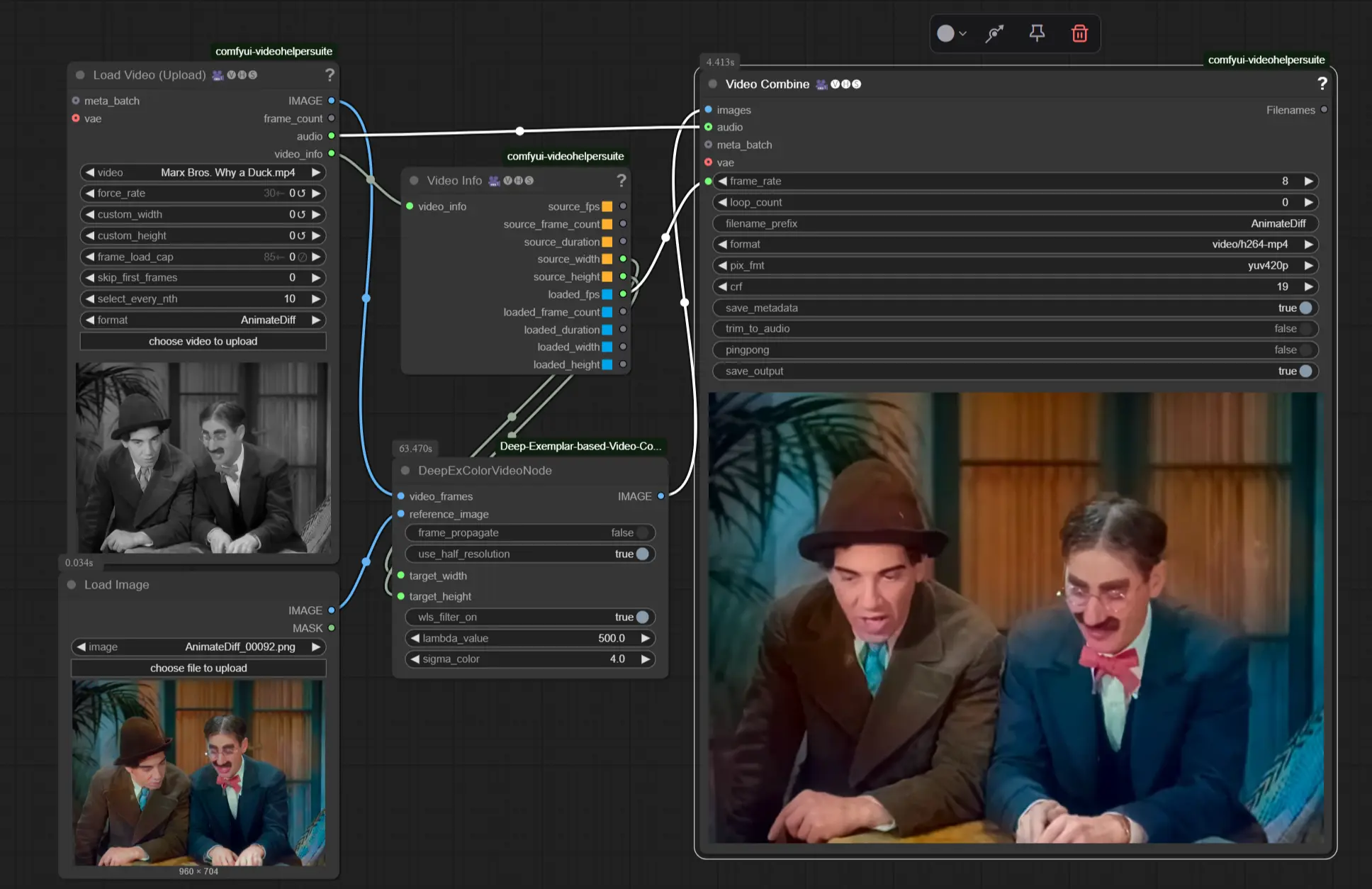

使用方法

使用方式极为简单:

- 在工作流中加载 Wan 2.1/2.2 14B 模型

- 将模型输出连接至 PatchRadialAttn 节点

- 后续接常规采样器、提示词、VAE 等节点即可

📌 项目提供了一个示例工作流,涵盖:

- Wan 2.2 14B I2V

- GGUF 编码器

- LightX2V LoRA 加速

- Radial Attention +

torch.compile优化

适合直接参考或迁移使用。

性能优化建议

根据实测反馈,以下设置有助于在保持效率的同时提升生成质量:

- ✅ 跳过第一层和第一个时间步的稀疏化

在PatchRadialAttn节点中设置:dense_block = 1(前1个 block 使用稠密注意力)dense_timestep = 1(第一个 timestep 不稀疏)

这有助于保留初始结构信息,避免早期去噪阶段失真。

关键限制:视频令牌数量必须被 128 整除

Radial Attention 对输入尺寸有特定要求:

视频令牌总数必须能被 128 整除

例如:

- 768×448 分辨率,69 帧视频:

❗ 常见误解:认为“宽高必须被128整除”——这是错误的。真正需要整除的是最终的 token 数量,而非原始分辨率。

建议在构建工作流前,先通过公式验证输入参数是否合规。

为什么选择这个插件?

| 优势 | 说明 |

|---|---|

| 原生集成 | 无需修改模型加载逻辑,兼容标准 ComfyUI 流程 |

| 易于启用 | 一个节点即可打补丁,支持 LoRA 叠加 |

| 高效运行 | 结合 torch.compile 与 LightX2V LoRA,进一步提升速度 |

| 社区维护 | 持续更新,适配 SageAttention v1/v2 等新特性 |

相关文章