在视频生成领域,我们正见证一场静默但深刻的变革。随着文本到视频扩散模型的质量不断提升,其输出已接近专业制作水平。然而,如何实现对视频生成过程的精确控制——例如根据特定图像或短片引导视频风格、动作或构图——仍然是一个挑战。

韩国科学技术院推出TIC-FT(Temporal In-Context Fine-Tuning,时间上下文微调)。它提供了一种高效且灵活的方式,用于调整预训练视频扩散模型,以适应多种条件生成任务,而无需修改模型架构或依赖大量训练数据。

TIC-FT 是什么?

TIC-FT 的核心思想非常直观:在时间维度上拼接条件帧和目标帧,并插入噪声逐渐增加的缓冲帧,从而实现从输入条件到生成视频之间的平滑过渡。

这种方法不仅保持了视频的时间连贯性,还确保了生成结果与原始条件的高度一致性。更重要的是,它仅需少量样本(通常 10–30 个)即可完成微调,极大降低了使用门槛。

为什么选择 TIC-FT?

传统方法如 ControlNet 和 IP-Adapter 虽然在图像生成中表现良好,但在视频任务中却面临诸多限制:

- 需要额外编码器或复杂架构

- 输入条件必须与目标长度一致,常通过重复帧“强行适配”

- 易丢失细粒度信息,导致输出偏离预期

相比之下,TIC-FT 完全基于现有视频扩散模型架构进行微调,无需引入外部组件。它支持任意长度的条件输入,并在推理阶段自动处理帧数不匹配的问题,显著提升了灵活性与效率。

技术亮点解析

1. 时间上下文拼接机制

TIC-FT 沿时间轴将条件帧(如一张图片或一段短视频)与目标帧拼接,并在中间插入噪声逐步增强的缓冲帧。这些缓冲帧起到了桥梁作用,使模型能够自然地从输入条件过渡到生成内容。

这种设计不仅避免了突兀的切换,还让模型更好地理解时间动态,提升生成质量。

2. 无需重新训练,轻量级微调

TIC-FT 不需要对整个模型进行再训练,而是通过小规模数据集上的局部微调来调整模型行为。实验表明,在仅 20 个样本、单块 H100 GPU 上训练 6,000 步的情况下,TIC-FT 即可超越多个基线方法。

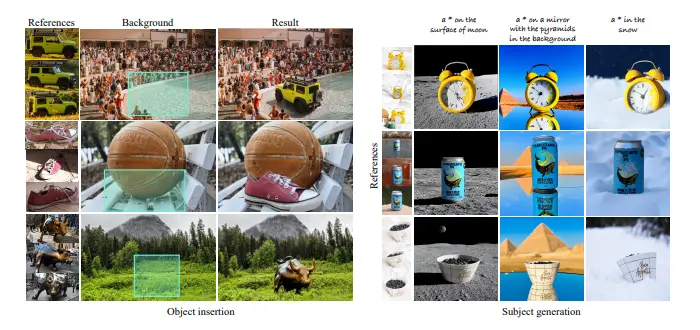

3. 支持多种视频生成任务

TIC-FT 已成功应用于以下场景:

- 图像到视频(I2V):如静态物体转动态序列、角色动画生成

- 视频到视频(V2V):如真实视频转换为卡通风格、虚拟试穿等

- 动作迁移:基于参考动作生成新角色的动作序列

实验验证:性能全面领先

研究人员在多个大规模视频扩散模型上测试了 TIC-FT 的表现,包括 CogVideoX-5B 和 Wan-14B。评估指标涵盖:

- 视觉质量:CLIP-I、LPIPS

- 时间连贯性:VBench

- 语义一致性:GPT-4o 打分

结果显示,TIC-FT 在多项任务中均优于现有方法,尤其在条件保真度方面表现突出。即使在零样本设置下,TIC-FT 也能利用模型预训练能力生成合理结果,展现了良好的泛化能力。

效率优势:低资源友好型方案

TIC-FT 最引人注目的特点之一是它的高效率。实验表明,仅需 2,000 步训练即可达到高质量输出,远低于其他方法所需的优化轮次。这意味着即使是计算资源有限的研究者或创作者,也可以轻松使用 TIC-FT 实现个性化视频创作。

局限与展望

尽管 TIC-FT 表现优异,但也存在一些局限:

- 当前受限于显存容量,条件输入时长被限制在 10 秒以内

- 对极复杂场景(如大规模视角变化)仍可能产生偏差

未来的工作将致力于扩展其时间处理能力,并进一步提升对多样条件的适应性。

相关文章