在 AI 领域,硬件常是聚光灯下的主角,但真正决定落地效果的,往往是软件栈——从驱动、内核到推理框架和调度策略。然而,大多数基准测试仍聚焦于芯片本身,忽视了软件演进对实际性能的持续影响。

为填补这一空白,SemiAnalysis 推出了开源项目 InferenceMax(Apache 2.0 许可),一个每晚自动运行的 AI 推理基准测试套件,专门衡量真实世界推理场景中软硬件组合的效率,并以 总拥有成本(TCO) 为核心指标。

为什么需要 InferenceMax?

当前主流基准测试多为“快照式”——在某一时间点测试固定版本,无法反映软件每日迭代带来的性能变化。而 InferenceMax 采用滚动发布模式,每晚使用最新版推理框架(如 vLLM、SGLang、TensorRT-LLM 等)和驱动,持续追踪性能演进。

更重要的是,它不只看“每秒生成多少 token”,而是回答一个更关键的问题:每百万 token 花多少钱?

核心指标:吞吐量、交互性与 TCO 的平衡

InferenceMax 关注两个关键维度:

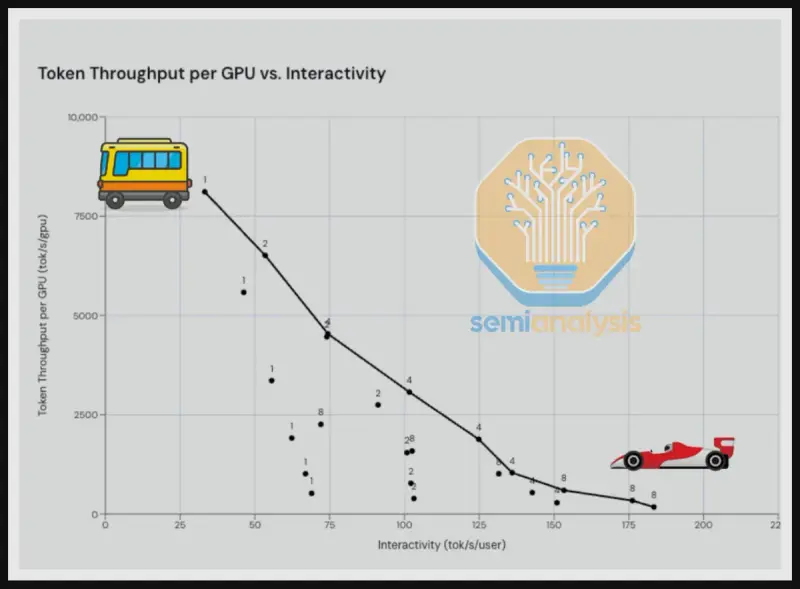

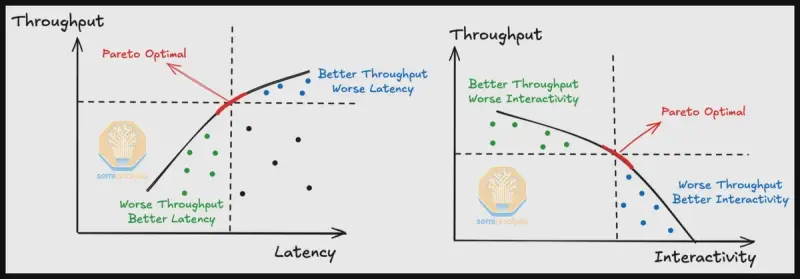

- 吞吐量(Throughput):以 token/s/GPU 衡量,反映 GPU 利用率。通过批量处理多个请求可最大化吞吐,适合后台任务。

- 交互性(Interactivity):以 token/s/user 衡量,决定单个用户(如聊天机器人)的响应速度。

二者存在天然权衡:高吞吐常导致响应“卡顿”,高交互性则牺牲整体效率。理想配置位于 Pareto 前沿——在给定成本下,找到吞吐与交互的最佳平衡点。

而最终决策依据是 TCO(Total Cost of Ownership),即:

每百万 token 的美元成本

=(GPU 购置/租赁成本 + 电力 + 运维) ÷ 生成的 token 总量

这意味着,最快的 GPU 不一定最划算。例如,InferenceMax 数据显示,AMD 的 MI355X 在某些场景下的 TCO 可与 Nvidia 的 B200 相当,尽管后者峰值性能更高。

覆盖硬件与软件栈

目前 InferenceMax 1.0 支持:

- 英伟达:H100、H200、B200、GB200、NVL72

- AMD:MI300X、MI325X、MI355X

未来数月将加入 Google TPU 和 AWS Trainium。

基准测试在 GitHub Actions 上每晚自动运行,使用厂商提供的“真实世界配置”——因为同一硬件可通过数千种参数组合调优,仅测默认设置无实际意义。

推动软件生态改进

InferenceMax 已促成多项实际优化:

- 在 AMD ROCm 中发现并协助修复多个性能 bug,推动补丁落地;

- 指出 ROCm 默认配置过于复杂,建议简化以降低用户调优门槛;

- 在 Nvidia Blackwell 驱动早期版本中发现实例启停时的初始化问题。

项目团队感谢 英伟达、AMD 及多家云厂商的工程师深度协作,部分人员甚至通宵调试。这反映出 AI 软件栈仍处高速迭代期,基准测试本身已成为推动生态成熟的重要工具。

对开发者与企业的价值

- 选型参考:不再仅看“谁跑得快”,而是“谁更省钱”;

- 版本追踪:监控框架更新是否真正带来性能提升;

- 风险预警:及时发现新驱动或库引入的性能退化。

对于任何部署 LLM 推理服务的团队,InferenceMax 提供了一个动态、真实、成本导向的评估视角。

数据统计

相关导航

Music Arena

MagicArena

CodeArena

WildScore

Game Arena

AITradeGame

VAE Comparison Tool