如果你正在寻找一个真正开源、可定制、且支持多规模模型切换的AI聊天机器人,现在有了新选择。

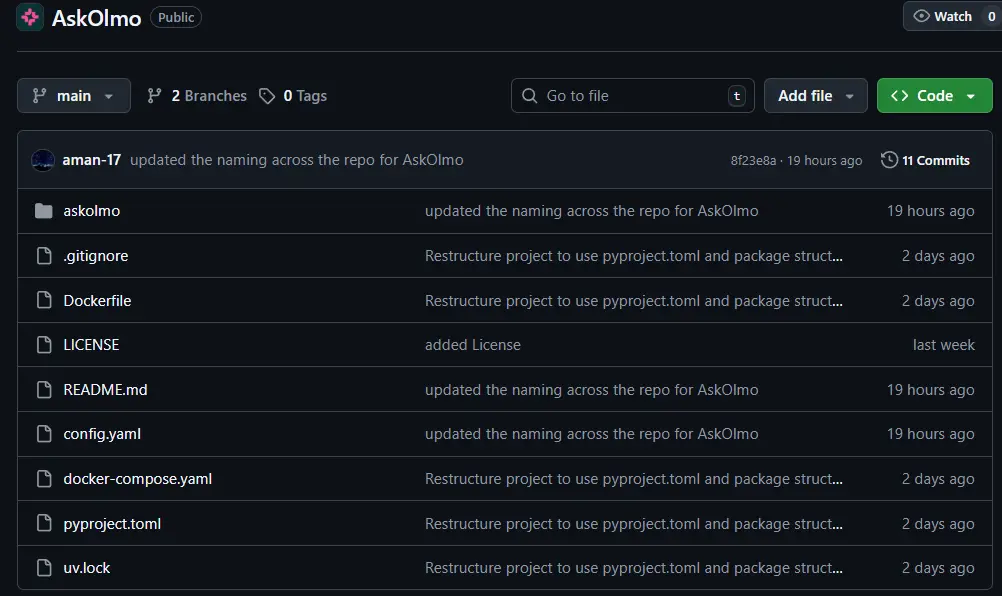

由 Allen Institute for AI(AI2)推出的 OLMo 系列语言模型,正逐步构建从训练数据到推理部署的全栈开源生态。作为这一理念的延伸,AI2推出了 AskOlmo ——一款专为 Discord 设计的机器人,将 OLMo 模型的能力直接带入群组对话场景。

它不是简单的聊天插件,而是一个面向研究者、开发者和开源社区的交互式实验平台,支持会话管理、内容审核、文件解析和多模型切换,旨在推动开放语言模型在真实社交环境中的应用探索。

核心功能:不只是“@一下就能聊”

AskOlmo 的设计目标是:让 OLMo 在真实对话中可用、可控、可扩展。

1. 基于回复的会话系统

无需命令前缀,只需:

@AskOlmo 开始提问- 回复它的回答继续对话

- 他人也可加入同一对话链

支持无限分支、跨用户续聊,天然适配 Discord 的消息结构。

示例:

用户A:@AskOlmo 解释一下扩散模型的基本原理

AskOlmo:……(回复)

用户B:@AskOlmo 那它和自回归模型有什么区别?

→ 自动继承上下文,无需重复问题背景

2. 支持多种 OLMo 模型动态切换

通过 /model 命令可在不同参数规模的指令调优模型间自由切换:

| 模型名称 | 参数量 | 特点 |

|---|---|---|

| OLMo-2-1124-13B-Instruct | 130亿 | 平衡性能与速度 |

| OLMo-2-0325-32B-Instruct | 320亿 | 当前最大版本,强推理能力 |

| OLMo-2-1124-7B-Instruct | 70亿 | 轻量高效,响应快 |

| OLMo-2-0425-1B-Instruct | 10亿 | 最小模型,延迟最低 |

所有模型均通过 Cirrascale 提供的端点服务运行,保障稳定访问。

面向生产环境的高级特性

AskOlmo 不止于“能用”,更注重“好用”。

✅ 流式响应 + 视觉反馈

消息逐字输出,附带动画指示器,模拟自然打字体验。

✅ 会话记忆与自动清理

- 智能维护对话树结构,支持多线程并行交流;

- 自动回收过期节点,防止内存泄漏。

✅ 内容安全审核(可选)

集成 Google Cloud Content Safety API,可检测有害内容,适用于公开服务器。

✅ 文件理解能力

支持上传 .txt, .py, .c, .md 等文本文件,机器人可读取内容并参与讨论。

场景示例:上传一段 Python 脚本 → @AskOlmo “这段代码哪里可以优化?”

✅ 可配置系统提示

管理员可自定义机器人的“性格”或角色设定,例如:

- 学术助手模式

- 编程导师模式

- 极简回答模式

✅ 权限控制系统

支持细粒度权限管理:

- 按用户/角色限制使用频率

- 按频道启用或禁用机器人

- 设置每小时消息上限(默认 20 条/用户)

还可限制机器人仅在特定服务器中运行,便于私有化部署。

如何部署?

AskOlmo 是一个开源项目,适合有一定技术基础的团队自行搭建。

先决条件

- Python 3.10 或更高版本

- Discord 开发者应用 Token

- AI2 提供的 OLMo API 访问权限

- (可选)Google Cloud API 密钥(用于内容审核)

部署步骤概览

- 克隆项目仓库

- 配置环境变量(Token、API密钥等)

- 安装依赖库

- 启动机器人进程

- 在 Discord 中授权添加至服务器

完整文档已在 GitHub 提供,包含 Docker 部署示例和调试指南。

为什么值得关注?

在闭源模型主导聊天机器人的当下,AskOlmo 的意义在于:

🔹 完全基于开源模型:不依赖 GPT 或其他专有系统

🔹 透明可控:从提示词到权限,每一层都可审计与修改

🔹 教育与研究友好:可用于教学演示、AI行为分析、人机协作实验

🔹 推动 OLMo 生态落地:让社区真正“用起来”,而不仅仅是“跑通demo”

它不仅是工具,更是开源AI实践精神的体现。

数据统计

相关导航

alphaXiv

WriteHERE

PageLM

AI Red Lines(AI红线)

Miro

AI Student Pack

Pruna AI