在大模型时代,长上下文能力已成为衡量语言模型智能水平的关键指标之一。然而,运行支持 100k 甚至更长上下文的 LLM(如 Llama-3.1-8B-Instruct 或 Qwen3-next-80B),通常需要昂贵的多卡集群和数百 GB 显存。

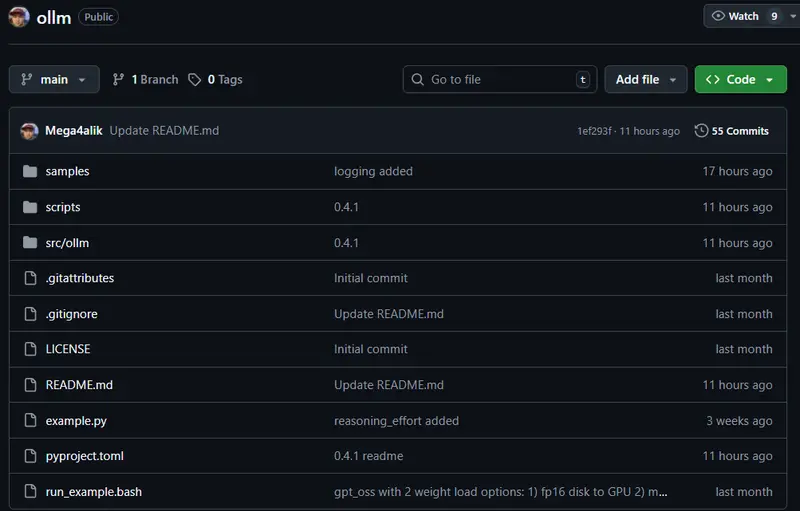

现在,一个名为 oLLM 的开源项目正试图打破这一门槛。

这是一个基于 Hugging Face Transformers 和 PyTorch 构建的轻量级 Python 库,专为大型上下文离线推理工作负载设计。它使得在仅配备 8GB VRAM 消费级显卡(如 RTX 3060 Ti)的设备上运行 100k 上下文的 LLM 成为可能——成本低至约 200 美元硬件投入,且无需量化,全程使用 fp16/bf16 原生精度。

✅ 核心优势:不牺牲精度,也不依赖高端硬件。

最新进展:v0.4.1 版本重磅更新

oLLM 团队近期发布了 v0.4.1,带来多项关键改进:

.safetensors文件不再通过mmap加载,避免占用额外 RAM 页面缓存;- 新增对 qwen3-next-80B 的完整支持,包括 DiskCache 机制;

- qwen3-next-80B(160GB 模型)实现 1 token / 2 秒 吞吐,成为目前 oLLM 支持的最快大型模型;

- 将 Llama3 自定义分块注意力替换为 FlashAttention-2,提升稳定性和效率;

- 为 gpt-oss-20B 实现类 FlashAttention 机制,显著降低 VRAM 占用;

- 引入 分块 MLP 技术,在处理中间投影层时进一步节省显存。

这些优化共同推动了“本地化、低成本、高上下文”推理的可行性边界。

如何实现?核心技术解析

oLLM 并未依赖传统的量化或 PagedAttention 技术,而是通过一系列系统级工程创新,在有限资源下完成高效推理:

1. 层级权重按需加载(SSD → GPU)

模型各层的权重不会一次性全部载入内存,而是根据计算需求从 SSD 直接流式加载到 GPU,极大减少初始显存压力。

2. KV 缓存卸载至 SSD

在长上下文场景中,KV 缓存可轻易超过几十 GB。oLLM 将其直接写入高速 SSD,并在需要时动态读回 GPU,避免内存爆炸。

3. 分层卸载策略

支持将部分层权重临时卸载至 CPU 内存,形成“GPU + CPU + SSD”三级存储协同机制,灵活应对不同硬件配置。

4. FlashAttention-2 + 在线 Softmax

完整注意力矩阵永不实例化,所有计算在线完成,大幅节省显存并提升数值稳定性。

5. 分块 MLP(Multi-Layer Perceptron)

对于中间激活值巨大的前馈网络层,采用分块处理方式,防止显存峰值溢出。

实测显存表现(RTX 3060 Ti, 8GB VRAM)

| 模型 | 权重大小 (bf16/fp16) | 上下文长度 | KV 缓存 | 基线 VRAM(无卸载) | oLLM 实际 GPU 显存 | 所需 SSD 空间 |

|---|---|---|---|---|---|---|

| qwen3-next-80B | 160 GB | 50k | 20 GB | ~190 GB | ~7.5 GB | 180 GB |

| gpt-oss-20B | 13 GB | 10k | 1.4 GB | ~40 GB | ~7.3 GB | 15 GB |

| llama3-1B-chat | 2 GB | 100k | 12.6 GB | ~16 GB | ~5.0 GB | 15 GB |

| llama3-3B-chat | 7 GB | 100k | 34.1 GB | ~42 GB | ~5.3 GB | 42 GB |

| llama3-8B-chat | 16 GB | 100k | 52.4 GB | ~71 GB | ~6.6 GB | 69 GB |

💡 “基线”指传统推理方式下所需总内存;而 oLLM 通过卸载机制,将 GPU 显存控制在 8GB 以内。

典型应用场景

oLLM 特别适合需要一次性处理超长文本的离线任务,例如:

- 分析整份法律合同、合规报告或政策文件;

- 从海量患者病历或医学文献中提取关键信息;

- 本地化处理大型日志文件、安全威胁报告;

- 对历史客服对话进行归纳,识别高频问题;

- 学术研究中对长篇论文或书籍内容的理解与摘要。

这些任务往往不要求实时响应,但对上下文完整性要求极高——正是 oLLM 的最佳用武之地。

入门指南

建议使用虚拟环境安装:

python3 -m venv ollm_env

source ollm_env/bin/activate

安装方式任选其一:

方法一:pip 安装

pip install ollm

方法二:源码安装(推荐)

git clone https://github.com/Mega4alik/ollm.git

cd ollm

pip install -e .

pip install kvikio-cu12 # 根据 CUDA 版本选择,如 cu118/cu121

⚠️ 注意:若使用

qwen3-next系列模型,需安装 Transformers 开发版:pip install git+https://github.com/huggingface/transformers.git

支持的 GPU 架构

oLLM 支持以下 NVIDIA 显卡系列:

- Ampere:RTX 30xx, A30, A4000, A10

- Ada Lovelace:RTX 40xx, L4

- Hopper 及更新架构:H100

只要具备至少 8GB 显存,即可运行大多数模型。

数据统计

相关导航

Codi

Droidrun

MyHair

LangChain4j

Signex

Viven

PandaWiki