CodeArena

CodeArena 是一个面向开发者和 AI 研究者的开源工具,它不仅为开源编码模型提供了一个公平竞技的舞台,也为社区提供了一个可视化、可交互、可部署的模型评估平台。随着越来越多的模型加入,CodeArena 有望成为开源编程模型领域的重要参考工具。

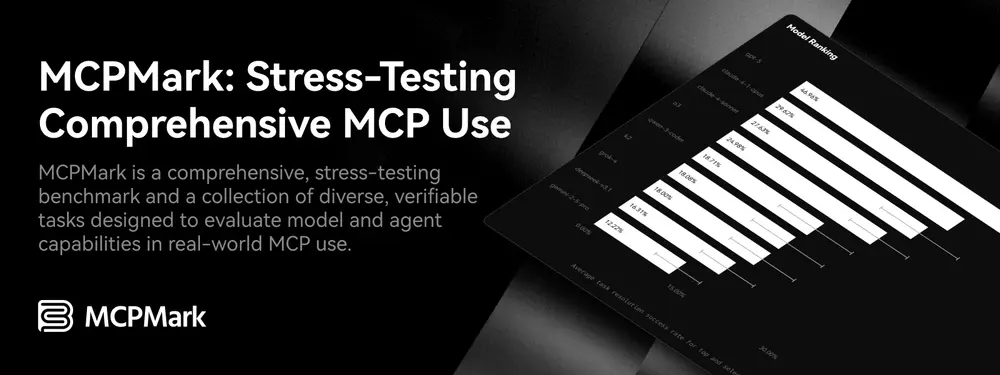

在大模型向“智能体”(Agent)演进的过程中,衡量其在真实工具环境中的上下文协议交互能力(MCP)变得至关重要。为此, EVALSYS联合LobeHub 推出 MCPMark —— 一个专注于评估大模型Agent能力的综合性基准测试套件。

MCPMark 支持在多个真实服务环境中测试模型的自动化操作能力,涵盖 Notion、GitHub、文件系统、PostgreSQL、Playwright(网页自动化) 等常用工具链,全面检验模型在复杂任务中的规划、执行与容错能力。

随着大模型从“回答问题”转向“完成任务”,其与外部系统的交互能力成为关键指标。传统的语言理解或代码生成基准已无法充分反映模型在真实工作流中的表现。

MCPMark 的目标是:

所有实验均在沙箱中完成,结束后自动销毁环境,确保不干扰用户现有配置或泄露敏感信息。

目前已集成以下 MCP 服务:

未来将持续扩展更多企业级工具支持。

每个实验运行在独立的运行时环境中,依赖容器化或虚拟环境隔离资源,保障系统安全与数据隐私。

若实验因网络中断、状态冲突等临时错误中断,MCPMark 支持断点续跑:

State Duplication Error 或 MCP Network Error 导致失败的步骤;所有实验结果以标准格式保存至 ./results/ 目录:

通过简单命令即可生成可视化报告:

python -m examples.results_parser --exp-name new_exp --mcp notion

该命令将:

summary_{SERVICE}.png,存放于对应实验目录旁,便于归档与对比。通过 pip 安装:

pip install mcpmark

或使用 Docker 镜像获取完整运行环境(推荐)。

.mcp_env 文件,格式如下:

GITHUB_TOKEN=your_github_token

NOTION_TOKEN=your_notion_token

# 评估所有任务

python -m pipeline --exp-name new_exp --mcp notion --tasks all --models o3

# 评估特定任务组(如 online_resume)

python -m pipeline --exp-name new_exp --mcp notion --tasks online_resume --models o3

# 评估单个任务

python -m pipeline --exp-name new_exp --mcp notion --tasks online_resume/task_1 --models o3

# 多模型对比测试

python -m pipeline --exp-name new_exp --mcp notion --tasks all --models o3,gpt-4.1

# 运行单一服务的所有任务

./run-task.sh --mcp notion --models o3 --exp-name new_exp --tasks all

# 跨服务综合基准测试

./run-benchmark.sh --models o3,gpt-4.1 --exp-name new_exp --docker

更多参数说明详见官方 Quick Start 和 Task Page

MCPMark 兼容主流前沿模型,便于横向对比:

| 组织 | 支持模型 |

|---|---|

| OpenAI | gpt-4o, gpt-4.1, gpt-4.1-mini, gpt-5, gpt-5-mini, gpt-5-nano, o3, o4-mini |

| xAI | grok-4 |

| gemini-2.5-pro, gemini-2.5-flash | |

| Anthropic | claude-3-7-sonnet, claude-4-sonnet, claude-4-opus |

| DeepSeek | deepseek-chat, deepseek-reasoner |

| Moonshot | k2 |

新增模型可通过标准接口接入,支持自定义 MCP 服务扩展。