autoresearch

autoresearch是一个仅由 630 行代码 构成的单文件奇迹,正在重新定义 AI 研究的范式:不再是人类训练模型,而是人类指挥 AI 去训练和优化模型。

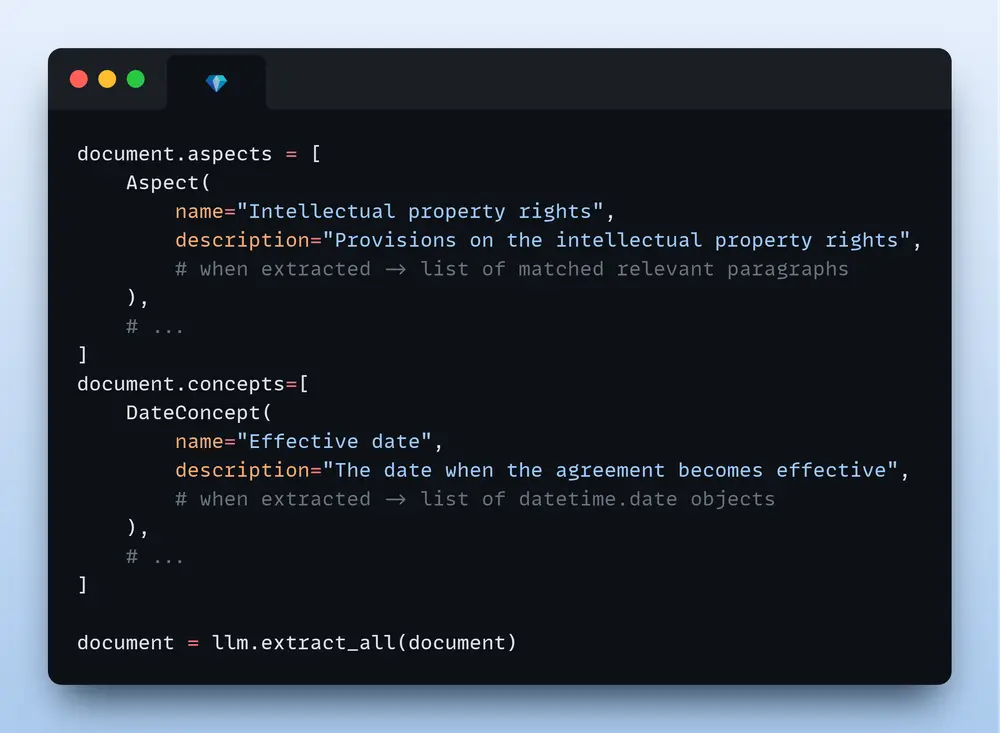

ContextGem 是一款免费且开源的大语言模型(LLM)框架,旨在简化从文档中提取结构化数据和洞察的过程。无论是合同中的关键条款、报告中的重要数据,还是论文中的核心观点,ContextGem 都能通过最少的代码完成复杂任务,帮助用户高效精读文档。

相比其他流行的 LLM 框架,ContextGem 提供了更高的灵活性和更低的开发复杂度。以下是其核心优势:

| 功能 | ContextGem | 其他 LLM 框架 |

|---|---|---|

| 内置抽象 | 🟢 | ◯ |

| 自动化动态提示 | 🟢 | ◯ |

| 自动化数据建模和验证器 | 🟢 | ◯ |

| 精确的粒度参考映射(段落和句子) | 🟢 | ◯ |

| 推理依据(支持提取的理由) | 🟢 | ◯ |

| 神经分割(SaT) | 🟢 | ◯ |

| 多语言支持(无需提示的输入/输出) | 🟢 | ◯ |

| 单一、统一的提取管道 | 🟢 | 🟡 |

| 按角色分组的 LLM 执行特定任务 | 🟢 | 🟡 |

🟢 - 完全支持

🟡 - 部分支持

◯ - 不支持

ContextGem 提供内置转换器,支持多种文件格式的处理,包括 DOCX 文件。

ContextGem 专为单文档分析设计,充分利用 LLM 的长上下文窗口来实现卓越的提取准确性。相比于 RAG 方法在处理复杂概念时可能遇到的困难,ContextGem 能够直接从完整文档中提取信息,避免了检索不一致性问题。

注意:对于跨文档查询或语料库检索的需求,现代 RAG 系统(如 LlamaIndex、Haystack)仍是更好的选择。

ContextGem 通过 LiteLLM 集成支持多种云端和本地 LLM:

此外,ContextGem 提供统一的 API 接口,便于切换不同 LLM 提供商。