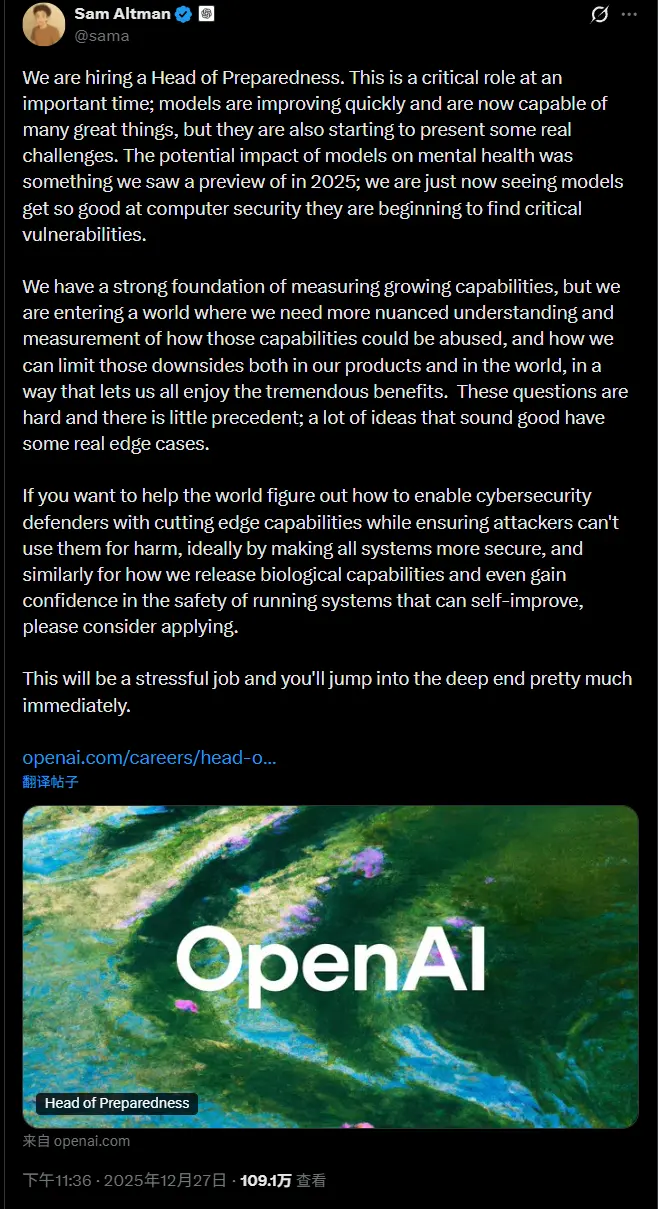

OpenAI 正在寻找新的备灾负责人(Head of Preparedness)

OpenAI 正寻求聘请一名新的高管,负责研究从计算机安全到心理健康等领域中出现的、与人工智能相关的风险。

首席执行官 Sam Altman 在 X 上的一篇帖子中承认,AI 模型正“开始带来一些真正的挑战”,包括“模型对心理健康的潜在影响”,以及那些“因过于精通计算机安全而开始发现关键漏洞”的模型。

“如果你想帮助世界寻找方法,在赋能网络安全防御者尖端能力的同时,确保攻击者无法利用这些能力行恶——理想情况是通过让所有系统变得更安全来实现;如果你同样想研究我们如何发布生物能力,甚至如何对运行中的自我改进系统的安全性建立信心,请考虑申请,”Altman 写道。

OpenAI 的备灾负责人职位列表将该工作描述为负责执行公司的备灾框架(Preparedness Framework),即“解释 OpenAI 如何跟踪和准备应对那些会产生严重伤害风险的前沿能力的方法框架”。

该公司于 2023 年首次宣布成立备灾团队,表示该团队将负责研究潜在的“灾难性风险”,无论这些风险是更紧迫的(如网络钓鱼攻击),还是更具推测性的(如核威胁)。

不到一年后,OpenAI 将备灾负责人 Aleksander Madry 调任至一个专注于 AI 推理的职位。OpenAI 的其他安全高管也已离开公司,或在备灾和安全之外承担了新的职务。

该公司最近还更新了其《备灾框架》,指出如果竞争对手的 AI 实验室发布了一个没有类似保护措施的“高风险”模型,OpenAI 可能会“调整”其安全要求。

正如 Altman 在帖子中所暗示的,生成式 AI 聊天机器人对心理健康的影响正面临日益严格的审查。最近的诉讼指控 OpenAI 的 ChatGPT 加深了用户的幻想,增加了他们的社交孤立感,甚至导致了一些人的自杀。(该公司表示,它正在继续努力提高 ChatGPT 识别情绪困扰信号的能力,并将用户引导至现实世界的支持服务。)